L’expression : de Hjelmslev à l’analyse computationnelle des larges collections d’images Expression: from Hjelmslev to computational analysis of large image collections

Jean-François Bordron

Université de Limoges

Maria Giulia Dondero

FNRS / Université de Liège

Cet article vise à faire le point sur la notion d’expression et notamment sur l’élément matériel qui la caractérise a minima. Après avoir examiné la relation entre matière et forme et entre image et schématisme, nous prendrons en considération la substance visuelle telle qu’elle est mise à disposition dans les bases de données qui permettent non seulement l’analyse des collections d’images, notamment artistiques, mais aussi la production de nouvelles œuvres via des plateformes de génération d’images telles que Midjourney et Stable Diffusion.

The aim of this article is to provide an overview of the notion of expression, and in particular of the material element that characterizes it at a minimum. After examining the relationship between purport and form, and between image and schematism, we will consider visual substance as it is made available in databases that enable not only the analysis of image collections, particularly artistic ones, but also the production of new works via image generation models such as Midjourney or Stable Diffusion.

Index

Articles des auteurs de l'article parus dans les Actes Sémiotiques : Jean-François Bordron et Maria Giulia Dondero.

Mots-clés : algorithme, art, expression, Open AI, schématisme, substance

Keywords : algorithm, art, expression, Open AI, schematism, substance

Introduction

- Note de bas de page 1 :

-

L’extraction de caractéristiques est une méthodologie utilisée en computer vision en vue de la reconnaissance des formes. L’extraction de caractéristiques discriminantes, par exemple au sein d’une collection de tableaux, est une étape fondamentale du processus de reconnaissance, préalable à la classification des tableaux. Ces caractéristiques peuvent coïncider avec ce que l’on appelle en sémiotique les catégories plastiques du plan de l’expression des textes.

- Note de bas de page 2 :

-

L’apprentissage profond est une technique du machine learning qui se base sur le modèle des réseaux neurones qui vise à mimer le processus d’apprentissage du cerveau humain. Il est particulièrement utilisé dans le traitement ou reconnaissance d’images et particulièrement efficace lorsqu’il s’agit de traiter de données très massives.

Cet article vise à faire le point sur la notion d’expression et notamment sur l’élément matériel qui la caractérise a minima. Tout d’abord, nous allons revenir sur la relation entre matière et forme et entre image et schématisme ; ensuite nous prendrons en considération la substance visuelle des images numérisées et contenues dans les bases de données, lesquelles se prêtent non seulement à l’analyse computationnelle via la feature extraction (extraction de caractéristiques)1 ou via les méthodes liées au deep learning (apprentissage profond)2, mais aussi à servir de sources pour la génération de nouvelles images via des plateformes telles que Midjourney et Stable Diffusion.

Commençons par rappeler ce que l’on entend par expression dans le cadre de la sémiotique hjelmslevienne. Dans le contexte d’une fonction sémiotique, la notion d’expression ne peut se comprendre que dans son rapport à celle de contenu. Hjelmslev est particulièrement clair sur ce point :

- Note de bas de page 3 :

-

Hjelmslev, [1943] 1971, p. 79.

Les termes mêmes de plan de l’expression et de plan du contenu et, de façon plus générale, d’expression et de contenu, ont été choisis d’après l’usage courant et sont tout à fait arbitraires. De par leur définition fonctionnelle, il est impossible de soutenir qu’il soit légitime d’appeler l’une de ces grandeurs d’expression et l’autre contenu et non l’inverse. Elles ne sont définies que comme solidaires l’une de l’autre et ni l’une ni l’autre ne peuvent l’être plus précisément. Prises séparément, on ne peut les définir que par opposition et de façon relative, comme fonctifs d’une même fonction qui s’opposent l’un à l’autre.3

Mais, quel que soit l’arbitraire des dénominations, on doit reconnaître que, prise en elle-même, l’expression comporte toujours un élément matériel dont la nature et l’articulation propre dans la sémiose restent largement problématiques. Il va de soi qu’un plan d’expression au sens strict peut être composé d’une sémiose entière et donc comporter un contenu. C’est le cas évident dans la connotation. L’inverse peut également se produire si l’on pense au métalangage pour lequel une sémiose joue le rôle d’un contenu. Mais dans tous les cas l’élément matériel est nécessaire et c’est lui que nous allons interroger.

Dans cette première partie, nous suivrons deux types d’interrogations. La première demande simplement ce que recouvre la notion de matière dans son usage sémiotique. La seconde s’enquiert de la façon dont un contenu de sens peut trouver dans un matériau particulier la matière nécessaire à son expression.

1. Matière et forme

- Note de bas de page 4 :

-

Aristote, 1966, I, 190, b, 7.

La matière est difficile à définir autrement que dans son rapport à la forme : « En effet, le rapport de l’airain à la statue ou du bois au lit, ou en général de la matière et de l’informe à ce qui a forme, antérieurement à la réception et possession de la forme, tel est le rapport de la matière à la substance, à l’individu particulier, à l’être »4.

Dans son commentaire de la théorie aristotélicienne de la science G. G. Granger écrit :

- Note de bas de page 5 :

-

Granger 1976, p. 268.

De ce point de vue, la matière n’est pas à proprement parler un concept de la physique, mais plutôt un trans-concept de la métaphysique ; elle s’applique à tout être en général en tant que doué, ou susceptible d’être doué, d’individuation à quelque degré. Son caractère fondamental et alors l’indétermination (par exemple, Phys. IV, 2, 209 b 9)5.

- Note de bas de page 6 :

-

Aristote, II, 194, b, 1966. Il est intéressant de remarquer qu’en histoire de l’art, l’intrication entre la virtualité de la matière et le processus qui l’amène à se déterminer en tant que forme est décrite par Focillon dans son œuvre séminale Vie des formes de 1934, notamment dans son chapitre sur la technique, où il affirme que chaque forme garde en mémoire la matière entendue comme sa destinée et vice-versa. En effet, selon Focillon, les matières comportent une certaine destinée, voire « une certaine vocation formelle » (1934, p. 63), comme d’ailleurs la forme a une certaine vocation matérielle ; cette double destinée est intégrée dans les mouvements de la production de l’œuvre.

Bien sûr cette conception est sensiblement différente du sens que prend ce mot dans la physique d’aujourd’hui qui pense plutôt en termes de masse et d’énergie. Mais, du point de vue phénoménologique, il nous semble que la matière se donne paradoxalement à la fois comme une source de résistance pour nos actes et en même temps comme indéterminée quant à sa nature. Si l’on imagine mal une forme sans matière, il paraît encore plus difficile de concevoir une matière sans forme. L’informe ne semble pas pouvoir être autre chose que la limite extrême de la matière lorsque celle-ci devient impossible à nommer. Ainsi matière et forme ne semblent pas pouvoir exister l’une sans l’autre. C’était du moins l’opinion d’Aristote : « En outre la matière est un relatif, car autre matière, autre forme »6.

Le point qui, selon nous, offre la plus grande complexité est qu’il est pratiquement impossible de montrer la matière sans montrer une forme derrière laquelle la matière disparaît. Si, comme Aristote, nous pensons dans le cadre d’une conception hylémorphique des réalités du monde, la différence entre l’airain et la statue est claire. Mais cette évidence se fonde sur la phénoménologie de notre perception. Par contre, d’un point de vue sans doute plus moderne, aussi loin que l’on puisse pousser l’analyse du monde physique, on rencontre toujours des entités qui possèdent une forme. Personne ne dira que les composants d’un matériau comme l’airain sont sans forme. Peut-on dire qu’un électron ou un photon sont informes ? De la sorte, l’informe disparaît assez vite de notre conception des choses car même la particule la plus élémentaire ne peut être dite informe. Le rapport matière/forme ne se dissout pas pour autant, mais se révèle précisément comme étant uniquement un rapport dont l’un des termes semble disparaître dès que l’on cherche à le saisir. Mais ce qu’une forme requiert comme matière peut devenir à son tour forme pour une autre matière. Matière et forme ne sont pas dans une opposition simple dans laquelle les deux termes seraient pour ainsi dire face à face, mais plutôt dans un rapport de dépendance que l’on peut comparer à une rection : la forme régit la matière et non l’inverse. Ou encore : pour qu’il y ait une forme, il faut qu’il y ait une matière. On voit par-là que la matière reste ce qui est essentiellement indéterminé tant qu’elle n’est pas elle-même conçue comme une forme. Il ne s’agit donc pas pour nous de décrire une relation entre matière et forme comprise dans le cadre d’un hylémorphisme, mais plutôt de rechercher les formes inhérentes à la matière qui sont, dans leur principe, bien différentes de celles que le sculpteur peut donner au bloc de marbre. Nous sommes donc à la recherche de ce qu’une sémantique, liée à notre esprit, peut trouver dans la matière en vue d’une expression. On peut dire en ce sens que la sémiotique réside toute entière dans cette quête des propriétés expressives que l’esprit peut rencontrer dans la matière. Mais il faut remarquer que dans cette interaction entre notre esprit et la matière, celle-ci n’est pas inerte, mais se comporte au contraire comme une force agissante, comme une virtualité en quête d’une quelconque réalisation. C’est pourquoi l’expression qui résulte de ce rapport est plutôt une entre-expression.

Plusieurs conséquences peuvent être tirées de ces premières remarques :

- Note de bas de page 7 :

-

Le terme d’image, qui a pour lui sa grande généralité, désigne dans cette première partie de l’article toute expression possédant un statut iconique, en d’autres termes une certaine stabilité méréologique.

-

La matière possède une vertu factitive. Elle fait penser, ressentir, s’émouvoir, rêver, et pour toutes ces raisons est essentielle aussi bien à nos expressions esthétiques que notionnelles.

-

La fonction sémiotique dépend essentiellement de la perception. Ceci est vrai pour le langage, l’image, la musique, le goût, etc. L’interaction entre nos sens et la matière se déploie selon une genèse dont la première manifestation prend la forme d’une image7. C’est cette image qui accueillera, comme nous le verrons, les formes symboliques.

-

Il est essentiel de distinguer la matière, avec ses immenses virtualités, de ce que Hjelmslev a appelé la substance. La substance est la matière constituée en vue de porter une forme d’expression. Matière, dans les Prolégomènes est traduit par sens et correspond à l’anglais purport. Il nous semble que le terme de matière, si l’on entend par là la matière physique, convient aussi bien pour désigner le niveau primaire de l’expression que celui du contenu. Ainsi entendue, la matière est bien, comme nous essayons de le comprendre, cette espace de virtualités dans lequel il s’agit de constituer ce qui pourra servir à donner forme à une expression. En elle-même, une matière colorée n’est pas un phénomène sémiotique. Elle ne le devient que si elle est perçue comme habitée par la possibilité d’une forme, c’est-à-dire comme une substance.

- Note de bas de page 8 :

-

Dans ce texte, nous utilisons deux notions d’image, celle a priori, qui permet de concevoir le résultat de toute forme de schématisme, et l’image spatiale, encadrée, exposée au regard telle que celle artistique, qui possède une vie autonome au sein de la société.

- Note de bas de page 9 :

-

Voir Wismann 2010.

Notre insistance sur la question de la matière rend nécessaire une réflexion ontologique, même brève. On croit souvent que la question ontologique en sémiotique relève du problème de la dénotation ou de la référence. Il est au contraire nécessaire de comprendre que le problème ontologique est d’abord lié à la question de l’expression (ce qui n’exclut pas les problèmes de l’objectivation). Qu’y a-t-il dans la réalité qui s’offre comme une ressource en vue d’une expression possible ? La réponse ne peut consister à dire : il y a ceci ou cela. Il faut plutôt considérer que nous n’avons pas d’autre possibilité que celles offertes par la réflexion sur notre propre perception. Or celle-ci, comme nous venons de le voir, ne nous dit pas ce qu’est la matière, mais qu’elle est, selon toutes ses variations, une hypothèse que nous ne pouvons pas ne pas faire. En d’autres termes, elle est une condition de possibilité de nos expériences sensibles et non une positivité dont nous pourrions affirmer dogmatiquement l’existence. Nous verrons plus loin qu’elle ne peut en outre être conçue en dehors de l’espace et du temps, ces trois composantes formant ainsi une image a priori qui se trouve par-là être la forme de toutes les images8. Retenons pour l’instant que l’ontologie dont nous parlons n’est rien d’autre que la forme de ce qui peut nous être donné dans l’expérience et qui en ce sens relève d’une anticipation toujours nécessaire. En ce sens, il serait plus juste de parler de préforme. L’ontologie est formelle en ce sens, car en attente de toute détermination. Le passage de l’indéterminé à la détermination est le problème fondamental de la matière. Déjà les atomistes grecques voyaient dans la chute des atomes, soumis au clinamen, la possibilité de générer des formes et donc de déterminer ce qui ne l’était pas à son origine9.

- Note de bas de page 10 :

-

Simondon 2014.

L’image correspond à cette idée de forme déterminée, mais aussi déterminante. Nous emprunterons la notion d’image a priori à Simondon10. Résumons-en le principe général. Lors de la perception d’un objet inconnu, nécessairement singulier, il est nécessaire que certains schèmes, que G. Simondon dit être a priori, anticipent la forme objet pour que, par ajustements successifs, une première connaissance puisse s’établir. En un second temps, ce savoir nouvellement acquis s’inscrit dans la mémoire de telle sorte qu’il puisse être utilisé lors de nouvelles expériences, réelles ou imaginaires. Ainsi s’initie un cycle qui enrichit peu à peu notre connaissance et notre imagination.

Résumons notre démarche : nous comprenons la question de l’ontologie comme une interrogation portée sur le lieu à partir duquel nous pouvons imaginer une expression aussi bien de nos pensées, de nos désirs, de nos passions. Le point de départ, offert par la triade que constituent le temps, l’espace et la matière est formel et représente une puissance encore virtuelle, mais destinée à être schématisée et par là à engendrer la multiplicité des images qui peuvent illustrer la rencontre entre le monde et nos divers sens.

2. Images et schématisme

Il nous faut maintenant faire des hypothèses sur la façon dont un contenu peut venir se lier à un plan d’expression. Une de ces hypothèses est le schématisme dont nous rappellerons brièvement l’origine est le fonctionnement. Notre intention est de montrer l’importance des procédures qui nous lient à la matière aussi bien du point de vue de la genèse de nos expressions que des recherches d’objectivation.

On attribue généralement l’origine de la notion de schème à E. Kant. D’autres sources peuvent s’y rattacher comme les diagrammes de Peirce, les schémas de Bergson ou encore la théorie de l’invention de Simondon. Le schème est un troisième terme qui doit être d’une part homogène aux catégories et d’autre part aux phénomènes quant à leur forme. Il faut donc que le schème soit d’un côté intellectuel, de l’autre sensible. On voit par-là que le problème est de même type que notre question directrice : comment un contenu sémantique vient-il s’exprimer par une matière, celle-ci étant, comme nous l’avons souligné, conçue formellement au même titre que l’espace et le temps ?

- Note de bas de page 11 :

-

Kant, 1967, p. 152.

Le schème est de ce fait défini par Kant comme « la représentation d’un procédé général de l’imagination pour procurer à un concept son image […] »11. Chez Kant comme chez ses successeurs, les schèmes sont des producteurs d’images. De ce fait ils offrent une voie essentielle pour expliquer les rôles des trois composants de l’image que sont le temps, l’espace et la matière.

Le schématisme kantien, tel qu’il est présenté dans la première critique, établit une expression des catégories sur la forme du sens interne, c’est-à-dire sur le temps. Le but est de concevoir une structuration a priori de l’objectivité sur la base des catégories. Nous ne donnerons de ce schématisme qu’un seul exemple. Notre démarche consiste à comprendre la possibilité d’un schématisme qui ne se fonde pas seulement sur les catégories rapportées au temps, mais sur toutes les notions qui peuvent se schématiser sur le temps, mais aussi sur l’espace et la matière. Par notions nous entendons tous les composants sémantiques schématisables aussi bien comme image picturale que comme image sonore, gustative, etc. finalement toutes les significations qui peuvent trouver une expression iconique. Redisons, pour rendre le problème le plus clair possible, que nous comprenons le temps, l’espace et la matière comme des conditions formelles qui rendent possible notre rapport au monde. Ces conditions sont les formes a priori de notre intuition. Elles valent comme ontologie formelle, cette dernière étant ainsi une puissance d’image et donc ultimement de formes.

Le premier exemple est celui du nombre. Quand je dispose cinq points à la suite les uns des autres, c’est là une image du nombre cinq. Kant ajoute :

- Note de bas de page 12 :

-

Kant, 1967, p, 170.

Au contraire, quand je ne fais que penser à un nombre en général, qui peut être cinq ou cent, cette pensée est la représentation d’une méthode pour représenter une multitude (par exemple mille) dans une image, conformément à un certain concept plutôt que cette image même, qu’il me serait difficile, dans le dernier cas de parcourir des yeux et de comparer au concept.12

Il faut donc distinguer le schème comme méthode et l’image comme résultat. Un premier point est à considérer : quelles images peut-on construire si nous nous trouvons dans la situation où une image paraît d’abord impossible ?

- Note de bas de page 13 :

-

Kant, 1974, p. 173.

Afin d’exposer la réalité de nos concepts, des intuitions sont toujours nécessaires. S’il s’agit de concepts empiriques, les intuitions s’appellent exemples. S’il s’agit des concepts purs de l’entendement, on les nomme schèmes. Mais exiger que l’on montre la réalité objective des concepts de la raison, c’est-à-dire des Idées, et cela en vue de la connaissance théorique de celles-ci, c’est là désirer quelque chose d’impossible, puisqu’on ne peut absolument pas leur donner une intuition qui leur soit adéquate13.

Dans ce cas, Kant propose l’hypotypose comme moyen pour construire une image. Ainsi, dit-il, un moulin à bras peut assez bien être l’image d’un état despotique. Plus généralement, l’allégorie est une figure apte à imager des idées abstraites. Il en est ainsi de La liberté guidant le peuple de Delacroix (1830, Louvre).

Regardons maintenant l’image la plus abstraite, telle qu’elle est schématisée à partir des catégories vers notre intuition du temps. Il s’agit en réalité d’une préforme susceptible d’anticiper les images spatiales, sur lesquelles se focalisera la deuxième partie de notre texte. Mais, pris dans leur origine, les schèmes sont « des déterminations du temps a priori » que nous exposerons, en suivant Kant, selon l’ordre des catégories.

- Note de bas de page 14 :

-

Kant 1967, p, 172.

- Note de bas de page 15 :

-

Kant, 1967, p. 180.

Le schème de la quantité est le nombre : « Ainsi le nombre n’est autre chose que l’unité de la synthèse opérée dans le divers d’une intuition homogène en général, par le fait même que je produis le temps lui-même dans l’appréhension de l’intuition »14. Il rend ainsi « représentable » la production ou synthèse du temps lui-même « dans l’appréhension nécessaire d’un objet ». Il concerne donc la série du temps et a pour expression le principe synthétique dit « axiomes de l’intuition » : « Tous les phénomènes, au point de vue de leur intuition, sont des grandeurs extensives »15.

- Note de bas de page 16 :

-

Kant, 1967, p. 181.

- Note de bas de page 17 :

-

Kant, 1967, p. 182.

- Note de bas de page 18 :

-

Kant, 1967, p. 183.

- Note de bas de page 19 :

-

Idem.

- Note de bas de page 20 :

-

Idem.

- Note de bas de page 21 :

-

Idem.

- Note de bas de page 22 :

-

Idem.

-

Le schème de la qualité et de ses catégories (réalité, négation, limitation) est la « continuelle et uniforme production de la réalité dans le temps, où l’on descend dans le temps de la sensation qui a un certain degré jusqu’à son entier évanouissement, ou bien où l’on s’élève peu à peu de la négation de la sensation à une quantité de cette même sensation »16. Comme détermination du temps le schème de la qualité correspond au contenu du temps. Comme principe il est « anticipation de la perception » et s’énonce : « Dans tous les phénomènes, la sensation et le réel qui lui correspond dans l’objet (realitas phaenomenon) ont une grandeur intensive c’est-à-dire un degré »17.

-

Les schèmes de la catégorie de relation déterminent le temps selon un ordre et rendent ainsi représentable le rapport des perceptions les unes par rapport aux autres en tout temps.

-

Le schème de la substance est la « permanence du réel dans le temps » ; celui de la causalité « le réel qui, une fois posé arbitrairement, est toujours suivi de quelque autre chose »18 ; celui de la communauté, la détermination réciproque et simultanée des substances et de leurs accidents.

-

Les schèmes de la catégorie de modalité présentent « le temps lui-même, en qualité de correlatum de la détermination d’un objet, sur la question de savoir si et comment il appartient au temps ».19 Ainsi le schème de la possibilité est-il « l’accord de la synthèse de différentes représentations avec les conditions du temps en général (comme, par exemple, que les contraires ne peuvent exister en même temps dans une chose, mais seulement l’un après l’autre) ».20

-

Le schème de la réalité « est l’existence dans un temps déterminé ».21

-

Le schème de la nécessité « est l’existence d’un objet en tout temps »22.

- Note de bas de page 23 :

-

Voir à ce propos Groupe µ (1998). Voir aussi Petitot (2004) sur le groupe du Laocoon et la temporalité entendue comme une forme de l’intuition secondaire dans une image fixe telle que la statuaire et Dondero (2020) sur l’analyse de l’aspectualité dans l’image fixe et notamment dans le cas du portrait.

Le parcours trop rapide que nous venons d’accomplir autour de la notion de schématisme avait un seul but : il s’agissait de montrer à quel point toute sémiose est avant tout une mise en forme du temps. Dans ce qui précède, les schèmes prennent leur origine dans les catégories. Mais le raisonnement est le même si nous partons d’autres notions, qu’elles soient empiriques ou idéales. Les schèmes temporels, ou plutôt les images temporelles dessinées par les schèmes, sont les fondements de toutes les formes spatiales ou matérielles. On admettra sans doute facilement qu’il en aille ainsi pour la parole ou pour la musique dont les rythmes, les mélodies, les jeux d’intensité et d’extension reposent à l’évidence sur des formes temporelles. Mais l’image étant en général comprise selon le seul motif de la spatialité, il est plus rare d’y décrire des formes temporelles si l’histoire (historia) n’y conduit pas23.

Prenons comme exemple un tableau intitulé Painterly Architectonic (1917) (Figure 1), de Lioubov Popova, artiste russe qui a appartenu aux courants constructivistes puis suprématistes.

Du point de vue du temps, cette œuvre nous fait éprouver la simultanéité des formes (leur superposition progressive) et leur présence commune qui entrent en conflit. Ce conflit est produit en raison de la coprésence du premier plan blanc et d’autres plans s’enfonçant par étapes vers le temps vide de l’arrière-plan. On éprouve donc à la fois le sens de la permanence (fond), la succession (les étapes de l’arrière au fond et vice-versa) et la simultanéité (la superposition) qui sont les trois caractéristiques, comme nous l’avons vu, qui définissent le temps comme ordre. On remarquera que cette ordonnance correspond, du point de vue de l’intuition du temps, à ce qu’est l’architectonique pour l’espace qui donne son titre au tableau. On remarquera de la même façon que les couleurs, homogènes et continues sur les surfaces, s’opposent à la multiplicité des angles, tous dissemblables. On retrouve donc l’unité et la multiplicité dans la série du temps. Bien d’autres traits importants suggèrent un mouvement, une dynamique, comme l’unique trait courbe de la surface grise et, à l’évidence, les orientations si diverses des angles évoquant une grande agitation au cœur même d’un présent immobile.

Figure 1. Lioubov Popova, Painterly Architectonic, 1917.

Cette analyse, trop courte pour cerner totalement le sens de cette œuvre, cherche simplement à montrer que son plan d’expression, radicalement spatial d’apparence, ne peut se passer, pour être compris, de notre intuition du temps. Cette temporalité lui appartient en propre et participe à la constitution de sa forme et de son sens.

La question de la matière, nous l’avons souligné, est celle de la détermination. Celle-ci est double. Il s’agit d’abord de l’individuation, le fait d’être spécifiquement quelque chose. D’autre part, sans exclure les formes à la fois spatiales et temporelles, il est nécessaire de faire un bref inventaire des qualités sensibles, c’est-à-dire ce qui se présente à nous avec une certaine intensité et une certaine extension.

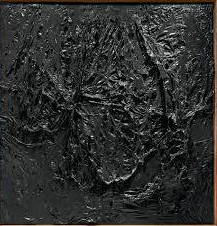

Si nous observons les peintures appartenant à un courant matiériste, notamment cette œuvre d’Alberto Burri ayant pour titre Nero plastica (1963) (Figure 2), il peut d’abord sembler que le terme de schème, utilisé en vue de la constitution des formes temporelles et spatiales, est étrange.

Figure 2. Alberto Burri, Nero plastica, 1963.

- Note de bas de page 24 :

-

Platon, Sophiste, 247c. L’étranger : « Je dis que ce qui possède une puissance, quelle qu’elle soit d’agir sur n’importe quelle autre chose naturelle, soit de pâtir – même dans un degré minime, par l’action de l’agent le plus faible, et même si cela n’arrive qu’une seule fois – tout cela, je dis, existe réellement ».

Ce genre de peintures relève plutôt de ce que l’on peut appeler une tectonique, au sens utilisé en géologie. Ainsi voit-on la rencontre de masses, des failles, des brusques élévations, des craquelures, des plis, etc. La matière reçoit des formes très différentes dans leur principe de celles propres au temps et à l’espace. La notion essentielle est ici celle de puissance, qui en même temps agit et subit. La puissance fait apparaître la matière au même sens où les catégories font percevoir le temps et l’espace. Ce double registre de l’agir et du pâtir est sans doute la raison qui nous fait concevoir la matière comme un signe d’existence24.

Nous avons parcouru deux chemins pris par la sémiose. Le premier, sur la base de la perception, consiste à rechercher un sens à partir des signifiants produits par l’interaction entre le monde et nos organes sensibles. On comprend que dans ce cas les signifiants précèdent les signifiés. La perception peut, en ce sens, être dite théorisante puisqu’elle est à la recherche de l’Idée.

Le second au contraire part du sens pour rechercher des signifiants qui lui correspondent. C’est le rôle de la schématisation. Dans ce cas les signifiés précèdent. Le chemin est celui de la création, il est poétisant (au sens de poïétique).

Un exemple illustre simplement les orientations différentes de ces deux chemins de la sémiose. Si l’on imagine Cézanne contemplant la montagne Sainte Victoire ou Messiaen écoutant le chant des oiseaux, on comprend qu’ils sont tous les deux à la recherche de l’Idée. Mais si, au contraire, on les imagine l’un peignant, l’autre composant, on comprend alors qu’ils sont à la recherche de signifiants pour exprimer leurs pensées. Ainsi la perception, surtout sur son mode contemplatif, suit un chemin opposé à celui de la création.

Il est presque inutile de dire à quel point ces deux chemins sont inséparables et s’enlacent sans cesse. La perception est toujours une création sous un certain aspect et la création ne peut se passer de perception. La pratique artistique lie ensemble ces deux voies, et il en va probablement ainsi de toute pratique (praxis). La pratique est dialectique, conformément au jeu des contraires que ce terme a depuis toujours eu pour fonction de désigner.

3. Numériser la peinture : d’une substance à l’autre

- Note de bas de page 25 :

-

Sur le faire et les techniques d’un point de vue sémiotique voir Beyaert, Dondero et Fontanille (2006).

- Note de bas de page 26 :

-

Une des descriptions les plus suggestives de la façon dont on choisit le bois pour l’icône sainte et on le transforme étape par étape se trouve dans Florenskij (1997). Voir aussi des commentaires à cette description d’un point de vue sémiotique dans Dondero (2013) et dans Basso et Dondero (2011).

Qu’en est-il de la matière, de la substance et de la forme lorsque nous abordons des images telles que celles numérisées et contenues dans une base de données qui s’approprie leurs supports originaires et les transforme par ce même geste en des valeurs différentielles faites de nombres ? Qu’en est-il de la matière des peintures et des fresques, de l’huile, du pigment, du bois, de la paroi dès que toutes ces matières ne sont plus que des collections de nombres, voire des codes faits de successions et de combinaisons diverses de 1 et de 0 ? Tout d’abord, il faut préciser que, dès que nous sommes face à une peinture, nous sommes face à une forme, mais à une forme très particulière qui, notamment dans le cadre de la peinture de l’expressionisme abstrait, du Matiérisme mais de bien d’autres courants artistiques aussi (impressionnisme, divisionnisme, etc.), nous permet d’entrevoir le travail qui a été fait pour accomplir cette forme définitive. Cette forme acquise par l’œuvre peut s’entendre comme le lieu de stabilisation compositionnelle, sur le plan de l’expression, et d’institutionnalisation, sur le plan du contenu – l’œuvre est là pour être exposée et implémentée selon les paramètres de valorisation qui déterminent le monde de l’art –, d’un travail qui peut se résumer sous le terme de « substance ». En effet, la substance, en peinture, coïncide avec tout le processus de transformation que l’on aperçoit seulement dans certaines œuvres (Pollock), et qui est totalement caché dans d’autres (Raffaello) et qui nous permet de remonter à l’acte de production de l’œuvre, et notamment aux techniques25. Nous pouvons concevoir ces techniques comme des actions de détermination et de transformation qui permettent à la matière, et aux matériaux, de s’exprimer, d’extraire d’eux-mêmes ce qu’ils peuvent devenir. Car la matière, telle que le pigment pour la peinture ou la lumière pour la photographie, n’est qu’une abstraction qui attend un acte de traçage et de détermination pour commencer à advenir, à s’individualiser, voire commencer à exister et à s’offrir à la perception et à l’appréhension. Il est donc impossible d’identifier ou de percevoir la matière de la peinture ; nous pouvons néanmoins faire un effort et l’envisager comme, par exemple, du pigment avant qu’il ne soit mis en boîte et utilisé par un pinceau, de l’huile avant qu’il ne soit mélangé aux pigments, du bois avant qu’il ne soit coupé pour devenir une toile et cette dernière avant son traitement destiné à accueillir les gestes du peintre26. Car les gestes du peintre appartiennent au stade de la substance ou, comme il est dit dans Bordron (2012) au stade de l’iconisation qui est caractérisée par un processus de ce genre : « Flux => Inflexion => Parties saillantes => Identification et différentiation => Conjonction et disjonction => Composition et décomposition de parties […] ». Ce processus qui va du flux indéterminé jusqu’à la stabilisation finale traversant les multiples moments de méréologisation de la matière vers la substance se traduit sur le plan du contenu avec un processus qui va du choix des couleurs, du type de bois pour la toile et de l’expression de la sensori-motricité du peintre jusqu’à l’exposition du tableau dans ses formes définitives à un public donné.

Dans sa Vie des formes (1934), Focillon propose des descriptions très sophistiquées de la peinture à l’huile, où il affirme que la couleur peut se glisser sur le support par coulées ou se poser avec fermeté, pénétrer plus ou moins en lui communiquant une qualité sèche ou une qualité grasse (1934, p. 5 et sq).

De la substance font également partie les traitements des supports qui accueillent les pigments et les gestualités, et qui exercent une influence majeure sur les effets lumineux de transparence, de luminosité, de brillance, etc. :

La même forme conserve sa mesure, mais change de qualité selon la matière, l’outil et la main. […] Une forme sans son support n’est pas forme, et le support est forme lui-même. Il est donc nécessaire de faire intervenir l’immense variété des techniques dans la généalogie de l’œuvre d’art et de montrer que le principe de toute technique n’est pas inertie, mais action (Focillon, 1934, p. 25-26, nous soulignons).

- Note de bas de page 27 :

-

Focillon assimile la technique moins à la syntaxe qu’à une physiologie (1934, p. 57) et à un développement biologique (p. 58).

- Note de bas de page 28 :

-

Nous ne reviendrons pas ici sur la question du support matériel et du support formel de l’image (picturale, photographique et nativement numérique) car la littérature en sémiotique est déjà consistante à ce propos. Voir Fontanille (2005), Beyaert-Geslin (2008), Basso Fossali et Dondero (2011), Dondero et Reyes (2016), Dondero (2020).

- Note de bas de page 29 :

-

Focillon (1934) parle de « matière qui résiste » et de « matière contrariée » (p. 73). Une méthodologie d’analyse de ce processus de détermination de la matière est disponible dans Fontanille (2011) où l’auteur aborde la production d’inscriptions, voire d’empreintes (picturales, photographiques, d’écriture) sur les corps des objets.

Ce qui est à retenir est que, dans le processus qui correspond au travail de la substance27, le pigment se décline selon les disponibilités du support ; ces disponibilités, voire ces potentialités font de ce support, comme le dit Focillon, une forme en elle-même ou au moins une pré-forme, voire une disposition à la coïncidence, adaptation ou résistance par rapport à ce que ce support rencontrera comme outil et rythme d’inscription28. Les gestualités aussi sont des substances au sens où elles sont dirigées vers, mais en même temps doivent s’accorder au tout début du processus avec le caractère abstrait caractérisant la « matière d’un pigment » ou la « matière d’un support ». Les pigments et les supports se présentent comme un questionnement sur la suite, en fonctionnant comme une suggestion de développement et, en même temps, comme une résistance à des gestes qui pourraient ne pas être adéquats29.

4. L’image numérisée au sein de la base de données : pour une diagrammatique entre nombres et formes

Que dire du processus à travers lequel tout ce travail de détermination de la matière en une forme artistique stabilisée – laissant transparaître le travail (substance) qui l’a amenée à être ce qu’elle est –, subit une numérisation ? Pensons par exemple au travail de l’application de la couleur qui s’exprime dans la texture en peinture. Qu’en est-il de la texture lorsque cette dernière est numérisée ? Et comment rendre compte du fait que cette œuvre est intégrée à une base de données en compagnie d’autres milliers de peintures qui ont été également numérisées et rendues identifiables via des suites de nombres ?

On pourrait répondre que de toute texture picturale ne restera qu’un mince reflet de surface, et qu’une partie du travail fait sur la toile sera perdu pour toujours. Il est évident que le numérique peut aussi reconstruire, à la suite de la numérisation, les caractéristiques des matériaux originaires de la peinture en ajoutant à la « surface » de l’image numérisée des déclinaisons plastiques – via le traitement numérique – qui puissent simuler les aspérités de la matière colorée ou du support à travers des ombres représentées, par exemple.

- Note de bas de page 30 :

-

À ce propos, voir l’important texte, sous forme de manifeste, de Bachimont (2023).

- Note de bas de page 31 :

-

Sur la grammaire de l’image, voir Groupe Mu (1992) et, pour une discussion récente sur les notions de langue et parole visuelles, et de micro-langues au sein d’une praxis énonciative, voir Dondero (2020).

Mais ce processus de reconstruction, sur la surface numérisée, des textures de l’image picturale, ne se fait que lorsque la focalisation porte sur une seule image ou un petit corpus dont il faut mettre en valeur toute la complexité polysensorielle. Cette procédure n’est pas du tout d’usage dans le cadre des collections d’images contenues dans les bases de données, où le travail d’inscription de la matière est annulé. En effet, face à une collection de milliers d’images contenues dans une base de données, nous sommes confrontés à une autre sorte de matière, à savoir celle qui se présente comme une étendue de nombres visualisable sur un écran d’ordinateur. Il s’agit, d’un certain point de vue, d’une matière numérique qui est en partie déjà déterminée a minima car ce qui est « contenu » dans cette page d’écran remplie de nombres ne correspond pas à « la » matière numérique dans son état originaire30 (l’abstraction pure des nombres 1 et 0, dans leur état d’avant tout ordonnancement et d’avant toute visualisation sur un écran), mais elle est déjà en partie structurée. Cette structuration est due notamment au fait que ce système déploie les nombres identifiant les images contenues dans la base de données et non pas toutes les images déjà produites (et numérisées) dans l’absolu. Il s’agit d’une sélection, et plus précisément d’une collection constituée ; les nombres qui s’affichent sur l’écran sont par conséquent déterminés par cette collection elle-même et pas par toute la peinture produite, à savoir ce qui en sémiotique s’appelle la langue du visuel, à savoir à la fois sa grammaire et toutes ses performances31.

Que se passe-t-il une fois que toutes les images ont été transposées en des suites de nombres, chaque suite identifiant une image bien précise, et que chaque image a été incluse dans une base de données ? Cette base de données n’a pas le statut de ce qu’on appelle une langue, à savoir un système fermé et clos, exhaustif de toutes les manières de peindre, mais bien un réservoir qui s’apparente plutôt au fonctionnement diagrammatique. Nous faisons appel à la notion de diagramme car cette « correspondance » entre images et suites de nombres n’est pas une simple équivalence biunivoque entre une seule image et la suite de nombres qui l’identifie. Lorsqu’on utilise la base de données pour étudier les similarités figuratives et plastiques entre les milliers d’images, il se tisse un rapport diagrammatique entre des suites de nombres qui identifient les images composant la collection, d’un côté, et une multitude de formes visuelles, de l’autre. La relation diagrammatique se joue entre les processus mathématiques et statistiques qui déterminent les similarités formelles entre images et les images telles qu’elles sont perceptibles par un œil humain. Il s’agit donc d’un processus de traduction diagrammatique entre des rapports entre nombres et des rapports entre formes plus ou moins similaires, à savoir entre des procédures statistiques et des relations qui sont ensuite rendue perceptibles dans une visualisation finale qui organise une collection d’images selon des rapports statistiques de similarités. À travers cette visualisation finale, les formes visuelles (re)font surface lorsqu’elles sont visualisées sur un écran, et sont censées se révéler à nous, les observateurs de la visualisation, sous l’organisation topologique qui aura été donnée à l’ensemble de leurs propriétés plastiques par l’analyse computationnelle. Cette dernière aura permis d’« appliquer » la matrice mathématique aux caractéristiques plastiques de chaque image au sein de la collection afin de comprendre leurs relations réciproques (similarité/dissimilarité). Ces visualisations d’images ont été appelées « diagrammatiques » pour cette raison (Dondero 2020).

En ce qui concerne les images faisant partie d’une même base de données et constituant ainsi une collection, elles deviennent traduisibles entre elles. Traduisibles en quel sens ? Au sens où chaque image peut être calculée dans son unicité et mesurée dans toutes ses différences et similarités par rapport à toutes les autres images de la collection. Chaque image peut ainsi être comparée à toutes les images faisant partie de la collection selon des pertinences diverses, à savoir des paramètres – tels que les paramètres de l’intensité de la lumière, des contours et des lignes qui entourent les couleurs, etc. Cette comparabilité des images selon divers paramètres rend cette base de données susceptible d’être utilisée au moins de deux manières : pour l’analyse de la collection elle-même, et pour la production (de nouvelles images) à partir de celles déjà présentes dans la base de données.

4.1. L’analyse de la base de données et la visualisation des collections

Focalisons notre attention sur l’analyse. L’analyse qui a été réalisée le plus fréquemment sur des bases de données d’images a répondu à un projet ancien en histoire de l’art, qui est celui de l’Atlas d’Aby Warburg (1924-1929). Warburg a en premier affirmé que, pour comprendre une image, il faut connaître les images qui l’ont précédée, qui l’ont développée ou citée et aussi qui ont essayé de la dépasser, de la nier, de la contredire. Les projets de recherches tels que ceux de Lev Manovich (Media Visualization) et de Benoit Seguin (Replica) ont développé chacun à sa manière une tentative de rendre visibles les résultats de l’analyse des similarités et dissimilarités entre une image et une autre. Les deux projets ont produit des visualisations ayant comme objectif de construire des cartographies des collections d’images qui puissent organiser la base de données et notamment grouper les images de la collection dans des zones différentes de la carte selon leurs affinités/dissimilarités.

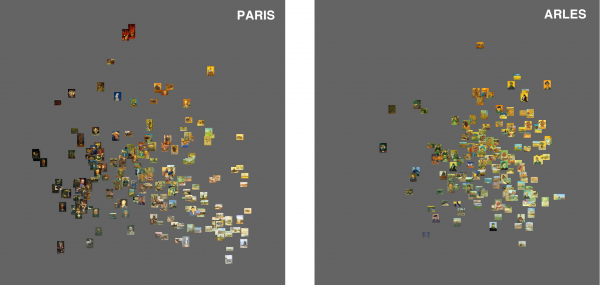

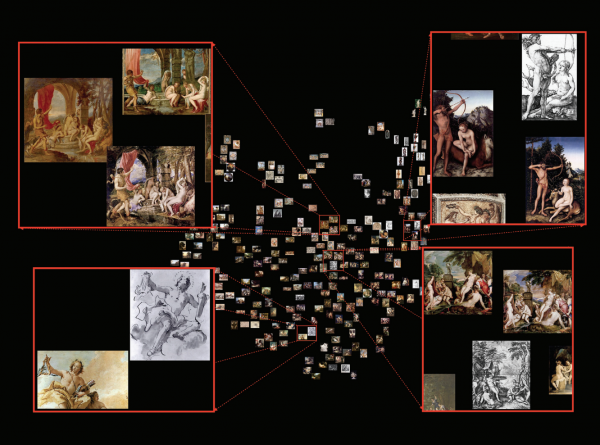

Les deux visualisations qui suivent sont de bons exemples des techniques de visualisation respectivement de Lev Manovich (Figure 3) et de Benoît Seguin (Figure 4). Les deux projets partagent certains objectifs et se distinguent par leurs instruments d’analyse et par les corpus analysés, ainsi que par les styles choisis pour visualiser les données.

Figure 3. Lev Manovich (2011). Comparaison entre les peintures produites par Van Gogh à Paris (gauche) et à Arles (droite) par rapport à la brillance et à la saturation. Axe x : moyenne de brillance ; axe y : moyenne de saturation.

Figure 4. Projet Replica. Voir Seguin (2018).

Le projet de la Media Visualisation a été lancé en 2010. Il mesure et ensuite visualise des similarités visuelles dans des collections d’images massives, notamment des œuvres picturales des artistes de la fin du 19e siècle dont la production se positionne à cheval entre la figuration et l’abstraction ; le projet Replica, porté par Benoît Seguin au Digital Humanities Lab de l’EPFL en 2015, vise à repérer la migration des motifs iconographiques d’œuvres picturales, mais aussi de dessins et estampes présents au sein de la collection de la Fondation Cini de Venise.

- Note de bas de page 32 :

-

Évidemment, dans le cas du deep learning également, le chercheur choisit, dans certains cas, un corpus d’images d’entrainement assez ciblé pour pouvoir ensuite analyser de nouvelles images selon ce que la machine aura retenu de son entrainement.

La Media Visualisation traite les images sélectionnées à travers des techniques basées sur l’extraction de leurs caractéristiques dites de bas niveau (low-level features), telles que l’intensité des couleurs, les contours et la position des formes, selon un apprentissage semi-supervisé, qui dépend en partie des choix du chercheur qui connaît le corpus et utilise les paramètres plastiques pour tester les styles picturaux par rapport aux connaissances établies en histoire de l’art. En revanche, le projet Replica utilise des méthodes d’apprentissage profond (deep learning) qui laissent la machine plus libre dans l’élaboration des images et de leur analyse, la machine étant entraînée par des corpus « exemplaires ». Il s’agit donc d’une méthode moins supervisée que celle utilisée par Manovich qui extrait des propriétés formelles rendues pertinentes directement par la compétence du chercheur32. Autrement dit, l’apprentissage profond s’appuie davantage sur les corpus par lesquels la machine a été nourrie, à savoir sans aucune autre instruction que les corpus d’entraînement.

- Note de bas de page 33 :

-

Sur le débat au sujet de l’autonomie du langage visuel et son métalangage, voir Fabbri (1998) et la critique de Dondero (Dondero 2017b, 2020) à la translinguistique de Barthes et Benveniste. Sur la prédication caractérisant le langage verbal et la composition caractérisant l’image, voir Bordron (2010).

La première caractéristique commune est que les deux projets utilisent des descripteurs visuels pour analyser de grandes collections d’images, au lieu d’utiliser exclusivement des métadonnées telles que la date et le lieu de production, le genre, etc. Comme l’a indiqué Manovich (Manovich 2015), le principal défaut de la classification à l’aide de métadonnées standard est que les termes utilisés dans la classification des images ne reflètent pas du tout les caractéristiques du langage visuel, c’est-à-dire les formes spécifiques d’organisation des images33.

- Note de bas de page 34 :

-

Sur la méréologie comme approche des relations entre une totalité (la collection) et ses parties (les images individuelles qui la composent) et les relations entre les parties elles-mêmes, voir Bordron (1991, 2011).

Le deuxième point en commun est que les deux projets produisent des visualisations d’images fonctionnant comme des méta-images, c’est-à-dire que les visualisations elles-mêmes constituent des processus d’analyse (au sens de la division et de la réorganisation) d’images – comme expliqué dans Dondero (2017a, 2019). Cette analyse-visualisation doit être comprise comme le résultat d’opérations méréologiques de division, de groupement, de comparaison que la machine opère sur la collection34.

- Note de bas de page 35 :

-

Voir le site web de l’artiste à cette adresse : http://www.pahomann.com.

Une conclusion que nous pouvons tirer de ce genre d’analyse computationnelle qui, pour fonctionner, doit transformer l’image, et avec elle la collection d’images dans laquelle elle est contenue, en un ensemble de nombres qui sont en partie indépendants – en tant que caractéristiques plastiques (low-level feature) isolables – de la totalité de l’image dont ces caractéristiques ont été extraites, est que l’image subit ce que nous pourrions appeler une « désintégration ». Cette désintégration a été problématisée non seulement dans des livres qui se sont imposés comme fondamentaux dans l’histoire des médias (Manovich 2001, 2020) mais aussi dans le cadre de la réflexion artistique. Nous pensons aux expériences de l’artiste américain Paho Mann35 qui met en scène des dispositifs de production d’images qui ont explosé en raison des processus de numérisation, à savoir leur « décorporation ».

Figure 5. Paho Mann, série Fragmented camera, 2019.

- Note de bas de page 36 :

-

Le Glitch Art vise à imiter, via le langage visuel, l’idée de bruit (à l’origine sonore) produit par les failles des performances technologiques.

- Note de bas de page 37 :

-

Par unité inaliénable il faut entendre et celle du corps humain et celle de l’image autographique au sens de Nelson Goodman (1968) en tant que densité syntaxique et sémantique.

Cette image (Figure 5) thématise en effet une explosion du corps de l’appareil producteur en mille morceaux, à savoir un appareil photographique qui finit par se diffuser dans l’environnement. Contrairement aux images appartenant au mouvement du Glitch Art, qui montrent l’impact du numérique sur des objets (qui en résultent par conséquent fracturés, ou plein de bavures et rayures)36, les productions de Paho Mann fonctionnent de manière différente. Ce n’est pas le corps d’un objet quelconque qui se retrouve à subir les accidents numériques, mais bien le corps même de l’appareil photo – qui explose. Cela signifie que la technique de production s’effrite, se décompose : le statut d’empreinte est révoqué, son pouvoir est annulé. Notamment son pouvoir de tenir ensemble la réalité, au sens de représenter à travers un point de vue englobant ce que nous avons devant les yeux et appelons pro-photographique. Car la mission de la photographie n’était évidemment pas la ressemblance avec la réalité ; le pouvoir de la photo était en revanche de faire tenir ensemble une vision des choses, comme si cette vision était un organisme conçu dans son intégrité. Ce pouvoir de production de totalités était assuré par la pratique photographique. L’empreinte, tant discutée dans ce livre (Basso Fossali et Dondero 2011), et le problème de l’énonciation photographique, étaient abordés comme les composants d’une vision compacte qui se tenait, d’un côté, grâce à l’œil et au style de regard de chaque photographe et, de l’autre, en raison de l’effet globalisant de l’empreinte. L’empreinte a en effet historiquement eu la mission et la capacité de construire des totalités là où il n’y avait que de la dispersion, la dispersion du monde, de l’environnement. Si donc l’empreinte photographique construisait des totalités solides, la numérisation (la numérisation des œuvres d’art, les œuvres nativement numériques, ainsi que les images manipulées via les instruments numériques) posent le problème de la tenue de la vision de quelque chose comme une totalité, un entier. Autrement dit, ce qui est en cause ici est l’entièreté de l’image, de l’image entendue comme totalité, l’image comme corps, comme organisme, par définition considérée comme une unité inaliénable37. Ce corps est mis à mal, comme nous le montre finement Paho Mann. Ce corps ne tient plus. Ni comme texte, ni comme objet, car sa densité syntaxique et sémantique, qui caractérise l’œuvre d’art en tant qu’image autographique est partie en fumée, autant que son cadre.

Mais comment pouvons-nous expliquer cette iconographie de l’explosion ? Pourquoi Paho Mann aurait-il choisi l’explosion et non pas, comme dans des cas plus classiques de Glitch Art, la mise en scène de la forme carrée des pixels qui montre la spécificité du numérique (à savoir la discontinuité dont il est fait, les 0 et les 1 qui se succèdent, se recombinent et s’affichent en tant que schématisation de couleurs) ? Paho Mann fait un choix plus original et plus audacieux ; il ne montre pas la matière du numérique, à savoir les pixels manipulables, la chair vide de l’image, mais une autre et plus intéressante caractéristique du numérique, à savoir le fait que l’image n’est qu’une série de caractéristiques isolables et ensuite recomposables – et que son unité est perdue. Ces caractéristiques peuvent former à nouveau la totalité d’origine, ou une tout autre composition tout autant possible avec la recombinaison de ses caractéristiques, à savoir de ces éléments qui sont non seulement recombinables, mais surtout sans cesse manipulables et dotés d’une identité éphémère et instable.

4.2. Generative IA. La production d’images à partir des bases de données

Les bases de données et les méthodes de l’intelligence artificielle et de la computer vision ne servent pas exclusivement à l’analyse des collections, mais aussi à la production de nouvelles images à partir de toutes les images qui sont stockées et annotées selon les styles, les auteurs et les genres, dans les bases de données disponibles (Wikiart, Iconclass, etc.). Les générateurs d’images comme Midjourney ou Stable Diffusion permettent de produire des images à partir des descriptions via le langage naturel, et d’autres plateformes comme Nightcafé. AI Art Generator peut aussi générer de nouvelles images à partir d’une image et d’un texte, changer le style d’une photo, mélanger plusieurs styles ou plusieurs images d’artistes différents, etc.

- Note de bas de page 38 :

-

Ce qui est surprenant est que certaines images produites par la machine peuvent obtenir des prix lorsqu’elles sont mises en compétition avec des images produites par des humains. Voir le cas de la Colorado State Fair où Jason Allen a remporté le concours d’art grâce à son œuvre intitulée Théâtre D’opéra Spatial produite par Midjourney : https://www.tomsguide.fr/polemique-une-oeuvre-dart-generee-par-lia-remporte-un-concours-les-artistes-sindignent/. Un autre exemple d’œuvre d’art produite par l’intelligence artificielle est celle de Refik Anadol Studio intitulée Unsupervised (2022). Ce projet utilise les réseaux neuronaux entrainés sur une base de données de dix milles œuvres d’art appartenant à la collection du MOMA. Cette collection comprend des œuvres d’art moderne allant de 1870 à 1970 ainsi que des œuvres des décennies successives. À propos de cette œuvre, voir Manovich (2023) et le paradoxe qu’il met en lumière entre le mouvement du modernisme auquel appartiennent les œuvres dans la base de données qui visent le nouveau et la destruction de l’ancien et les algorithmes qui les retravaillent, qui sont comparés par Manovich à un artiste très conservateur.

- Note de bas de page 39 :

-

En sémiotique, voir la notion de bricolage (Floch 1990).

Quoi qu’il en soit, l’intelligence artificielle via les réseaux de neurones peut aujourd’hui produire des images à partir des stocks numérisés qui comprennent tous les styles et les auteurs les plus célèbres de l’histoire de l’art et de la photographie contemporaine38. Les critiques à ces images produites par les algorithmes abondent évidemment, notamment dans les commentaires des moralisateurs de la production artistique qui ne peut être qu’humaine et venant de l’esprit créateur absolu. En revanche, les chercheurs qui connaissent un tant soit peu l’histoire de l’art ainsi que l’histoire des médias savent non seulement que l’histoire de l’art est une suite des reprises de l’ancien39, de déformations, corrections, mélanges de styles ainsi que des expériences sur l’automatisation, mais aussi que ces images générées par ordinateur nous permettent de comprendre la manière dont des grandes œuvres d’artistes du passé peuvent être croisées entre elles et, dans certains cas, nous faire découvrir des nouvelles caractéristiques de chaque artiste – justement grâce au croisement d’images connues et à l’intermédiation du texte verbal. À ce propos, il faut rappeler que, dans sa page Facebook, Lev Manovich a commencé en septembre 2022 à produire des images qui sont le résultat de croisements entre œuvres d’artistes tels que Bosch et Kandinsky ou entre des grands peintres du passé et la photographie contemporaine, ou entre un style et un imaginaire. Cet imaginaire peut être par exemple « évoqué » au sein de Midjourney par un texte de ce genre : « La froide campagne sibérienne » ou, lorsqu’on souhaite restreindre les possibles productions de la machine, préciser selon le style de quel auteur (« la plage méditerranéenne selon le style de Matisse »).

- Note de bas de page 40 :

-

Voire le compte Instagram @georgelegrady avec ses intéressantes productions Midjourney.

- Note de bas de page 41 :

-

Aluminé Rosso a proposé à George Legrady (communication au colloque « Face it ! » organisé à l’université de Liège du 25 au 27 janvier 2023 par M. G. Dondero, M. Leone et C. Paolucci) de considérer ces opérations comparables à celles d’un curateur d’exposition qui conseille l’artiste, teste ses propositions et l’aide à définir la version définitive de son travail selon l’environnement d’exposition et d’implémentation.

Lorsqu’on commence à utiliser Midjourney, ou Stable Diffusion, ou d’autres générateurs d’images, on se rend compte que le processus de production d’une image ou d’une série d’images telles que celles produites par Lev Manovich ou George Legrady40 implique plusieurs opérations de la part de la personne qui l’utilise. En effet, lorsqu’on donne une instruction à la plateforme Midjourney, par exemple « Salle de réunion à Liège selon le style de Giacometti » on obtient quatre versions de cette instruction verbale, qui se différencient entre elles par l’intensité de la lumière, le type de mobilier, le positionnement du mobilier, etc. L’expérimentateur peut choisir la version qui lui convient le plus et décider de poursuivre la recherche de l’image qu’il imagine pouvoir produire (on part des signifiants et on va à la recherche de l’idée : il s’agit d’un cas de perception théorisante) en donnant des instructions supplémentaires pour modifier la version de l’instruction choisie, à savoir l’image à travers laquelle la quête va continuer. Les possibilités de transformer les quatre versions produites, en en choisissant à chaque série de quatre seulement une, peut se continuer jusqu’à l’apparition de l’image produite par l’algorithme qui puisse satisfaire l’expérimentateur. La production peut ainsi être décrite à travers des opérations de décision, de demandes de transformation, de traduction entre langage verbal et langage visuel41. En outre, comme l’explique Manovich en prenant en considération la production sur Stable Diffusion de Lev Pereulkov, Artificial Experiments 1-10, de 2022, l’expérimentateur peut décider d’affiner un réseau de neurones existant à travers des instructions qui ont la capacité de rendre le réseau de neurones attentif aux souhaits de l’expérimentateur et minimiser ainsi les biais ou le bruit produit par des bases de données trop larges.

Une autre manière de limiter les possibles génératifs de la machine est non seulement d’indiquer un ou deux styles d’artiste, ou d’affiner le réseau avec certaines images annotées par l’expérimentateur comme dans le cas de Pereulkov, mais aussi d’indiquer explicitement à la machine la technique à utiliser, telle que par exemple « dessin à la craie », « peinture à l’huile », « fresque », etc.

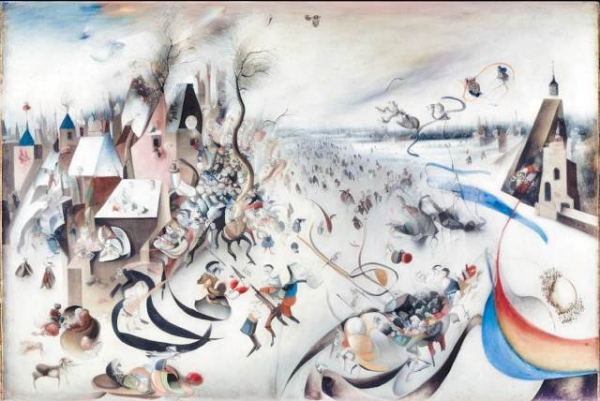

L’expérimentateur doit non seulement prendre des décisions sur les versions offertes par les premières instructions données, mais aussi tenter de limiter progressivement les « libertés » prises par la machine (qui peut ajouter des objets par exemple selon le style ou l’artiste choisi) ou les « contraintes » stéréotypées de la machine qui agit statistiquement. Mais on peut aussi décider de démultiplier les options et tester sur un seul sujet (un paysage, une nature morte) le style de plusieurs peintres ou photographes. Il est clair que, en ce qui concerne le style photographique, comme écrit dans Basso Fossali et Dondero (2011), il est plus difficile de le « stabiliser », voire de le stéréotyper, car l’énonciation photographique dépend en partie des formes du monde et le pouvoir du photographe de différencier son style est plus limité que celui du peintre. Il se peut aussi que le réseau de neurones entrainés seulement sur certaines images d’un artiste ne propose que le stéréotype d’une certaine période de la production d’un peintre ou d’un photographe. Mais ce qui est certain dans les productions de Manovich via Midjourney est que les résultats, par exemple d’un croisement entre Bosch et Malevitch, mettent en scène de petites figurines selon le style de Bosch sans pourtant les dupliquer à l’identique. Les figurines se modifient selon les positions qu’elles occupent au sein du paysage dont les coordonnées sont données par des figures à la Malevitch, comme l’on peut voir ici (Figure 6).

Figure 6. Lev Manovich (2023). Image generated in Midjourney using prompt “painting by Malevich and Bosch”.

Comme dans le cas d’une autre production de Manovich, qui croise Brueghel et Kandinsky (Figure 7), l’on peut affirmer que les artistes abstraits tels que Malevitch et Kandinsky sont utilisés par la machine comme des instructions pour construire une topologie globale, un paysage qui puisse accueillir les figurines des peintres tels que Bosch et Brueghel, traditionnellement considérés comme des paysagistes, mais surtout, selon l’œil de la machine, utilisables comme des spécialistes de petites figurines répétables et modifiables au sein du paysage kandiskyen ou malevitchien.

Figure 7. Lev Manovich. Midjourney, prompt: “Painted by Brueghel and Kandinsky”, Fall 2022.

Une autre expérience faite par Manovich est celle de tester le style d’un artiste, par exemple David Caspar Friedrich, sur des sujets qui ne sont pas ceux que l’artiste a privilégiés dans sa carrière, par exemple des natures mortes avec des fleurs. Ou encore, on peut tester des styles photographiques sur des natures mortes espagnoles, italiennes et flamandes et découvrir que l’artiste « le plus photographique », à savoir celui qui est plus proche de ce que la machine considère comme « typiquement photographique » est un flamand, à savoir Pieter Claez, qui est celui qui a le plus joué sur les transparences et la brillance. Les expériences possibles sont bien multiples !

Conclusions

Nous avons exploré diverses constitutions possibles d’un plan d’expression en insistant sur ses composants essentiels que sont le temps, l’espace et la matière. Ces composants n’ont de véritable existence que dans la mesure où ils reçoivent des formes, que celles-ci proviennent de notre rapport avec le monde dans une perception ou d’un acte créateur nécessaire pour exprimer un sens, c’est-à-dire une idée. Nous avons vu en quel sens un plan d’expression est par essence manipulable, non seulement de par sa nature sensible, mais aussi parce qu’il est un lieu de création aussi bien dans la tradition picturale que dans les nouveaux traitements informatiques. En prenant l’exemple des images dans leur diversité, nous avons essayé de montrer comment la pratique de la création, mais aussi de la réception, sont liées ensemble dans un parcours dialectique et/ou diagrammatique.

- Note de bas de page 42 :

-

Sur ce point voir Petitot-Cocorda 1985.

Un point essentiel doit être souligné pour éviter toute confusion. La notion d’expression, ou encore de signifiant, est une notion qualitative et pour cette raison échappe aux mesures physiques. On peut bien sûr mesurer une quantité de lumière ou sa probabilité d’apparition. Il s’agit alors d’un signal transportant une information, mais non d’un signifiant. Physiquement, on peut penser qu’il s’agit de la même chose, mais le risque est alors d’ignorer la spécificité du fait sémiotique. Si une physique du signifiant est possible, ce ne peut être qu’une physique qualitative42.