Image scientifique et énonciation du temps1

0. Introduction

- Note de bas de page 2 :

-

Sur la distinction entre « science faite » et « science en train de se faire » voir Latour (1989).

- Note de bas de page 3 :

-

Voir Goodwin (1994, 1995, 1996, 1999) et Mondada (2005).

Notre étude, portant sur les stratégies représentationnelles de la stratification temporelle dans l’astrophysique et dans l’archéologie, peut être considérée comme appartenant à la catégorie des études relatives à la « science faite », voire aux analyses de la littérature scientifique. Mais on voudrait toute de suite porter l’attention sur ce que cette approche sémiotique de la « science faite » laisse de côté. En fait, cette approche n’est pas sans risque car elle exclut un travail ethnographique de recherche de terrain sur les pratiques et les procédures d’émergence des connaissances en laboratoire (recherches relatives à la « science en train de se faire »)2. Cette dernière approche est partagée par un certain nombre de chercheurs en sociologie et anthropologie des sciences, ainsi que par des linguistes interactionnels3 qui étudient les interactions entre chercheurs en laboratoire et les conduites des sciences contemporaines in vivo. Ces études ne sont pas du tout de simples transcriptions et de comptes-rendus des séances expérimentales en laboratoire mais des analyses du syncrétisme de parole et gestuel dans un espace institutionnel. Cette approche nous paraît intéressante non seulement parce qu’elle montre une voie parcourable par les chercheurs en sciences du langage qui visent à étudier les pratiques dans leur déploiement (énonciation en acte) mais elle offre aussi une voie pour comprendre comment les stratégies rhétoriques de la littérature scientifique (énonciation énoncée) se basent sur une archéologie — au sens de Foucault — qui peut mettre en valeur les négociations et les décisions prises lors des expériences. La littérature scientifique épure souvent des textes, même des textes de recherches, les discussions ayant lieu dans les lieux affectés à la fabrication de la connaissance scientifique. Comme l’a montré Françoise Bastide (2001) il y a déjà vingt ans, les controverses qui sont mises en scène par les articles scientifiques sont des disputes « externes » qui se jouent avec des laboratoires limitrophes et concurrents et qui ne révèlent pas les aventures conflictuelles intervenues au sein du laboratoire d’où ressortent les résultats de l’investigation dont il est question dans les articles.

- Note de bas de page 4 :

-

Pour une aperçue (un aperçu) des conventions de transcription utilisées par les linguistes interactionnels voir Mondada (2005, p. 13 et pp. 31-34).

- Note de bas de page 5 :

-

Dans les cas de la sociologie des sciences, ainsi que de la linguistique interactionnelle, les méthodes d’analyse qui sont a priori exclues sont les interviews aux scientifiques, considérées justement non fiables par rapport à l’observation et à l’analyse de leur savoir-faire en acte.

- Note de bas de page 6 :

-

Voir Bourdieu (2001) pp. 55-66, mais en particulier p. 62, où Bourdieu parle de « ces fameux "actants" ».

Au contraire, les recherches des linguistes tels Charles Goodwin et Lorenza Mondada visent à montrer la dynamique de l’émergence des savoirs dans l’interaction entre scientifiques et objets d’enquête (rapports entre les prises de parole, sélections d’intonations4, positionnements spatiaux des participants, gestes, outils techniques, etc.5). Il s’agit de concevoir l’interaction comme une co-énonciation en acte, où les voix énonciatives sont distribuées dans des réseaux intersubjectifs et interobjectifs. Dans les travaux de Charles Goodwin et dans les travaux de Bruno Latour, les scientifiques et les différents outils techniques se diffractent et se multiplient en des actants — notion permettant de décrire avec une extrême finesse et transversalement par rapport aux sujets et aux objets, les micro-actions qui constituent une interaction. Chez Goodwin, c’est l’orientation globale de l’interaction qui sert à démêler, sélectionner et ordonner les micro-actions des scientifiques et des leurs dispositifs de médiation (écrans d’ordinateur, crayon, microscope, appareils de mesure, etc.) — mais le corps du scientifique peut être lui-même étudié dans certains cas comme un dispositif de médiation. Ces choix épistémologiques — concernant la supériorité sémantique de la taille globale sur la taille locale — et méthodologiques — concernant l’analyse actancielle —, qui peuvent se dire comme redevables d’une tradition sémiotique poststructuraliste pleinement assumée par les deux savants, ne visent pas à niveler l’humain et le non-humain comme l’a affirmé Bourdieu (2001) lorsqu’il a évalué le travail latourien6 mais ils visent par contre à réduire l’hétérogénéité du plan de l’expression des interactions pour pouvoir cerner les parcours d’iconisation de la connaissance expérimentale.

- Note de bas de page 7 :

-

Mais il s’agirait aussi de mettre en évidence comment les pratiques elles-mêmes produisent des textualités tout au long de leur « être en train de se faire » et comment les textes déjà constitués sont manipulés tout au long des expériences…. D’ailleurs, comme l’affirme P. Basso Fossali (2006), les textes eux-mêmes sont déjà une forme de gestion, de thésaurisation et de mise en mémoire du sens, à savoir une manière de « résoudre » la précarité de la sémantisation des pratiques. Le texte est donc un pôle de normatisation des pratiques.

- Note de bas de page 8 :

-

De plus, à l’intérieur du niveau du texte, il faudrait comparer les publications officielles et les publications moins officielles des textes scientifiques — pour arriver à identifier un continuum qui va des mises en scène de la production des nouvelles iconographies et des nouveaux objets de savoir (pôle de la recherche) à celles qui fixent et stabilisent l’objet/phénomène de référence (pôle de la vulgarisation), ce que j’appellerai la description sémiotique d’une ergonomie cognitive des phénomènes.

Les analyses des linguistes de l’interaction peuvent être critiquées en raison de la taille microscopique des événements étudiés, qui ne permettrait pas de dégager des régularités des pratiques, voire une praxis énonciative, mais seulement la description des énonciations en acte, de cas isolés. Quoi qu’il en soit, il faut sans aucun doute pouvoir étudier de manière intégrée le niveau des pratiques (la science en train de se faire) et celui des textes (la science faite). Dans le cas de l’étude des inscriptions et des images en particulier, qui est le nôtre, ce qu’il faudrait mettre en évidence est, d’une part la chaîne productive des images au sein de l’expérience scientifique (niveau des pratiques) et d’autre part, le positionnement stratégique de ces mêmes images, après sélection et tri, au sein de la publication des résultats dans les différents genres discursifs (niveau du texte). Il faudrait donc rapporter le premier aspect au second : mettre en rapport le processus de visualisation et de fabrication des images en laboratoire avec la disposition rhétorique des représentations visuelles dans la littérature scientifique7 — ce que, dans le cadre de ce travail, nous ne sommes pas en mesure de faire8.

En fait, en ce qui concerne cette étude nous nous ne livrerons qu’à l’analyse des statuts que les images assument dans la littérature scientifique en essayant de problématiser aussi la question des genres. Ce choix qui réduit nos ambitions aux études de la textualité scientifique ne nous empêchera pas de nous poser des questions sur la relation entre les statuts stabilisés des images en littérature et les statuts que ces mêmes images ont assumés lors de leur production en laboratoire au sein d’une expérience.

1. Autographie et allographie en archéologie et en astrophysique : imagerie, photographie, dessin

Dans le cadre de cette recherche nous envisageons de prendre en considération une problématique qui est transversale aux disciplines scientifiques contemporaines : la représentation de la stratification des couches temporelles (présent, passé, futur). En ce qui concerne les disciplines choisies pour cette recherche, l’astrophysique et l’archéologie, elles sont très différentes de part leurs objets d’étude, mais présentent néanmoins un point commun : leurs objets d’étude sont invisibles à l’œil nu. Notre objectif est de comparer les stratégies de représentation de ces phénomènes invisibles à l’œil nu et plus précisément les stratégies de mise en scène de la stratification des couches temporelles. Nous nous proposons d’illustrer comment il devient possible d’inscrire et de lire cette stratification de traces des temporalités différentes dans les images de ces deux disciplines.

- Note de bas de page 9 :

-

Pour une étude des pratiques d’investigation du sol via la vision et le toucher en archéologie, cfr. Goodwin (2000).

- Note de bas de page 10 :

-

Pour un aperçu général des méthodes de traitement des données afin de décrire et classer les objets en archéologie (méthodes graphiques, méthode de traitement des tableaux, méthodes statistiques) et d’analyser les sites (méthodes cartographiques et statistiques), voir Giligny (2005).

- Note de bas de page 11 :

-

Pour approfondir la question de la répétabilité des expériences et de la validité d’une méthode hypothético-déductive en archéologie voir le remarquable article de Jean-Paul Demoule (2005).

- Note de bas de page 12 :

-

Voir à ce propos A.a.Vv. (2005b).

- Note de bas de page 13 :

-

Voir à ce sujet A.a.V.v (2006).

- Note de bas de page 14 :

-

Sur la relation entre archéologie et « sciences connexes » telles la physique (pour la datation via le carbone 14), la géologie (pour la méthode stratigraphique) etc. voir Demoule (2005).

- Note de bas de page 15 :

-

Sur la notion de notation voir Goodman (1968).

Il faut commencer par illustrer la différence de fonctionnement des visualisations dans les deux disciplines, en partant de quelques considérations générales sur leurs outils d’investigation et leurs degrés de technologisation. On pourrait dire que l’archéologie, à la différence de l’astrophysique, et pour des raisons évidentes, n’a jamais pu s’éloigner complètement de l’investigation par la saisie directe, à savoir par la vision et le toucher, en vue de la classification des différences de couleur, de résistance et de compacité des strates du sol, ainsi que des objets9. Ici on ne portera pourtant pas l’attention aux méthodes invasives comme la fouille, qui sont des méthodes de plus en plus délégitimées en faveur des méthodes non invasives et d’investigation indirecte (prospection géophysique et prospection aérienne). En fait, les méthodes invasives de l’archéologie où les mesurages obtenus ne peuvent pas être entièrement répétés et vérifiés, annulent le principe de l’image scientifique fabriquée en laboratoire — principe qui est le propre de l’image en astrophysique et de toutes les disciplines dont les enquêtes sont tenues pour entièrement contrôlables et falsifiables. L’archéologie n’appartient pas aux disciplines dont les instruments sont considérés comme entièrement contrôlables parce qu’elle recourt à des méthodes d’investigation, comme la fouille, qui rendent impraticable la répétition des expériences par la communauté scientifique. D’une certaine manière, on pourrait dire que l’archéologie des fouilles a plus de mal que l’astrophysique à extraire de ses données des règles de reproductibilité et manipulabilité des résultats obtenus des expériences10 : l’astrophysique permet un degré plus fort de mathématisation de données et donc de généralisation que l’archéologie. Cela ne veut pas dire pourtant non plus que l’archéologie soit une discipline qui n’a pas d’intérêt à construire de règles visant la comparabilité ou la modélisation des données11. Tout au contraire, il y a une partie de l’archéologie qui se fonde sur une imagerie fabriquée grâce aux prospections en géophysique, ou sur toute autre sorte de technologies de laboratoire visant la datation par exemple (radiocarbone, dendrochronologie, archéomagnétisme, etc.)12. L’imagerie produite grâce aux prospections géophysiques qui exploitent des propriétés physiques — comme par exemple la résistivité électrique —, pour prélever des informations sur les structures matérielles du sous-sol permet la totale contrôlabilité des résultats de l’investigation. Cette contrôlabilité est due non seulement à la digitalisation des mesurages, mais aussi au croisement de ces mesurages avec le quadrillage du sol13. Ces méthodes empruntées à la géophysique14 permettent de construire des véritables cartes représentant la distribution des propriétés physiques et donc une géographie des caractéristiques des différentes zones des sols et des sous-sols. À travers le croisement de méthodes différentes d’investigation, comme le quadrillage du sol et les prospections géophysiques, on peut considérer que ce domaine de l’archéologie aspire à une certaine contrôlabilité collective des investigations et à une certaine reproductibilité des données (notationnalité)15.

- Note de bas de page 16 :

-

Voir Daston et Galison (1992 et 2007).

- Note de bas de page 17 :

-

Cela dit, les procédures et les techniques classiques photographiques sont encore utilisées pour témoigner de multiples objets : un état de la fouille, un état du sol ou un objet qui en a été extrait. Voir Chéné, Foliot, Réveillac (1999).

Tout cela n’empêche pas de se rappeler que, à différence de l’astrophysique qui est dominée par l’imagerie, en archéologie on utilise des méthodes de mesurage et d’investigation comme la photographie et le dessin16. Ces méthodes d’investigation sont surtout utilisées dans le cadre de l’archéologie dite invasive, où il s’agit justement de témoigner des travaux de fouille et de comprendre par exemples les modes de fabrication des objets découverts. Si le dessin est pris, dans des multiples études sur l’image scientifique, comme l’exemple le plus pur d’un régime de signification autographique (Goodman 1968 ; Dondero 2009a) et comme l’instrument le plus lointain de l’imagerie — le dessin étant une technique qui dépend fortement d’une trace singulière sensori-motrice et donc moins contrôlable et reproductible —, cela n’est pas vrai dans le cas de l’archéologie. En fait, le dessin est considéré comme étant plus adéquat que la photographie pour l’investigation des objets archéologiques. Très tôt, en fait, la photographie a été considérée comme une technique ne permettant pas de répondre aux exigences de l’analyse archéologique, parce que trop peu sélective17. L’archéologie a toujours privilégié le dessin à la photo, comme si le dessin se rapprochait plus que la photo des règles de l’imagerie. Comment serait cela possible ? Quelles sont les caractéristiques et les avantages analytiques que l’imagerie et le dessin partagent et que la photographie ne peut pas atteindre ? En archéologie, à la différence d’autres disciplines, la transformation d’une photographie en dessin permettrait d’attendre une plus forte allographisation des données, allographisation que la photographie ne permettrait pas d’assurer, étant trop liée à la trace « locale » de ce qu’elle met en scène.

- Note de bas de page 18 :

-

Sur le concept d’iconicité voir Bordron (2000, 2004) et en ce qui concerne la stabilisation des objets scientifiques en image voir Bordron (2009) et Dondero (2009a).

- Note de bas de page 19 :

-

A ce sujet voir Dondero (2009a). Pour une lecture peircienne de la production d’images en astrophysique voir Allamel-Raffin (2004).

Essayons de mieux nous expliquer. L’archéologie et l’astrophysique visent à produire, à partir des traces ou des données recueillies, un « quelque chose » que la communauté scientifique puisse appeler « objet », à savoir quelque chose de justifié (indicialité), stabilisé (iconicité), partageable (symbolicité)18. Même si elles visent à rendre compte d’un objet d’analyse, l’archéologie et l’astrophysique visent aussi à rendre manipulable cet objet, en vue d’une investigation plus ample et en vue de la production d’hypothèses qui puissent permettre de réutiliser les données incorporées en cet objet pour d’autres recherches futures (généralisation des résultats). Si le régime autographique concerne la fixation sur un support de la densité des traces d’un processus ou d’un phénomène, le régime de l’allographie concerne par contre des stratégies de digitalisation des traces et des données (de-densification) en vue d’une modélisation de ces dernières. Pour simplifier on pourrait affirmer que l’image autographique témoigne d’une relation unique et non répétable19 avec le phénomène observé ou détecté (le support d’inscription maintient sa pertinence), alors que le régime allographique de l’image ne rendant pas pertinent l’ancrage des données sur un support, offre la possibilité aux scientifiques de poursuivre un parcours de schématisation qui en fera une sorte d’image-modèle, utilisable pour d’autres phénomènes à investiguer. L’image dans le régime de l’allographie a un statut de texte d’instructions (partition) à utiliser pour accomplir d’autres investigations ; elle pourrait se dire une image prédictive, orientée vers le futur.

- Note de bas de page 20 :

-

Sur la chronophotographie de J.-E. Marey en tant qu’instrument analytique voir Didi-Huberman et Mannoni (2004), et pour une relecture sémiotique voir Dondero (2009b). Sur le dessin en tant qu’instrument analytique voir Baetens (2010).

Dans cette perspective, on peut plus facilement préciser la question de la plus ou moins forte adéquation de la photographie et du dessin aux nécessités de l’archéologie20. Un des problèmes posé par l’utilisation de la photographie est la difficulté de discriminer l’information utile de celle contingente et de rendre homogènes toutes les traces que l’œil mécanique n’est pas capable de distinguer, bref de ne pas rendre immédiatement visibles les données pertinentes et recherchées. Le dessin, par contre, paraît mieux s’adapter aux exigences de lisibilité des objets en archéologie parce qu’il est un instrument plus analytique. A ce propos Allamel-Raffin remarque que les champs disciplinaires qui se sont intéressés à la photographie, par exemple l’astronomie, sont ceux qui avaient des difficultés de captation. Or dans le cas des objets archéologiques, l’objet ne pose pas de problème de captation étant de taille macroscopique : « La finalité visée par les archéologues n’est pas de montrer que l’objet existe, mais de montrer de manière précise comment il a été fabriqué » (Allamel-Raffin, 2010). Il faut donc conclure que, dans une discipline comme l’astrophysique où la première difficulté réside dans la captation des données, les chercheurs vont se tourner vers des dispositifs imageants permettant d’attester l’existence même de l’objet avant même d’en étudier les propriétés telles la photographie et l’imagerie. Dans le cas de l’archéologie les deux types de méthodes sont également nécessaires : l’imagerie et la photographie aérienne servent à identifier les caractéristiques des sols et la constitution matérielle des objets sans les détruire ni les déplacer, tandis que, une fois ces objets découverts, la transformation de la photographie d’un sol mais surtout d’un objet en dessin est nécessaire pour pouvoir mieux saisir les orientations des formes et les traces de la fabrication des objets. Mais dans les deux cas, de l’imagerie et du dessin, l’objectif est toujours le même : faciliter la comparabilité entre différentes données et différents objets, objectif qui n’est pas facilement atteignable par la photographie entendue en tant qu’empreinte.

2. La représentation des stratifications temporelles

On voit bien que les deux disciplines se révèlent comme très différentes à l’égard des objectifs et des méthodes d’investigation (montrer l’existence d’un objet et étudier ses propriétés physico-chimiques pour l’astrophysique, montrer les processus de constitution et de conservation des objets dans le temps pour l’archéologie). Mais toutes deux visent, comme but final de l’investigation visuelle, la représentation des strates temporelles, et plus précisément cherchent à savoir comment l’état présent des choses empêche de voir le passé dans le cas de l’archéologie, comment le passé et le présent d’un astre permettent de prédire le futur en astrophysique.

- Note de bas de page 21 :

-

Il s’agit de procédures non invasives à inventaire, qui sont liées à une chronologisation relative qui vise à étudier la relation entre strates du sol et du sous-sol, à l’inverse de la méthode de la fouille, invasive, qui est liée à une chronologie absolue qui vise à faire correspondre des objets et des événements à des phases précises du passé. Pour plus de précisions à ce sujet cf. A.a.V.v. (2006).

L’analyse des méthodes prendra ici en considération, pour l’archéologie, la prospection aérienne et surtout les prospections géophysiques, deux méthodes non invasives21. Les prospections géophysiques rendent possible la détection des processus qui ont présidé à la formation du sous-sol via la visualisation des propriétés de ce dernier. La prospection aérienne est bien une photographie, mais une photographie qui, comme le dessin, permet de mettre en valeur des caractéristiques choisies du sol. Cette prospection permet une vision autographique orientée par des codages allographiques : il s’agit d’une photographie sélective permettant de s’émanciper du localisme de l’empreinte photographique et d’atteindre à un certain degré de contrôlabilité et reproductibilité de ces résultats ; ces genres de prospections aériennes permettent la digitalisation des données et ensuite leurs manipulabilité.

- Note de bas de page 22 :

-

Voir à ce propos Nazé (2010).

En ce qui concerne l’astrophysique, je prendrai en considération l’analyse spectrale et la mise en relation des détections selon différentes longueurs d’ondes se situant entre l’astronomie gamma et l’astronomie radio et permettant la détection des évolutions temporelles des différents astres. Le spectre d’un astre permet l’individuation de sa température, la composition chimique, la vitesse de rotation et donc des procès de sa formation, durée et explosion. La caractéristique de l’astrophysique est que le spectre électromagnétique permet la facile transduction entre une détection et l’autre, une longueur d’onde et l’autre : le spectre électromagnétique permet de prendre en compte comment un objet détecté dans une longueur d’onde est visualisable (ou pas) à travers une autre longueur d’onde, à une autre échelle22, etc. Grâce au spectre électromagnétique qu’on pourrait nommer un instrument traducteur, l’astrophysique est capable de rendre facilement comparables les traces et les données des processus du ciel. Ces données deviennent des data set disponibles, par implémentation informatique, pour un nombre infini de visualisations selon différents points de vue et angles de pertinence. Ces visualisations en série visent la construction d’un répertoire d’images utiles pour modéliser d’autres réalités à analyser. Chaque configuration de données devient ainsi reconfigurable à partir d’un changement contrôlé de ses paramètres de visualisation et changement de perspective en vue de l’exploration. Il ne s’agit donc plus ici de la notion classique d’image qui se constitue en tant que telle à travers la stabilisation en une iconographie, mais d’un environnement virtuel qui produit des modes d’actualisation possibles de données (visualisations).

3. L’image et la visualisation en astrophysique

Partons de l’astrophysique et de l’analyse spectrale, en examinant trois types d’images qui permettent d’envisager trois moments différents dans la construction des iconographies et qui témoignent de trois manières de codifier visuellement les procès temporels.

Je partirai avec la description des images-résultats, les images finales des astres, qui intègrent dans leurs topologie plusieurs détections différentes de la lumière et qui composent l’iconographie de ce qu’on a appelé un « objet », dans ce cas spécifique un objet astral. Je poursuivrai ensuite avec les second type d’images, les visualisations « partielles » des astres qui dépendent d’un seul instrument de détection et qui doivent ensuite être intégrées à d’autres visualisations pour devenir elles aussi des images constituant un objet. Le troisième type d’images concerne des visualisations de forces lumineuses (images-mesure), qui se révèlent comme des cartes qui doivent encore être configurés en des visualisations partielles d’un astre.

Les images-résultats et les images-mesure peuvent être considérées d’une certaine manière comme des images appartenant au régime autographique. Mais il s’agit bien évidemment de deux autographies différentes. Par contre, les visualisations partielles partagent certaines caractéristiques du fonctionnement allographique et sont proches de ce qu’on vient d’appeler « environnement virtuel ». On y reviendra.

Notre description des trois types d’images procédera donc avec une orientation par démontage avec les images d’astrophysique (le parcours qui va de l’image-résultat à l’image-mesure qui recueille les premières données) et par montage avec les images d’archéologie (le parcours qui va de l’image qui recueille les premières données jusqu’à l’image finale).

3.1. Les images-résultat

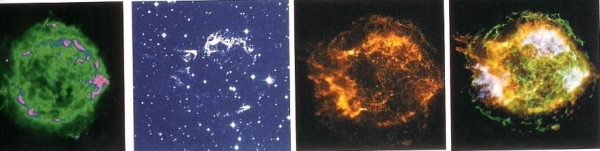

Comment faire pour connaître l’âge, le moment de la naissance et de la mort des astres ? C’est à travers la collecte de la lumière selon les différentes longueurs d’ondes qu’on peut identifier l’histoire d’un astre. Prenons le cas des nébuleuses, qui évoluent très rapidement. La nébuleuse est un résidu des gaz éjectés par une étoile agonisante. Ceci est l’image de la spirograph nebula (Photo 1).

Photo 1. NASA et The Hubble Heritage Team. http://apod.nasa.gov/apod/ap021214.html (image libre de droit)

La profondeur spatio-temporelle du ciel peut être saisie et mesurée à travers la collecte de la lumière dans différentes longueurs d’onde. Ces longueurs d’ondes qui sont censées être des sensibilités à travers lesquelles les phénomènes astraux se manifestent, nous communiquent des informations sur les transformations chimiques, de températures, de vitesse de rotation, etc. Déjà à partir des fréquences de détection qui se révèlent pertinentes à la détection on peut faire des hypothèses sur la durée des événements, étant donné qu’à partir des zones du spectre susceptibles à la détection on peut prévoir les rythmes et les vitesses de développement de ces mêmes événements.

Ces types d’images, qui sont présentes surtout dans les textes de vulgarisation scientifique, rassemblent les diverses captations de lumière obtenues dans les différentes longueurs d’onde et s’offrent comme des documents d’identité des astres, des documents qui ne sont pas des photographies de ce que l’objet est au moment de la captation, mais de son histoire (passée et future). Cette image est une mosaïque construite par sommation intégrée des processus de transformation de l’astre qui sont codifiés en des phases de la vie (naissance, développement, mort). Ce sont des images qu’on pourra nommer des cartographies temporelles parce qu’elles identifient un objet : c’est l’espace temporel d’existence entier d’une nébuleuse qui est cartographié, et qui est présent dans l’image — qui fonctionne par conséquent comme une synthèse spatiale des temporalités accumulées et prévisibles. Cette image codifie par les biais des configurations chromatiques, eidétiques et topologiques, des informations recueillies par les différentes détections. Cette codification finale intègre les informations partielles et les fixe dans une iconographie. On peut aussi l’appeler image « finale » d’un astre parce qu’elle peut être saisie comme la transduction de plusieurs scénarisations (les différentes détections selon des longueurs d’onde différentes) qui permet enfin une intelligibilité des transformations passées (qui déterminent celles futures). L’intégration de différentes scénarisations (visualisations partielles) que cette image synthétise en fait une image clôturée et par conséquent une domestication fictive d’une observation potentiellement interminable et d’investigations potentiellement infinies. C’est cette domestication qui rend possible l’institutionnalisation d’un objet de connaissance.

3.2. Les visualisations en série

Celles que nous avons appelées jusqu’ici des visualisations partielles d’un astre mettent en scène non pas la commensurabilité des détections et leur stabilisation finale, mais justement les différents modes de détection d’un même astre.

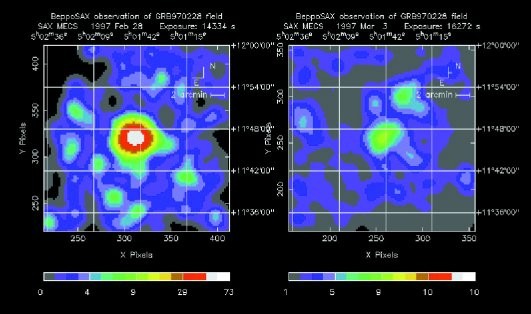

Ces quatre images montrent le résidu de la supernova Cassiopée A (Photo 2).

Photo 2. http://chandra.harvard.edu/photo/1999/0237/. De gauche à droite : NRAO/AUI ; MDM/R. Fesen ; NASA/CXC/SAO ; NASA/CXC/SAO. (Images libres de droits)

La première est une image radio, la deuxième optique et les deux dernières ont été obtenues par le télescope Chandra aux rayons X à une distance de quelques années l’une de l’autre. À partir des restes de l’explosion qu’on obtient avec l’image radio, et la mesure de sa vitesse d’expansion obtenue grâce à la troisième image, en rayons X, les astrophysiciens ont pu faire l’hypothèse, à partir des théories de la relativité générale, qu’elle a dû exploser en 1680 ; avec un nouveau dispositif du télescope Chandra on a pu confirmer enfin ces hypothèses sur la date de l’explosion. La possibilité d’obtenir une bonne datation dépend ainsi de la synchronisation entre les événements du ciel et les avancées techniques.

- Note de bas de page 23 :

-

Par exemple, en ce qui concerne les supernovas, il a fallu attendre les avancées techniques de l’astronomie X et gamma pour pouvoir fabriquer des cartographies temporelles comme on en a eu un exemple toute à l’heure. La vie adulte d’une supernova est détectable à travers des longueurs d’ondes à basses fréquences comme les longueurs d’onde du visible ou de l’infrarouge, mais sa naissance est détectable dans les rayons UV, rayons X ou gamma, à savoir dans les observations astronomiques qui seules captent des phénomènes à des fréquences élevées, et qui n’ont pas été possibles jusqu’il y a peu de temps. En effet, le moment de l’explosion/naissance est obtenu à travers des détections qui sont devenues fiables au cours de 20 dernières années ; au contraire les processus de la vie adulte de l’astre ont été détectés il y a plus que 40 ans à travers les captations dans la longueur d’onde des rayons visibles. C’est pour cela qu’il peut arriver qu’on identifie des processus sans pouvoir les « caser » comme appartenant aux bons objets dont on postule l’existence.

Ces images témoignant des moments d’observation différents doivent se traduire mutuellement afin de composer une cartographie temporelle qui stratifie toutes les phases de l’événement. Cette série d’images met en scène le rapport entre les différentes puissances des domaines de détection et l’effort progressif pour recueillir tous les éléments nécessaires pour la constitution d’une image finale et donc d’un objet. Ainsi, elles problématisent le fait que les avancées technologiques que les différentes détections permettent ne s’effectuent pas parallèlement à l’évolution chronologique des astres. Si l’on ne peut pas identifier la date de naissance ou de mort de certains astres, par exemple, c’est parce qu’on n’arrive pas à « capitaliser » l’alignement des traces de lumière obtenues à travers les diverses captations par les différentes astronomies23. Chaque phase de la vie d’un astre, chaque processus qui a lieu en un certain laps de temps n’est captable que par certaines longueurs d’onde. Il existe des astres dont on a pu obtenir l’histoire complète et d’autres dont l’image-cartographie attend encore des confirmations par d’autres détections superposables : très souvent on arrive à dater la naissance d’un astre très longtemps après les premières observations de sa vie adulte.

Comme on l’a dit, les images-cartographies feront la synthèse des divers moments d’observation et de détection contenus dans les visualisations partielles. Cette partialité n’est pas une partialité de structure visuelle : il ne s’agit pas de « parties » de l’objet qu’on pourrait identifier en des formes constituées. Il s’agit des « parties » qui sont identifiables par des événements temporels, ou bien des transformations chimiques, qui peuvent se dire constituant des unités parce qu’elles sont déterminées par des valeurs similaires et censées être regroupées en unité. Ces unités sont constituées à partir des similitudes établies par des cohérences temporelles et d’homogénéité de fonctionnement et elles acquièrent le statut de parties d’un objet global, voire l’astre. Ces parties sont visualisables en tant que distances, nuances chromatiques, contours plus ou moins nets, mais pas en des parties de formes constituées. Les formes pourraient se dire constituées lorsque l’iconographie finale d’un astre est stabilisée et acceptée par la communauté scientifique.

Les visualisations partielles ne sont justement pas des images parce qu’elles n’ont pas encore trouvé une stabilisation iconographique ni institutionnelle. Elles sont des visualisations qui actualisent des valeurs d’un environnement virtuel et qui, étant des unités distinctes, sont combinables avec d’autres unités selon un alphabet qui est stabilisé par le spectre électromagnétique et une grammaire qui est déterminée par les règles qui se sont constituées tout au long de l’histoire de la discipline.

3.3. Les images-mesures

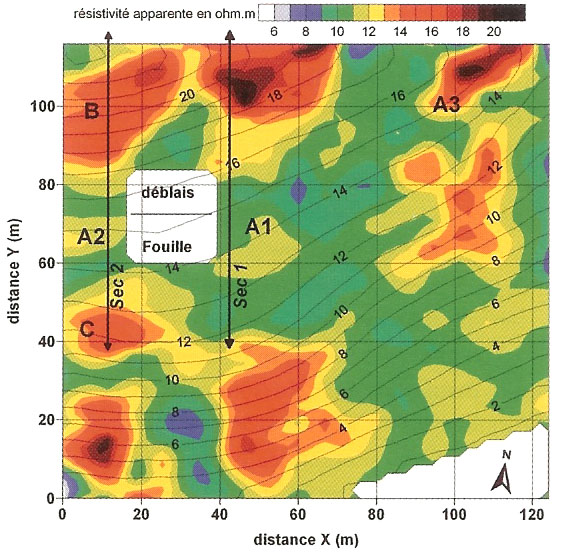

Si l’on peut considérer la première image comme une image composite qui met en scène la sommation des données par superposition, et les quatre visualisations en série comme des confirmations par différentes méthodes de détection et des preuves mutuelles de l’existence de quelque chose d’homogène qu’on pourra ensuite appeler un objet, cette troisième image (photo 3) est de type encore différent.

Photo 3. BeppoSAX/Team.

http://apod.nasa.gov/apod/image/9703/grb970228_sax_big.gif (images libres de droits)

Cette image mettant en scène la première localisation exacte d’un sursaut gamma en rayons X par le satellite Beppo-SAX assume le statut d’épreuve des procédures de mesure. Elle n’identifie pas un sursaut en tant qu’objet, mais des « réponses » contrôlées aux tentatifs d’identifier les valeurs pertinentes à l’apparition d’un phénomène dont on avait postulé une classe de possibles apparitions et fonctionnements. Ceci n’est pas une image de quelque chose, mais bien une carte qui permet de visualiser en unité les différentes sensibilités de la lumière à un même événement. Cette image montre donc la sensibilité relative des divers domaines de longueurs d’onde à un même phénomène ; on obtient ainsi les valeurs de ce phénomène à travers la visualisation des différences chromatiques et des distances entre ces dernières. Ces distances représentent l’espace-temps qu’il faut pour que les sources de l’événement parcourent tous les domaines de sensibilité du spectre, des ondes gamma aux ondes radio. En fait, lorsqu’on veut calculer le moment de l’explosion d’une étoile qui a abouti à la formation d’un trou noir, l’image-mesure nous montre à quelle distance spatio-temporelle par rapport à notre espace-temps cette explosion a eu lieu. On obtient cette distance à travers le calcul de la progressive différence d’intensité d’émission de la lumière dans les différents domaines de longueurs d’onde — des résultats gamma jusqu’aux résultats des astronomies visible et radio tout au long d’un certain laps de temps. Par exemple, dans les cas de la formation des trous noirs, leurs champs gravitationnels provoquent une telle libération d’énergie que seul le domaine gamma peut détecter. Mais l’astronomie gamma, manquant de capteurs à haute définition pour détecter les sursauts, ne peut donner des informations sur les sources des explosions des astres et de la formation de trous noirs qu’en calculant la distance temporelle qu’il faut à ces sursauts pour devenir détectables en tant que résidus par les autres longueurs d’onde. On doit donc attendre que les sursauts gamma refroidissent et deviennent visibles aux rayons X après quelques heures ou dans le domaine optique après quelques jours et dans le domaine radio après quelques semaines. Cette image montre que la captation des sursauts résiduels aux rayons X a permis d’identifier les astres à partir desquels l’explosion d’une étoile et la formation d’un trou noir ont eu lieu. L’écart entre le rouge et les autres couleurs met en scène la distance entre la source de l’explosion et les sources de la détection : plus l’écart du rouge au bleu et au vert est important, plus la source est distante et plus notre regard vers le passé est puissant. Le rapport spatial, que la grille rend mesurable, entre le bleu et le rouge en passant par le vert et le jaune, montre la durée du refroidissement progressif du sursaut.

3.4. Enonciation de phénomènes, énonciation de règles

Comme on l’a dit au début de ce chapitre sur les trois types d’images, le premier type concerne une cartographie temporelle qui implique un régime iconographique accepté et stabilisé : il s’agit d’une image finale et isolée, destinée surtout aux genres de la vulgarisation. Dans le troisième cas nous sommes face encore une fois à une cartographie, mais cette fois il s’agit d’une cartographie qui ne stabilise pas un objet à travers une iconographie, mais qui met en scène la topologie de valeurs lumineuses qui pourront aider la compréhension d’un phénomène jusqu’à maintenant seulement postulé. Elle montre les zones de frontière entre les mesurages qui vont constituer un événement dont les phases sont déterminées encore une fois par les différentes sensibilités à la lumière. Avec la première image, l’image-résultat, on est au bout de la chaine des codifications des données, avec l’image-mesure on est au début de la chaine. La seule codification visible est le maillage qui permet de croiser les intensités des valeurs lumineuses avec leurs étendues dans la topologie de l’espace céleste.

Si ces deux images sont des cartographies, il faut remarquer qu’elles manifestent un rapport très différent avec leurs instruments de fabrication. L’image-mesure dénonce son dispositif énonciatif ce qui en fait une image susceptible de devenir un lieu d’opérativité et de manipulation. Les paramètres qu’elle met en scène permettent la poursuite de l’investigation, aussi bien la manipulation des résultats qu’une éventuelle simulation qui permettrait de répéter l’événement. L’image-résultat par contre ne nous donne aucun ancrage spatial, aucune information sur ses échelles, voire sur les références spatio-temporelles de son énonciation (d’ailleurs les énonciations sont multiples…). On voit bien que les procédures de traduction des détections différentes, de composition d’une commensurabilité et de stabilisation de l’iconographie d’un objet ont lieu au détriment de la révélation et de la mise en scène du/des dispositifs qui ont rendu possible l’existence de cet objet lui-même. D’une certaine façon on pourrait dire que l’objet final apparaît une fois que son énonciation a été masquée, cachée, presque éliminée ce qui est un fait un peu paradoxal. D’ailleurs toutes les images et les visualisations qui présentent les dispositifs qui ont permis leur énonciation ne sont que des images intermédiaires, des images-laboratoire qui fonctionnent comme des passeuses.

Avant de décrire les caractéristiques des visualisations en série (ou visualisations partielles) je voudrais revenir sur la question de l’autographie de ces deux types d’images dont il est question. J’ai remarqué en passant, au chapitre 3, que les images-résultats et les images-mesure peuvent être considérées comme des images appartenant au régime autographique. Comme je le disais, il s’agit évidemment de deux autographies différentes. Selon la définition la plus classique d’autographie, on pourrait dire que l’image-mesure enregistre des traces d’un phénomène et dans son support conserve la trace de l’espace d’origine du phénomène. On pourrait dire que l’image est en partie autographique parce qu’elle témoigne de la configuration unique des relations et des frontières entre valeurs lumineuses comme elle a été « prise » lors d’une explosion. Ensuite ces relations et ces frontières pourront être manipulées, mais dans ce dernier cas, elles ne témoigneront plus d’un événement, mais de différentes manières de le rendre utilisable pour d’autres objectifs scientifiques. Si dans ce cas on pourrait donc parler d’une autographie inchoative — et qui est censée être dépassée pour laisser la place à des visualisations partielles, voire à des visualisations de chaque détection, à l’occasion ré-combinables —, dans le cas de l’image-résultat on pourrait parler d’une autographie terminative. En fait, il s’agit d’une autographie obtenue non pas par conservation des traces, mais par construction de commensurabilité d’investigations et ensuite par stabilisation de résultats et institutionnalisation des formes. Le fait que ces images-résultat ne permettent plus de contrôler leurs dispositifs énonciatifs montre bien qu’elles sont devenues des images non-manipulables, presque auratiques, comme les tableaux artistiques. Les images-résultat excluent la manifestation des échelles : dans la vulgarisation tout se nivelle. Même si ces images sont produites par une composition de visualisations partielles, qui sont recombinables à l’intérieur de ce qu’on a appelé un environnement virtuel, elles tendent à nous le faire oublier parce qu’elles cachent leurs moyens de fabrication et se manifestent comme des images finales et définitives chosifiant un objet. Elles veulent offrir sur cet objet le dernier mot, au-delà duquel on ne va pas : c’est pour cela qu’elles suppriment toute référence à des paramètres qui pourraient les rendre encore manipulables et opératives. C’est comme cela arrive avec les tableaux et d’autres œuvres d’art : en art on signe pour dire que chaque trait est le bon, le définitif, et qu’on ne peut plus rien modifier, ici on supprime les échelles et les références à l’énonciation. Ces images « muséifient » les résultats des investigations qui les ont constituées ; il y a donc un fort rapport entre le régime de la stabilisation/institutionnalisation d’un objet scientifique voire de la vulgarisation et celui de l’œuvre d’art. Dans les deux cas, l’image se manifeste comme quelque chose sur quoi on a mis le mot « fin ».

- Note de bas de page 24 :

-

La mise en scène des quatre détections montre les parcours pas toujours parallèles entre la progression chronologique de la vie d’un astre et les phases de la recherche scientifique.

Au contraire, dans le deuxième cas, exemplifié par la séquence de visualisations partielles de Cassiopée A, nous sommes face à un régime discursif qui prend en compte des avancées expérimentales et montre les ajustements d’une recherche en acte24. Ces visualisations montrent, au contraire que l’image finale, qu’un objet astral n’est pas une chose unique, unifiée, mais le résultat de valorisations et de filtres différents qui peuvent plus ou moins l’actualiser. Ces filtres et les paramétrages sont visibles non pas à travers un maillage, comme dans le cas de l’image-mesure, mais ils sont visibles grâce au fait que les visualisations-actualisations sont disposées en série : le rapport entre elles est mis en évidence et c’est cette mise en relation, cette « équivalence » entre les visualisations qui montre qu’une grammaire de la manifestation d’un astre peut exister, qu’on peut la constituer à travers le couplage entre des visualisations disjointes et des comportements astraux. Une fois cette grammaire établie, on peut même tenter des simulations et prédire comment un astre avec telles et telles caractéristiques pourrait/devrait se comporter. La mise en rapport et la recherche des commensurabilités entre différents domaines de détection devrait justement permettre de constituer une grammaire. Cette grammaire est ce qu’on a appelé environnement virtuel, qui peut être actualisé par les différentes visualisations.

4. La superposition des images an archéologie

- Note de bas de page 25 :

-

J’entends ici par syntaxe figurative la manière dont les formes s’inscrivent et se stabilisent sur un support. A ce sujet cfr. Fontanille (2004).

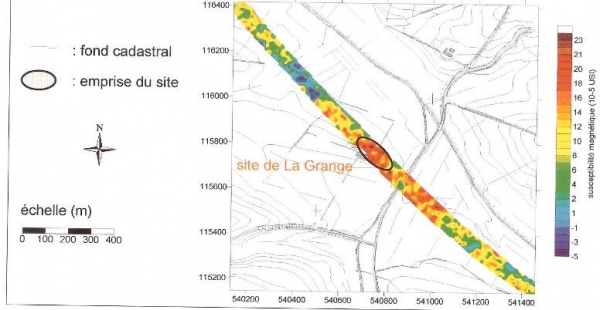

Je vais aborder à présent, bien plus brièvement, les stratégies de fabrication des images en archéologie. L’image suivante (Photo 4), qui apparaît, en termes de syntaxe figurative25, comme très semblable à la troisième image décrite dans le domaine de l’astrophysique, appartient à la prospection géophysique, et plus précisément à la prospection électrique.

Photo 4. Bordeneuve à Beaugas, Lot-et-Garonne, 1988. Superposition de l’image électrique horizontale et de la topographie. Image publiée dans Martinaud (2005 p. 30).

- Note de bas de page 26 :

-

Cfr. a ce sujet Aa.Vv. (2005a).

Cette méthode exploite une propriété physique, la résistivité électrique, afin de prélever des informations sur les structures du sous-sol. Cette propriété physique permet de caractériser la difficulté que le courant électrique rencontre en traversant certains matériaux, comme par exemple les terrains argileux. On peut obtenir les mesures des résistivités électriques en injectant dans le sol un courant de faible intensité et de fréquence connue. Ce courant crée dans le sol un potentiel électrique variable dans l’espace mesuré ; la différence de potentiel énergétique entre le courant injecté et la réponse des zones du sol donne comme résultat les valeurs de la résistivité électrique. Voilà qu’on retrouve dans les méthodes de la géophysique ces stratégies de fabrication des images qu’on pourrait nommer d’énonciation / exploration en suivant Jacques Fontanille (2007) qui en a décrit le fonctionnement dans l’imagerie médicale et dans le domaine de la biologie. Dans l’imagerie l’actant de l’énonciation qui permet la fabrication des visualisations n’est pas la lumière, mais un processus d’exploration induit artificiellement en laboratoire se fondant sur des tensions entre excitation et relaxation des orientations de forces (qui se manifestent par exemple dans un organe) : l’excitation de certaines sensibilités et les réponses à cette excitation sont exploitées pour produire des images qui sont conçues comme révélatrices26.

Dans cette image, les différences chromatiques entre le rouge et le vert renvoient aux différences de résistivité électrique des différentes zones du sous-sol et donc à la présence de structures plus ou moins profondes, plus ou moins dures, plus ou moins calcaires, plus ou moins bien conservées. Le contraste entre les propriétés physiques dans les diverses zones d’un même milieu permet de faire des hypothèses sur les structures présentes dans le sous-sol, sur leurs positions dans la profondeur et sur leur état de conservation. Le quadrillage que l’on voit sur l’image sert d’instrument de paramétrage : ce quadrillage est projeté sur l’image électrique et mesure la distance entre un point et l’autre de la zone prise en considération (à savoir la distance entre les électrodes présentes dans le sol). C’est grâce à ce quadrillage qu’on obtient des résultats interprétables et ensuite répétables.

Comme le montrent cette autre image (photo 5), pour pouvoir déterminer le lieu de la fouille ou les endroits où il faut prendre d’autres mesures à travers d’autres méthodes d’investigation, il faut mettre en rapport les résultats de différentes résistivités électriques témoignées par les zones chromatiques avec d’autres formes de représentation, tel par exemple le fond cadastral.

Photo 5. Site de la Grange, Haute Garonne. Image publiée dans Marmet et alii (2005), p. 38.

- Note de bas de page 27 :

-

La prospection aérienne vise à étudier les anomalies du sous-sol à travers au moins quatre types d’indicateurs au sol : 1) les indicateurs phytographiques, qui révèlent les anomalies de la végétation là où il y a des perturbations du sous-sol ; 2) les indicateurs hydrographiques qui n’apparaissent qu’en présence de certaines situations climatiques, tel par exemple un orage ; 3) les indicateurs pédographiques, dus aux différences de la couleur du sol qui révèlent les cultures anciennes ; 4) les microreliefs qui sont visibles par une lumière radiante.

La concentration du rouge indique une zone où les valeurs de la résistivité sont très élevées et la présence de structures plus superficielles ou bien plus calcaires qu’aux alentours. D’autres images mettent en scène des stratégies représentationnelles différentes se superposant (fond cadastral et prospection électromagnétique, dessin 3D de la stratification des strates du sous-sol et photographie aérienne, etc.). Les superpositions les plus intéressantes pour notre comparaison sont pourtant celles qui mettent en relation les images-mesures de la prospection électromagnétique avec les images produites par la prospection aérienne27.

Quand on superpose les images produites par la prospection aérienne et celles de la prospection électromagnétique, par exemple, on obtient des images comme celle-ci (photo 6) où l’hétérogénéité des méthodes de détection, à la différence de l’astrophysique, produit une hétérogénéité irréductible. Cette hétérogénéité offre ce qu’on pourrait appeler une intravision diagrammatique.

Photo 6. Prospections magnétiques autour des palais de rois perses, superposées aux photos aériennes par le centre archéologique de Persepolis ; image publiée dans A.a.V.v. (2005), p. 11.

Dans cette image on a affaire à deux syntaxes figuratives juxtaposées : l’intravision diagrammatique est justement un interstice entre deux systèmes de pertinence, entre deux régimes de regard et d’investigation. L’intravision diagrammatique est une forme de visibilité nouvelle produite par la transposition réciproque de deux régimes de pertinence perceptive et de la résultante de deux unités de mesure dont il faudrait trouver une commensurabilité. L’intravision diagrammatique est une vision interstitielle qui permet d’apercevoir une possible transposabilité de relations d’un système d’investigation à l’autre.

On s’aperçoit que les choses se passent de manière très différente en archéologie par rapport à l’astrophysique : on pourrait dire qu’ici aussi on a des visualisations partielles, mais ces visualisations partielles ne sont pas censées trouver une transposabilité totale, ni l’homogénéité qui est par contre garantie par le spectre électromagnétique en astrophysique. Ici la transponibilité doit rester simplement possible. A travers ces méthodes d’investigation on n’a pas comme résultat des objets définitifs, mais seulement des cartes qui peuvent nous donner des indications sur des actions futures, plus ou moins envisageables et prometteuses.

Dans notre image cette commensurabilité envisagée est supportée sur le plan de l’expression par des réseaux de relations qui se caractérisent de manière contrastive et qui permettent de construire sur le plan du contenu des valeurs différentielles. Mais il ne s’agit pas de simple isomorphisme entre les plans. L’intravision diagrammatique est au contraire dynamique parce qu’elle permet de reconstruire des patterns en évolution, voir saisir des syntaxes, à la fois sur le plan de l’énoncé (processus des événements observés) et sur le plan de l’énonciation (processus d’investigation).

5. Superposition intégrée et superposition diagrammatique

- Note de bas de page 28 :

-

Le rapport entre recherche et vulgarisation est très différent en astronomie et en archéologie. En effet, en archéologie, la vulgarisation n’est pas une véritable « traduction » des genres discursifs consacrés à la recherche, elle a une totale autonomie et ses sujets sont centrés sur la mythisation des grandes civilités et des célèbres personnages du passé. Comme en astrophysique pourtant elle privilégie la mise en scène d’objets plutôt que des processus de constitution.

Les images-mesures partagent la même syntaxe figurative en astronomie et en archéologie28, mais les images composites finales sont tout à fait différentes et c’est sur cela que je voudrais porter mon attention pour avancer des conclusions.

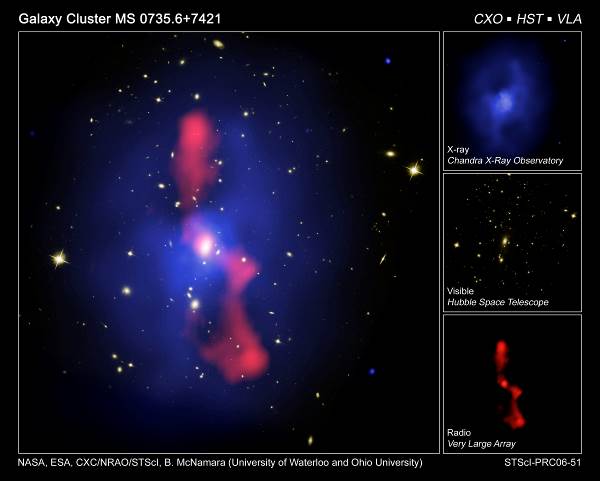

Les images en astrophysique visent à sommer, superposer, intégrer — phagocyter presque — les traces, bref à réduire l’hétérogénéité des captations dans une seule image comme dans l’exemple de l’amas de galaxie ci-après (photo 7) qui montre très clairement comment l’image finale intègre les images provenant des différentes détections afin de stabiliser l’identité d’un objet.

Photo 7. http://imgsrc.hubblesite.org/hu/db/2006/51/images/a/formats/print.jpg

- Note de bas de page 29 :

-

A ce sujet cfr. Latour (1985).

Ainsi conçue, l’image d’un astre vise à un double but : construire une bonne référence pour l’astre en question (autographie), mais les visualisations dont elle est constituée fournissent une base de comparaison pour d’autres astres par le fait de composer et recomposer les relations entre processus temporels et captations lumineuses. Ces relations fournissent en effet des modules commensurables et superposables (allographie). En astrophysique, enfin, la « bonne » référence finale peut être confirmée moins par l’invariance iconographique que par les manipulations qu’elle permet à travers les visualisations partielles impliquant des filtrages, des ajustements paramétrés, etc., lesquels peuvent s’avérer utiles pour la formulation de nouvelles hypothèses et découvertes. En astrophysique, comme dans beaucoup d’autres disciplines, plus une référence va loin, plus elle devient efficace29, car elle se révèle davantage utilisable. Cela se produit lorsque ses modules sont articulables : la fiabilité de la référence est coextensive du réseau de diffusion, de sa plasticité, c’est-à-dire — encore une fois — de la modularité permise par l’intégrabilité des différents systèmes de détection. La vérification/falsification d’une image finale est l’issue d’une confrontation entre les données captées dans une longueur d’onde et les données captées dans une autre longueur d’onde.

Dans l’image finale de l’amas de galaxie tout se passe comme si les visualisations qui la composent possédaient une consistance « transparente » par rapport aux autres visualisations (règles de notationnalité), le but final étant une superposition qui homogénéise les traces des captations différentes. Tout se passe comme si les visualisations partielles visaient à compacter dans l’image finale ce qui dans l’univers est dispersé — puisqu’il s’agit de construire des simulacres de cohésion de ce qui en réalité est diffus dans le temps et dans l’espace. L’image finale est toujours celle qui a assimilé toutes les mesures : c’est dire que le point d’arrivée de l’iconographie astronomique est l’homogénéisation des traces. Cette image a en fait comme but de compacter les processus différents de l’univers en une cartographie qui totalise et intègre les processus temporels en les transformant en des phases : la naissance, la croissance et l’extinction d’un astre. Dans ces images finales il s’agit de dater par le biais d’une étude des processus (de transformation chimique, de température, de rotation, etc.) pour ensuite profiler des phases du développement de l’astre (naissance, explosion, extinction, etc.). Les images en astrophysique visent enfin à transformer les processus en phases. Or, tout cela est loin d’être vrai pour les images de l’archéologie, où une mesure et une méthode de détection n’est jamais intégrée ni totalement intégrable à l’autre. En archéologie, les images-cartographies ne visent point à l’intégration des traces, ni à devenir des images-modèle pour une série d’autres investigations (allographie) : tout au contraire, elles mettent en scène l’hétérogénéité des méthodes de recherche (intravision diagrammatique), leur impossibilité à se recomposer en unité. Cette impossibilité d’homogénéisation permet non seulement une double ou une multiple vision du même événement (ce qui arrive aussi dans le cas de l’astrophysique), mais aussi et surtout une méta-vision, une vision nouvelle sur les possibles commensurabilités et incommensurabilités de points de vue. C’est la non commensurabilité totale qui permet l’investigation dans le cas de l’archéologie, une investigation qui se fonde sur la dissimilation des traces. Chaque image composite en archéologie doit montrer la diversité des méthodes de mise en relation des surfaces avec le sous-sol, ou des différentes parties du sous-sol ; chaque méthode d’investigation stratifiée dans l’image composite met en scène un processus d’exfoliation de quelque chose de compact. Tout se passe comme si chaque système de captation pouvait représenter le « prélèvement successif » des couches stratifiées dont le sous-sol est constitué : les stratégies de captation ainsi que les stratégies de mise en scène de ces captations visent à dissimiler les stratifications. L’ensemble visuel composé des résultats obtenus à travers les paramètres différents met en scène l’effort pour porter au jour, à la surface, ce qui est enfoui en profondeur, voire d’extraire l’hétérogène là où il y a une homogénéité apparente.

En somme, la fonction des images en archéologie est tout à fait différente de celle qu’elles assument en astrophysique : à partir de l’homogène et du compact, il faut parvenir à une exfoliation du sous-sol, en en montrant toute la diversité. Chaque couche doit en montrer une autre, ou plusieurs autres, dont elle peut extraire : c’est par la dissimilation que l’on peut parvenir à voir et opérer. C’est ce même processus d’extraction que l’image est censée mettre en évidence via l’intravision diagrammatique.

Pour conclure

Les images de l’astrophysique et de l’archéologie présentent deux types différents de virtualité de l’objet de la perception : l’objet de l’astronomie est absent à nos sens, caché, parce qu’il est trop diffus et lointain, distal, alors que l’objet archéologique est caché parce que sa stratification est trop compacte. Il s’ensuit qu’en astrophysique les images actualisent l’objet par des assimilations qui compactent l’évanescent, à travers des plaques/modules commensurables du spectre alors qu’en archéologie les images fonctionnent par dissimilation de ce qu’elles actualisent, c’est-à-dire par dissimilation au sein d’une matière stratifiée et compacte. En astrophysique, on opère par superposition et ajustement de modules et de stocks de lumières ; en archéologie, par différenciation d’enveloppes et de pellicules des couches. Les hypothèses sur les temporalités doivent par conséquent être formulées à travers l’identification de la succession des hétérogénéités de ces enveloppes et pellicules.