Faire voir à tout prix

Pourquoi ne peut-on se passer d’images ?

- Note de bas de page 1 :

-

Sicard (1998, p. 9).

La science vise à expliquer les phénomènes. Et le fait est qu’elle s’y prend de préférence par une démarche de visibilisation. « Porter l’invisible au visible », selon la formule de Monique Sicard dans son livre La fabrique du regard1 tel est son programme.

Mais énoncer ceci est soulever une foule de questions : comment se manifeste ce déport de l’invisible au visible ? et surtout, pourquoi ce tropisme du discours scientifique pour la vision ? Et si des questions se posent à propos de ce privilège réservé à la vision, d’autres, pas moins nombreuses, s’adressent à l’invisible, et qui ont été bien formulées par l’introduction d’Alvise Mattozzi au présent colloque. Si nous ouvrons le dictionnaire, nous y lisons que l’invisibilité est l’état de ce qui ne peut être vu. Une telle définition pose d’autres questions, toutes liées entre elles : de quelle nature est le « ce » de la proposition (un objet concret ? un concept ? et si c’est un objet, pourquoi ne peut-il être vu ?) ; un tel état d’invisibilité est-il une essence ? dans quel sens faut-il entendre « état » ? autrement dit, est-il permanent ou transitoire ? Et encore et surtout : quel est le lien entre l’invisibilité et l’inexistence ? entre la visibilité et intelligibilité ?

1. Un recentrage universel sur le visuel

Avant d’aborder ces questions, que je n’ai pas la prétention d’épuiser, observons de manière un peu technique comment se manifeste l’impérialisme du visuel, qui m’a suggéré mon titre, « Faire voir à tout prix ».

Car c’est bien d’impérialisme qu’il s’agit. Les récepteurs de l’œil travaillent sur un empan de longueur d’ondes extrêmement restreint dans le champ des ondes connues : de 390 à 820 nanomètres (milliardièmes de mètres) exactement. Or, on constate que tout est mis en œuvre pour ramener, à toute force, le plus de données possible à l’intérieur de cette zone étroite. Je vais décrire trois formes simples de ce mouvement de concentration, mais un quatrième type de recentrage nous interpellera par la suite.

1.1. Premier recentrage : de l’œil nu à l’œil équipé

- Note de bas de page 2 :

-

Cg. essai ici publié.

Le premier recentrage concerne les invisibilités des types 2 et 4 décrits par Stéphanie Requier2.

Ce recentrage opère par la visualisation de phénomènes spatiaux en droit visibles — parce qu’ils pourraient se manifester à l’œil par des radiations situées dans l’empan 390-820 —, mais qui ne le sont pas dans les faits, pour des raisons pratiques. Invisible est donc ici simplement synonyme d’accidentellement inaccessible à la vision humaine. Des objets ou des processus visibles se trouvent ainsi hors de portée de la vision pour deux séries distinctes de raisons : (a1) soit parce qu’ils sont cachés par un obstacle (une cloison, une concrétion osseuse, une couche de terre…), soit (a2), ce qui revient au même, parce qu’ils sont maintenus hors d’atteinte à cause du point de vue pris par l’observateur, (b) ou encore parce que l’échelle de l’espace où ils se manifestent n’est pas compatible avec celle où opère la perception visuelle humaine. Invisible signifie donc ici inaccessible à l’œil nu. Cette échelle extrahumaine peut être microscopique ou macroscopique : dans le premier cas, la totalité du phénomène excède l’empan de la vision, dans le second elle est située en deçà de sa capacité de discrimination.

Dans tous les cas évoqués, la visibilisation sera rendue possible par la mise au point de procédures techniques visant à surmonter l’hypothèque spécifique. L’œil équipé, ou « habillé », vient ainsi relayer l’œil nu. Ces procédures permettent de

- Note de bas de page 3 :

-

Cf. Groupe µ (1992).

-

traverser l’obstacle (a1) : c’est l’objectif de la radiographie, de la RMN, etc. ;

-

modifier le point de vue (a2) : c’est l’objectif de l’endoscopie, du retraitement des images floues ;

-

rectifier la distance et changer l’échelle (b), toutes procédures produisant les transformations groupées dans la catégorie des homothéties3. Ces techniques opèrent par la réduction des dimensions (techniques de télescopie) ou, à l’inverse, par leur grossissement (techniques de microscopie).

Observer ce passage de l’œil nu à l’œil équipé nous permet de souligner une première fois l’incontournable rôle du corps dans l’observation scientifique. Un corrolaire de ceci est que les distinctions dont il vient d’être fait état ne sont pas de l’ordre du discret, mais de l’ordre du continu : qu’il soit ou non équipé, l’œil peut être l’instrument d’un regard informé, d’un regard entrainé, d’un regard naïf, d’un regard distrait…

Dans la plupart des cas, la visibilisation n’est pas seulement obtenue par un simple changement d’échelle ou de position d’observation : elle se fonde sur un changement qualitatif important tel que ce n’est pas le phénomène lui-même qui est observé, mais une de ses conséquences : on ne peut déceler l’existence d’une entité microphysique — par exemple une particule — qu’en observant un autre phénomène, macroscopique celui-ci, produit par l’action attribuée à cette entité. L’existence de nombre d’objets relevant de l’astrophysique ne peut ainsi être postulée que parce que l’on a observé certains phénomènes affectant des objets mieux connus, phénomènes attribuables aux premiers.

En termes sémiotiques, on parlera ici d’une indicialité, concept qui se révèle capital pour le traitement de l’invisible dans l’image scientifique. Cette remarque sur l’indicialité vaudra, on va le voir, pour les autres types de recentrage.

1.2. Deuxième recentrage : la traduction interlectale

Si l’on considère les phénomènes de rayonnement se produisant en deçà et au delà des fréquences de 390 à 820 nanomètres, nous rencontrons d’autres radiations qui nous sont connues : dans le registre des ondes plus courtes, ce sont les rayons ultraviolets, puis les rayons x, puis les gamma ; dans le registre des plus longues, ce sont les infrarouges, les micro-ondes, les ondes radio…

Un changement de fenêtre de longueur d'onde est possible, pour ramener les relations entre les longueurs d’onde dans ces zones à des différences opérant dans la zone 390-820.

Ici encore, une série de techniques ont été mises au point, qui permettent ce recentrage : lunettes infrarouges, écrans x, etc. Ces techniques s’apparentent à une traduction entre deux dialectes de la même langue, ou, en termes mathématiques, à une analogie par proportion : les relations de longueur d’ondes dans la zone visible — zone cible — sont considérées comme équivalentes aux relations entretenues dans la zone invisible, zone source.

- Note de bas de page 4 :

-

Groupe µ (1996).

Le premier groupe de phénomènes (aux rangées A et B du tableau qui suit, emprunté au Groupe µ4 concerne donc des rayonnements disposés en faisceaux spatiaux, tels qu'on puisse obtenir une correspondance point par point entre la donnée de départ (une étoile lointaine, un organe interne…) et l'image. Dans tous ces cas, on part bien d'une distribution spatiale pour aboutir à une autre distribution spatiale.

|

Phases of the Process Nature of the stimulus |

1. Phenomena examined |

2.1. Rceiving apparatus |

2.2. Transformation |

2.3. Mode of transmission |

3.1. Analyser apparatus |

3.2. Interpreter apparatus |

||

|

S p a t i a l |

A. Visible |

A1. Registered by the eye |

Radiation (visible)

Radiation (visible) |

Eye + microscope, telescope, etc.

Camera

Video-camera |

Iconic transformation

Iconic transformation |

Photons

Chemical support

Magnetic support |

Peripheral brain

Peripheral brain

Periferal brain |

Central brain

Central brain

Central brain |

|

A2. Not-Registered by the eye |

||||||||

|

B. Non-visible |

Radiation (invisi-ble*) |

Radiocamera (with appropropriate transducers) |

Change of frame + iconoc transformation |

Electronics (analogical or digital) |

Peripheral brain Computer Computer |

Central brain Central brain Computer |

||

|

C. Non spatial |

Non-spatial physical correlation* |

Computer, oscilluscope |

Calculation (geometrization) |

Graphics, diagrams |

Camputer Periferal brain |

Central brain Central brain |

||

|

* Examples: ultraviolet, infra-red, x-rays, gamma, ultrasound, nuclear magnetic resonance ** Examples : density, speed. |

||||||||

1.3. Troisième recentrage : le transcodage

Ce type de recentrage est plus audacieux encore. Il consiste dans le retraitement de phénomènes invisibles parce qu’ils sont de nature à être perçus par un autre sens que la vision.

- Note de bas de page 5 :

-

Klinkenberg (2009).

On n'a guère l'habitude de considérer le groupe de phénomènes de la rangée C lorsqu’il est question d’image, encore que Charles S. Peirce avait déjà étendu la notion d’iconisme à de tels faits. Mais, si l’on se place dans une perspective historique, on s’avise que l’application à eux du concept d’image devient de plus en plus fréquente et importante. Le mathématicien peut établir ses raisonnements dans une langue naturelle, éventuellement formalisée. Toutefois, pour mieux apprécier et faire apprécier la portée de ses abstractions, il a recours à une géométrisation, c'est-à-dire à une traduction en graphiques. C'est ainsi que des courbes peuvent être générées et que leurs propriétés apparaissent bien mieux — pour des raisons que j’ai exposées ailleurs5 et auxquelles je reviendrai en 4.3. — qu'en considérant simplement l'équation de départ. Mais n'importe quel graphique en deux dimensions (ou davantage, moyennant des projections appropriées) obéit au même désir de visualisation et permet de grouper des grandeurs non visuelles ni même liées à un quelconque rayonnement : par exemple pressions, vitesses, températures, etc. Ici, il n'y a plus de faisceaux spatiaux au départ, mutation importante du régime de l’image, à laquelle je reviendrai en 3.2. : seule l'image d'arrivée se présente comme une surface, ou un volume.

- Note de bas de page 6 :

-

Klinkenberg (2000).

Si l’on peut encore comparer ce recentrage à une traduction, il ne s’agit plus de la transformation des données d’un système en données relevant d’un autre système proche, mais d’une traduction entre systèmes cette fois résolument distincts ; une traduction non plus interlectale, mais interlinguistique. On peut donc parler de transcodage6. On peut par exemple figurer une progression de pression par une progression chromatique, laquelle peut aussi figurer la progression de l’intensité d’un son, ou de la force du vent, et plus généralement tout phénomène mesurable affectant tout objet ou processus. La caméra thermique relève de cette famille de techniques transcodantes.

L’image scientifique, toujours au sens le plus général du terme, est donc la représentation d’un phénomène, à travers une de ses manifestations, sélectionnée et traitée. Et on peut ainsi parler d’image électrique, thermique ou magnétique. Dans tous les cas, il s’agit bien de souligner une analogie entre un phénomène et un autre, ou, en d’autres termes, de proposer un modèle où un trait d’une certaine nature se voit systématiquement transformer en un autre trait d’une autre nature, au long des processus de collecte, d'analyse et d'interprétation des données. On voit évidemment que dans une définition aussi large, le mot « image », comme le mot iconisme qu’on peut lui associer, ont subi une considérable extension de sens.

2. Une nécessaire médiation

- Note de bas de page 7 :

-

Groupe µ (1992, 1996), Klinkenberg (2010b).

De recentrage en recentrage, la démarche scientifique apparait ainsi comme une tentative pour manipuler les limites du perceptible. Il s’agit de décamoufler le camouflé. Et non point de le décamoufler au profit d’un produit non spatial (on pourrait très bien imaginer un monde où le décamouflage se produirait au profit de produits thermiques ou olfactifs, voire tactiles : la notion de transformation est large au point d’autoriser ces équivalences7, mais au profit d’un produit visible. Il faudra interroger cette primauté du spatial dans le système-cible (cf. § 4).

2.1. La contrainte du corps

- Note de bas de page 8 :

-

Maurice Merleau-Ponty (1964) : « La peinture ne célèbre jamais d'autre énigme que celle de la visibilité ». Cg. Klinkenberg (2010).

Pour l’instant notons que les techniques mobilisées pour confirmer le tropisme optique dans la démarche dénotent un nécessaire anthropocentrisme : en effet, l’image scientifique — comme d’ailleurs aussi l’image artistique8 — apparait toujours comme contrainte par les virtualités de notre vision : sa sensibilité à une gamme réduite de stimuli, la diminution de la performance de l’œil dans la perception des contrastes avec la baisse de luminance, la limite physiologique correspondant au pouvoir discriminateur de l'œil... Bien que ce que j’ai appelé le recentrage montre le souci de ruser avec toutes ces contraintes, ces dernières constituent une donnée de base qui ne peuvent être totalement surmontées.

De sorte que tous ces recentrages sont impuissants à faire apparaitre la totalité de l’objet, au sens où une communion s’établirait avec lui— on va voir que cette idée est lourde de présupposés philosophiques et idéologiques —, mais que leur résultat est de produire un objet sémiotique : l’image.

- Note de bas de page 9 :

-

Cg. Klinkenberg (2010a).

L’important est ici de souligner que, pas plus dans l’image quelconque que dans l’image scientifique9 — mais la chose doit être vigoureusement soulignée dans le cas de cette dernière —, l’indicialité obtenue ne doit pas être conçue comme une réduplication passive du réel dans l’image : celle-ci n’est pas un instrument de reproduction, mais bien un instrument d’intellection. J’y reviendrai.

- Note de bas de page 10 :

-

Greimas (1970 : 52)

Nous nous approchons ainsi du programme de la sémiotique du monde naturel, esquissé par Algirdas J. Greimas au début des années 1970 et malheureusement très largement abandonné par la suite : approcher le monde « non plus comme un référent absolu, mais comme le lieu de la manifestation du sensible, susceptible de devenir la manifestation du sens humain, c’est-à-dire de la signification pour l’homme »10 ; il s’agit bien de constituer les objets du monde « en objets humains, c’est-à-dire signifiants pour l’homme ».

2.2. La transformation et l’instance transformatrice

Tel est le mode d’énonciation de toute image : elle est le lieu d’une nécessaire médiation entre les sujets et les observables. L’image est en effet un instrument qui dit autant du sujet producteur de l’image, et du sujet récepteur que du « réel ».

- Note de bas de page 11 :

-

Cf. Groupe µ (1992), Klinkenberg (2000, 2010b).

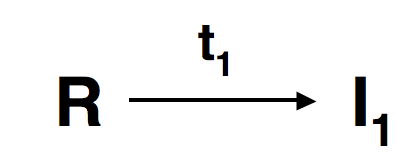

Pour le comprendre, je rappellerai le concept de transformation, élaboré pour rendre compte de la notion de signe iconique et qui était le thème de la précédente rencontre de l’ANR « Images et dispositifs de visualisation scientifique », qui s’est tenue à Liège en octobre 200811. La transformation est un modèle qui rend compte des relations de ressemblance et de différence existant entre le stimulus du signe (ou manifestation sensorielle de cet autre modèle qu’est le signifiant) et son référent : par exemple une échelle. Il est important de souligner que les opérations de transformation sont symétriques : elles peuvent être appréhendées dans les deux sens (stimulus ➔ référent et référent ➔ stimulus), selon que l'on envisage la réception du signe ou sa production. Symétrie capitale dans le cas de l’image scientifique, puisque, par définition, son référent n’est pas un objet donné et connu, mais un objet à élaborer (de sorte que la transformation est le mode de construction et de signification de l’objet : j’y reviens au § 3.1.).

- Note de bas de page 12 :

-

La proportion de I1 et de I2 est évidemment variable et le problème de la priorité de l'un sur l'autre dans l'interprétation reste ouvert.

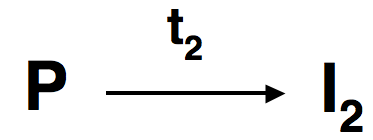

Il est possible de décomposer l’ensemble des points du signe iconique I en un ensemble E de points tels que chacun, outre ses coordonnées de position, donne la valeur de l'élément sur une des trois dimensions visuelles. Par exemple E (x1 ; y1), situé en x1 et y1 sur la surface de l'image, aurait une certaine valeur de luminance, une certaine valeur de saturation et une certaine valeur de nuance. Nous disposons ainsi d'une description analytique exhaustive de I sous forme de tableau. Si l'image est iconique, certains points du réseau I correspondront nécessairement à des points du réseau d’un référent R postulé, et d’autres non, la correspondance en question étant réglée par une ou plusieurs transformations. Mais il y a des points de I qui ne correspondent pas à R. Autrement dit, l'ensemble des éléments de I se partage en deux sous-ensembles I1 et I2 tels que I1+I2 = I et que l'on ait entre R et I1, la transformation t1. On a donc  . Mais d'où proviennent les autres éléments, ceux du sous-ensemble I2 ? Par définition, ils ne peuvent provenir du référent. Dès lors, ils ne peuvent provenir que d’une seule source : de l’instance productrice d'image, que nous désignerons par P. Étant produits par P, les éléments du sous-ensemble I2 seront une transformation t2 de P, et on aura

. Mais d'où proviennent les autres éléments, ceux du sous-ensemble I2 ? Par définition, ils ne peuvent provenir du référent. Dès lors, ils ne peuvent provenir que d’une seule source : de l’instance productrice d'image, que nous désignerons par P. Étant produits par P, les éléments du sous-ensemble I2 seront une transformation t2 de P, et on aura  . Pour le dire de manière simple, par la transformation, l'image visuelle retient quelque chose tant des sujets que des objets. Comme il n'y a aucune raison d'estimer que seule la partie I1 est pertinente, le destinataire considère et interprète aussi bien I2 que I1. Il peut ainsi remonter de I1 à R en inversant t1, et de I2 à P en inversant t212. Comme on le voit, loin d’exhiber un réel ultime, l’image porte nécessairement la trace de son énonciation. En cela, l’image scientifique ne se distingue pas des autres images : elle occupe une position médiatrice entre R et P (cf. Groupe µ, 1995, 1996). Sa spécificité est d’ordre pragmatique : elle est dans le souci d’expliciter et de stabiliser au mieux la part de t2, qui ne peut toutefois être niée.

. Pour le dire de manière simple, par la transformation, l'image visuelle retient quelque chose tant des sujets que des objets. Comme il n'y a aucune raison d'estimer que seule la partie I1 est pertinente, le destinataire considère et interprète aussi bien I2 que I1. Il peut ainsi remonter de I1 à R en inversant t1, et de I2 à P en inversant t212. Comme on le voit, loin d’exhiber un réel ultime, l’image porte nécessairement la trace de son énonciation. En cela, l’image scientifique ne se distingue pas des autres images : elle occupe une position médiatrice entre R et P (cf. Groupe µ, 1995, 1996). Sa spécificité est d’ordre pragmatique : elle est dans le souci d’expliciter et de stabiliser au mieux la part de t2, qui ne peut toutefois être niée.

- Note de bas de page 13 :

-

Dondero (2010).

La leçon pour la sémiotique est que le sémioticien doit obligatoirement tenir compte dans ses analyses de cette transformation t2. Elle définit en effet le point de vue scientifique pris sur l’objet ; elle fait apparaitre le rôle de l’hypothèse de la recherche, de l’état de la science au moment du travail, des goûts et des traditions du chercheur ou de son équipe, du style qu’il adopte d’habitude dans la résolution des problèmes qui se posent à lui, des relations que ses énoncés entretiennent avec d’autres énoncés, autant que celui des déterminations sociologiques ou économiques qui pèsent sur lui et sur son laboratoire. Catherine Allamel et Maria-Giulia Dondero ont beaucoup insisté sur la nécessité de tenir compte des pratiques de production de l’image, ce que notre schéma met en évidence. « Il n’y a aucun accès possible à la signification de l’image [scientifique] sans la prise en compte de la manière à travers laquelle elle s’est constituée en inscription »13.

3. Visible et invisible

3.1. Acte 1 : Ou le caché doit se révéler

J’ai commencé en rappelant la définition de l’Invisibilité comme « état de ce qui ne peut être vu ». Je l’ai souligné d’emblée : une telle définition pose diverses questions, que ma typologie des invisibilités n’a certes pas épuisées.

L’une d’entre elles est de nature philosophique.

La conception que nous faisons de l’invisibilité est en effet assurément modelée par le discours théologique et néoplatonicien : pour celui-ci, le réel existe, mais est inaccessible à notre expérience, en raison de notre imperfection. Dès lors, tout le travail — travail de la foi ou travail de la science — consistera à révéler cette réalité, dans un mouvement de d’ascèse et de purification. Et cette révélation n’adviendra jamais aussi bien que dans un mouvement qui la rendra visible. Le catholicisme traduit ainsi le concept d'invisibilité par la notion d’hypostase, ou l'espérance des biens du monde, toujours déjà là, mais restant à venir : « La foi est l'hypostasis des biens que l'on espère, la preuve des réalités qu'on ne voit pas ». La tradition néoplatonicienne et la gnose reposent ainsi sur le postulat de l’existence d’un univers caché, qui est destiné à se révéler.

C’est assurément cette conception de l’invisibilité qui, vulgarisée, circule dans le grand public. Elle le fait notamment grâce à de nombreux films et romans de fantasy ou de science fiction, énoncés où les objets sont rendus invisibles par les pouvoirs de la magie ou de la technologie. Mais le public n’aimant pas être troublé par le contact avec l’inconnu, ces objets invisibles sont à ses yeux indubitablement dotés d’existence. Ce public a en effet eu la preuve de leur existence par la vision, à un moment antérieur à celui où l’invisibilité s’empare de l’objet : avant d’être sacré par son adjectif éponyme, l’homme invisible de Wells était bien visible. Ce qui est bien commode : aucun mystère ne vient vraiment troubler le savoir sur ce qui pour l’instant n’est plus visible mais l’a été, incontestablement.

C’est un mouvement inverse que propose la science. Ici, la preuve par la vision ne précède pas l’invisibilité ; c’est cette invisibilité qui est première. Ce qui est assurément moins confortable : ce réel-là n’est pas un connu mais un à connaitre. Toutefois, cette invisibilité est la propriété de choses dont la réalité n’est pas mise en question, du moins jusqu’au début du XXe siècle ; et c’est en quoi la science d’alors rejoint le discours néoplatonicien. C’est cette réalité qui est appelée à connaitre son épiphanie : elle montera assurément — fatalement même — à l’entendement, pour autant que les conditions techniques ou morales de cette épiphanie soient réunies. Elle deviendra nécessairement plus réelle encore. Et réelle, elle le sera en devenant visible.

- Note de bas de page 14 :

-

de Broglie (1967, p. 706).

C’est bien cette conception de la dialectique entre le visible et l’invisible qui règne sur la science entre le XVIe et le XXe siècle et qui y détermine le statut de l’image. « Les théories de la physique classique », nous dit le Prix Nobel Louis de Broglie, « se sont développées en admettant la réalité du monde physique et en cherchant à en obtenir des représentations concrètes »14. L’observation elle-même portait bien atteinte à l’état de chose existant à l’instant précédant la mesure ou l’observation, « mais il n’y avait là rien qui parût porter atteinte à l’idée qu’il existe à chaque instant une réalité physique bien déterminée, extérieure aux hommes qui l’observent ». Et même si dans la science d’alors, les représentations théoriques obtenues par la recherche tendaient à s’exprimer essentiellement dans le formalisme mathématique, il n’en restait pas moins que ce formalisme ne remettait pas en question « le caractère concret du monde physique dont les formules mathématiques n’avaient pour but que de donner une description plus ou moins exacte ».

- Note de bas de page 15 :

-

de Broglie (1967, p. 706).

Formalisme mathématique et image : telles sont les deux modes d’énonciation du discours scientifique moderne. L’image joue donc un rôle dans un drame à trois acteurs, le troisième acteur étant un collectif : les observables expérimentaux. Et ce rôle est capital puisque c’est d’une médiation qu’il s’agit : ce sont les images qui occupent la place intermédiaire entre les observables et le formalisme. Pourquoi ce règne ? Sans doute s’explique-t-il par une autre constante de la pensée scientifique : chercher « à donner une description de la réalité physique en à en suivre l’évolution en se servant toujours du cadre de l’espace et du temps, donnée première de notre vie quotidienne, et en établissant un lien causal entre les phénomènes successifs »15.

3.2. Acte 2 : Crise de l’espace, crise de la référence ; un nouveau statut pour l’image, ou le quatrième recentrage

Il revient au XXe siècle d’avoir établi un nouveau rapport entre le visible et l’invisible, et d’avoir mis le cadre spatio-temporel en cause, brisant radicalement avec le paradigme néoplatonicien, et mettant par conséquent en question le statut de l’image.

La source de cette crise est à chercher du côté des nouvelles théories des particules. Celles-ci rompent avec la conception atomiste, où ces particules sont conçues comme des objets identifiables, dotés d’une position déterminée dans le temps et dans l’espace. Dorénavant, elles n’ont plus que le statut d’entités mathématiques. Le comportement de ces entités peut certes être modélisé, mais l’éventuel substrat physique de ce comportement est indécidable. Cette crise est, du point de vue qui nous intéresse, une crise du temps et de l’espace : ce qui est abandonné est en effet le principe de la connexion étroite entre ce qui se passe aux divers points de l’espace au cours du temps.

Une telle crise ne pouvait qu’avoir un effet dévastateur sur l’usage des images. Le caractère premier de celles-ci n’est elle pas, en effet, la spatialité ?

Les images souffraient certes déjà d’un discrédit dont l’origine remontait à un passé lointain. Au XXe siècle, ce discrédit a une double source.

- Note de bas de page 16 :

-

Cf. Groupe µ (1998).

- Note de bas de page 17 :

-

Wigner, 1960, lequel, en une démarche assez platonicienne, va jusqu’à poser que les lois naturelles « sont écrites » dans le langage mathématique. Sur le rôle de cette désensorialsation dans les processus cognitifs, voir Groupe µ, 1998.

- Note de bas de page 18 :

-

Juvet (1933), apud Piaget (1967: 772).

La première, sur laquelle il n’est pas nécessaire de s’étendre longuement, est le caractère sensoriel des images. Or, toute l’évolution des sciences à l’ère moderne montre une tendance à éliminer progressivement les résidus sensoriels16. Si les sciences de la nature comportent manifestement de nombreuses traces de ce type, les mathématiques, par contre, en sont davantage exemptes (même si elles présentent des marques, réelles ou projetées, de sensorialité, notamment dans les métaphores qu’elles mobilisent), tout en se montrant efficaces pour traiter théoriquement de problèmes posés par les sciences de la nature. Et cette efficacité est telle que l’on a même pu parler de la « réussite exagérée » des mathématiques17. Devant les traces de sensorialité que présente l’image, on comprend qu’un physicien comme Gustave Juvet ait pu déclarer, dans sa Structure des nouvelles théories physiques18, qu’on ne fait pas de la physique avec des images, pas plus qu’on ne gagne une partie d’échec avec ses sentiments.

La seconde source de ce discrédit doit nous retenir davantage : c’est le caractère particularisant des images. Ce que Maria-Giulia Dondero a appelé leur localisme. Ce caractère particulier s’oppose fatalement à la généralité à laquelle tend le formalisme mathématique. Ce qui devait forcément amener à renoncer aux images, puisqu’elles sont liées au cadre de l’espace et du temps, source de leur localisme.

C’est cette seconde critique qui va se radicaliser au XXe siècle, à la faveur des progrès de la physique : la particule, en effet, n’est désormais plus qu’un système d’équations. Dorénavant, la scène semble donc ne plus devoir comporter que deux acteurs : les observables et le formalisme mathématique qui en rend compte.

Les images concrètes n’ont toutefois jamais quitté cette scène.

- Note de bas de page 19 :

-

Elles fournissent ainsi les coordonnées des particules, dans le même moment où l’on insiste sur le fait que lesdites particules n’ont pas constamment une localisation dans l’espace.

- Note de bas de page 20 :

-

Cf. Klinkenberg (2009).

- Note de bas de page 21 :

-

Piaget (1967, p. 775).

D’une part, elles ont la vie dure, dans leur forme traditionnelle, parfois au prix de la contradiction19. On peut expliquer cette permanence par trois raisons. Tout d’abord, la spatialité et la temporalité sont des caractéristiques du cadre dans lequel se meut le sujet scientifique, et elles restent du coup de puissants stimulants de l’intuition scientifique. D’autre part, la spatialité permet, dans la phase d’explicitation du modèle, de concilier l’exigence de généralité et celle d’expliquer l’actualisation particulière du général20. Enfin, spatialité et la temporalité ont elle mêmes connu une révolution à l’époque contemporaine, ce qui leur a conservé une aptitude à accueillir les phénomènes nouveaux : dans les domaines de la géométrie, de la logique et de la mathématique, « le clavier des configurations spatiales possibles et des organisations temporelles possibles (…) s’est étonnamment enrichi »21.

- Note de bas de page 22 :

-

Le rapport entre le texte et l’image, qui est en général conçu comme un rapport entre le général et le particulier, entre la loi et l’observation, s’inverse dès lors spectaculairement. Pour illustrer ce renversement, je citerai ici Maria-Giulia Dondero (2009) dans son travail sur les images de trous noirs : « [en astrophysique], il ne s’agit pas d’un texte écrit qui décrit et argumente quelque chose et qui ensuite en montre l’image comme résultat de la description, mais tout au contraire l’argumentation du texte écrit progresse par le biais d’actes de visualisation. C’est la visualisation qui guide l’expérience, même si ce sont les équations qui donnent les coordonnées précises de cette visualisation. Ce qui est étonnant est que le texte écrit renvoie aux équations qui sont censées spécifier l’image, contre l’idée reçue que l’image est toujours, à cause de son ancrage dans un espace particulier, quelque chose de plus local dont il faut s’éloigner si on veut procéder aux calculs et aux équations, bref à la généralisation. Ici ce sont les équations qui donnent ancrage à la spatialité qui, sans ces dernières, resterait trop générale, généraliste ».

- Note de bas de page 23 :

-

Nous sommes ainsi confrontés à une forme plus subtile mais plus radicale encore de camouflage : choisir de montrer a, c’est aussi choisir de ne pas montrer non-a, un non-a dont on ne sait d’ailleurs rien ; sélectionner l’objet de la visibilisation, c’est aussi refuser (ou omettre, ou être impuissant à) visibiliser ce qui aurait pu l’être.

Mais la deuxième série de raison de la rémanence des images est qu’elles se sont dorénavant vu confier un autre rôle que la référence iconique, conçue de manière naïve. L’image n’est plus seulement faite de propriétés attribuée à l’objet du monde, dont l’existence est posée, mais est désormais le produit d’une démarche visant à donner un statut à la relation entre les observables et les modèles. Elle est non point empreinte de l’objet supposé et invisible, mais modèle généralisant de l’information fournie par les observables. Dans ce processus de visibilisation, aucun premier invisible n’est posé, contrairement à ce que veulent le modèle platonicien et la doxa courante22. En renonçant à ce modèle, on abandonne la prétention de rendre visible l’Invisible : on n’a plus que celle de visibiliser — et, ce faisant, d’en inférer la pertinence — un invisible que l’on construit par le fait même23.

- Note de bas de page 24 :

-

Piaget (1967, p. 777).

On voit bien à nouveau ici le rôle du sujet, sur lequel j’ai déjà insisté au paragraphe 2.1. Non pas le sujet individuel dont les interventions rendrait l’observation inopérante, mais le « sujet épistémique ou décentré, dont les structures opératoires encadrent ces mêmes apports et constituent la condition tant de l’élaboration des modèles et de leur déduction logico-mathématique (…) que de la lecture même des faits physiques élémentaires »24.

3.3. La symétrie des transformations

Ceci me ramène à la médiation du sujet et au statut du référent, deux thèmes dont j’ai déjà traité au paragraphe 2.

- Note de bas de page 25 :

-

Règle à laquelle le discours sémiotique n’est pas astreint, soit dit en passant. Sicard (1998, p. 10) nous rappelle que, pour le sémioticien, « avant d’être une excroissance osseuse, une radiographie est reconnue comme élément du fait radiographique » ; la sémiotique doit dès lors « rendre aux médiations la place qui leur revient ».

Dans toutes ses hypostases, le discours scientifique insiste sur la transitivité de l’image, transitivité qui est une de ses règles pragmatiques25. Qu’on la voie à la lumière des conceptions néoplatoniciennes ou à celle de la physique quantique ou de l’astrophysique contemporaine, le rôle herméneutique attribué l’image repose sur la propriété qu’ont les transformations iconiques d’être symétriques, propriété sur laquelle j’ai déjà insisté.

Nous avons vu que dans le cas de la production du signe iconique, les règles de transformation sont appliquées pour élaborer un stimulus sur la base de la perception d'un référent (réputé concret et donné, ou préalablement élaboré). Mais dans celui de la réception, elles sont appliquées pour postuler, à partir des caractéristiques perçues du stimulus, l’existence de propriétés attribuables au référent. Il faut souligner ici que cette reconstruction ne se fait pas au hasard : elle est guidée par les données fournies par le type (cf. Klinkenberg, 2000). Par exemple, je reconstruis la tridimensionnalité à partir du dessin d'un être inconnu, du moment que celui-ci soit assignable à la catégorie animal, car je sais que les animaux se meuvent dans les trois dimensions : cette tridimensionnalité est une caractéristique listée dans le paradigme du type. Si la relation de transformation est en principe toujours symétrique, elle reste néanmoins problématique, à des degrés divers. On s’avise que, opérant à l’aide du type, la transformation stimulus ➔ référent est d’autant plus hasardeuse que le type est moins stable dans notre encyclopédie : si je ne cours guère de risque à postuler la tridimensionnalité d’un animal à partir d’un stimulus en deux dimensions, j’en cours davantage à postuler la couleur exacte d’un objet inconnu qui m’est présenté sous les espèces d’une photo en noir et blanc ; tout au plus puis-je postuler que cet objet a bien des propriétés chromatiques, et encore. Dans la mesure où l’image scientifique a une fonction herméneutique — rappelons qu’il s’agit bien de mettre en évidence non une chose connue, mais une chose inconnue —, nous ne disposons pas de types stables pour opérer sans risque la transformation associant le plan de l’expression (stimulus et signifiant) au plan du contenu (type et référent). Une partie de I est certes constituée par l’invariant, mais le reste est reconstruit de manière hypothétique. Donc, moins le type est stabilisé — et c’est bien sûr le cas dans le cadre de la recherche scientifique — et plus l’intervention du sujet épistémique sera importante.

- Note de bas de page 26 :

-

Tout ceci n’est évidemment pas sans impact sur le concept d’indicialité, indicialité qui est comme on l’a vu une des fonctions communément attribuée à l’image scientifique. Selon Dondero (2010), « si l’on continuait à concevoir l’indicialité comme une forme de garantie de commensurabilité entre un référent « déjà là » et une image qui le représente, on ne saurait pas s’expliquer le fonctionnement et le but des multiples transformations en chaîne produites dans les laboratoires… à quoi serviraient-elles ces transformations multiples ? Si l’objet était déjà là, la raison de toutes ces transformations ne s’expliquerait pas… Au contraire, c’est la chaîne des transformations qui permet de construire un référent, de caractériser les phénomènes, de les stabiliser, et notamment, de les rendre de plus en plus manipulables. »

Si l’image scientifique doit bien continuer à être décrite comme une icône, celle-ci ne doit donc plus être entendue au sens d’être l’icône d’un objet identifié préalablement. Ce n’est plus la vérification d’une ressemblance ou la mesure d’une distance prise par le stimulus avec un référent : c’est est un mécanisme de formulation d’hypothèse et de formalisation. La notion d’icône ne doit pas être rapportée à un objet stable, mais à un processus : l’iconisation. Et l’image n’est plus la traduction d’un référent : elle est construction de ce dernier26.

4. Pourquoi le visible ?

Comme je l’ai déjà souligné (§ 2.2.), la notion de transformation est en soi indifférente au canal choisi. On pourrait, par exemple, transformer un phénomène thermique en une image sonore, ou un phénomène spatial en une image faisant intervenir des différences de rugosité. Mais le fait est que ces possibilités ne sont guère exploitées, et que les transformations à aboutissement visuel semblent jouir, sinon d’une exclusivité, au moins d’une préférence constante dans toutes nos représentations (et pas seulement des représentations scientifiques) : faire voir à tout prix semble être une de leurs constantes.

Quatre espèces de raisons semblent expliquer le tropisme du discours scientifique pour les produits visuels. Les deux dernières sont spécifiques à l’image scientifique ; j’en ai déjà traité antérieurement, ce qui me dispensera d’y revenir longuement. Les deux premières concernent tous les produits visuels, et il me faudra donc les commenter plus longuement.

4.1. Puissance et distance

- Note de bas de page 27 :

-

Cf. Groupe µ (1992).

- Note de bas de page 28 :

-

Mais en contrepartie, il hérite d’une partie de ses faiblesses : les vraies illusions d’optique, ou encore les limites à la discrimination qui sont à la base du camouflage.

Une première caractéristique, que la vision partage avec l’ouie, est le fait que ces deux sensorialités autorisent le traitement des données à distance. Mais, dans ce traitement, la vision jouit d’une supériorité : celle de la puissance. Cette puissance lui permet de traiter et d’acheminer un grand nombre d’informations dans un laps de temps donné : 107 bits par seconde, soit sept fois plus que l’oreille27. Le canal visuel autorise donc une puissante discrimination des données28. Cette puissance de traitement fait qu’il pourra exploiter la simultanéité dans l’exploration de l’espace, paramètres important des phénomènes scientifiques, dont il a déjà été question en 3.2.

- Note de bas de page 29 :

-

Tout ceci vaut pour tous les produits de la vision : formes et textures comme couleurs. Mais ce qui suit est particulier à la couleur : la vision chromatique humaine a une potentialité discriminative très élevée. On a déjà dit que vision exploitait un empan de longueur d’ondes extrêmement restreint dans le champ des ondes connues : de 390 à 820 nanomètres. Or ce spectre étroit, l’œil le discrétise très efficacement, surtout aux valeurs moyennes de luminance. Le nombre de qualités discriminables est de 150 en moyenne, dans l’absolu. Dans l’absolu, car ce chiffre, qui varie selon les individus et parfois même entre les deux yeux d'une même personne (on peut s'en rendre compte par clignement), s’élève encore lorsqu’il s’agit de discriminer des couleurs juxtaposées. Ne dit-on pas que les tapissiers distinguent cinq cents nuances de rouge, et que les trieurs de laine des Gobelins peuvent distinguer jusqu’à 14 000 tonalités ? Cette capacité de discrimination a elle aussi une forte valeur opérationnelle : elle permet de catégoriser efficacement les expériences du monde en se référant à des classes tantôt très générales (nous reconnaissons tous les membres de la classe citron grâce à leur couleur jaune, l’amanite tue-mouche à ses taches blanches sur fond rouge), tantôt à des classes très étroites (nous distinguons ainsi, à grand peine à vrai dire, l’amanite rougissante de l’amanite panthère). Cette valeur opérationnelle, nous l’appliquons non seulement aux objets du monde, mais aussi aux signes qui en sont les substituts. Par exemple, la couleur /rouge/ joue un rôle iconique, si elle m'aide à reconnaitre une pomme sur une photo ou un tableau.

Distance et puissance confèrent aux produits de ce canal une forte valeur opérationnelle. Si toute sensorialité autorise la catégorisation, le jugement et la décision, et permet ainsi au sujet de simuler l’action, d’anticiper ses conséquences, d’adopter les attitudes et les comportements adéquats, distance et puissance donnent aux catégories établies grâce à la vision une forte valeur de survie dans l’environnement. Une puissance cognitive également, reconnue depuis la plus haute Antiquité. Pour Aristote, de tous nos sensorialité, la vision n’était-elle pas « celle qui nous fait acquérir le plus de connaissances » ?29. Une telle puissance cognitive ne pouvait donc pas être négligée par une pratique qui, même si elle en d’autres, implicites, s’assigne explicitement la connaissance comme fonction : la science.

4.2. Discrimination

La technique décisive, dans cette quête cognitive, est la discrétisation : il s’agit d’introduire la discontinuité dans ce que l’expérience brute donne comme continu.

- Note de bas de page 30 :

-

Cf. Groupe µ (1998).

Dans son geste élémentaire, l’opération de sémiotisation peut se définir par la formule : sémiotiser c'est (d'abord) segmenter, ou discriminer. L'aspect le plus important de cette manœuvre de différenciation est le seuillage30. On veut dire par là que les stimuli connaissant une variation d'intensité inférieure à un certain niveau, dit seuil de discrimination ou d’égalisation, sont considérés comme manifestant la même qualité : en fixant ce seuil à une valeur déterminée, on égalise tout ce qui ne comporte pas de différence supérieure à lui ; l'appareil perceptif, qui mérite bien son nom de machine sémiotique, « décide » donc d'ignorer tout stimulus inférieur au seuil choisi. En revanche, les variations qui dépassent ce seuil d'intensité sont prises en considération. Mieux : l’appareil « décide » d'exagérer tout stimulus dépassant ce seuil, pour lui donner valeur critériale. Les données enregistrées de la sorte constitueront donc une nouvelle qualité.

Ainsi, les entités (visuelles, tactiles, auditives, olfactives, gustatives) résultent toujours d'une décision de seuillage : la fixation de la valeur fait saillir de ce fait des entités correspondant à ce seuil.

Il est aussi important de souligner, dans la foulée, que ces seuils n'existent pas dans la nature. Une fois de plus, ce ne sont pas des procédures révélant un invisible qui préexisterait : ils sont produits grâce à une interaction entre les stimuli et les organes perceptifs ; ils sont un ordre et une différencialité que notre corps introduit dans le continu du monde. Ces seuils sont du coup variables : un seuil plus bas ou plus fin, ou des seuils multiples, feraient saillir des entités plus nombreuses et plus petites (les nouvelles entités sont alors des fragments, des découpages, des anciennes, mais le contenu total restera inchangé). Á l’inverse, en relevant le seuil, on obtient des types plus généraux, et en nombre inférieur. En résumé, le processus de classement des entités correspond à un double mécanisme de stabilisation du percept (par élimination de caractères non relevants) et d’abstraction. On obtiendra de la sorte, dans l'univers des représentations, des types stabilisés à divers niveaux d'abstraction.

Ces mécanismes sont le fait de toutes les sensorialités. Mais la puissance de traitement du canal visuel rend les seuillages opérés par lui plus fins. Elle offre aussi plus d’espace à la labilité que je viens d’évoquer.

Or la connaissance scientifique ne peut aller sans ces procédures de stabilisation des formes, de méréologisation et de discrétisation des données et de sélection de critères, toutes opérations que permet le seuillage. L’image scientifique sélectionne sévèrement les aspects de l’objet observé (par exemple sa forme et sa densité, ou sa forme et sa chaleur), et tend à la bi-univocité en codifiant étroitement le rapport entre les variations d’un paramètre de l’image (une couleur par exemple) et celles d’un aspect de son référent (sa température, par exemple).

4.3. Spatialisation et vectorialisation

Comme je l’ai démontré ailleurs, on ne saurait expliquer le rôle confié à l’image par le discours scientifique en se contentant de verbes passe-partout comme « illustrer », « rendre frappant », « expliquer ». Toutes ces expressions renvoient à des raisonnements tautologiques, et, quand ils ne les sont pas, à des réponses simplistes et incomplètes.

- Note de bas de page 31 :

-

Klinkenberg (2009).

L’examen que j’ai mené des schémas31 permet de leur substituer une réponse double, qui vaut pour l’image scientifique en général. Dans le régime qui est le sien à l’époque contemporaine (cf. 3.2.), celle-ci apporte au discours scientifique un formalisme qui, en associant le spatial et le linéaire, permet de réconcilier le paradigme et le syntagme, comme de réconcilier le général et le particulier. En ce qu’elle produit une analyse, l’image donne en effet bien à lire le paradigme des phénomènes étudiés, et — le paradigme se caractérisant par son intemporalité — renvoie à leur généralité. Mais elle a aussi la particularité de constituer également un syntagme, car, saisissant un phénomène en procès au moment où elle le produit, elle rend compte de l’actualisation de ce phénomène. Comme la formule mathématique, l’image a une fonction d’analyse, mais si la formule exprime toutes les potentialités de cette analyse, elle le fait de manière intemporelle, et donc statique. Par son caractère d’actualisation, l’image introduit dans l’analyse une dimension dynamique. Sa puissance explicative provient donc, en définitive, du fait qu’elle associe, dans une perception globale, voire immédiate, qu’elle doit à sa visibilité (cf. 4.1.), le général du paradigme avec l’appréhension des particuliers exprimée par sa structure syntagmatique, appréhension facilité par son pouvoir discriminateur (cf. 4.2.). Cette conjonction du dynamique et du tabulaire assure une connaissance sensible des phénomènes décrits, connaissance impossible à dériver directement depuis les données ou depuis les équations qui en sont la source.

Surtout, elle permet de surmonter le localisme pointé par M.G Dondero, qui était lié à une conception de l’espace comme non vectorialisé, et de la temporalité comme sans simultanéité. On comprend donc pourquoi, en dépit de la crise de l’image étudiée en 3.2., le discours scientifique a continué à se servir des images : moyennant des procédures de lecture adéquates, elles peuvent parfaitement servir la nouvelle conception de la relation entre temps et espace.

4.4. Stimulant heuristique

La dernière explication du tropisme du discours scientifique pour l’image, étroitement articulée aux trois premières, est sa fonction heuristique. Celle-ci est immédiatement dérivée du rôle qu’elle joue dans la connaissance sensible, et sur laquelle j’ai déjà insisté au paragraphe 3.2. Pour les raisons qui viennent d’être expliquées (4.3.), elle joue un le double rôle heuristique qui a été décrit et que l’on peut mieux comprendre à présent : d’une part, loin d’être la vérification de l’existence d’un référent déjà connu, elle constitue une procédure de formulation d’hypothèses et de construction du référent ; et l’autre, elle produit un modèle généralisant de l’information qu’elle sélectionne et qu’elle soumet à la transformation. Elle est donc un puissant instrument de formalisation.