L’indicialité de l’image scientifique : de la constitution de l’objet à sa manipulation

Introduction

- Note de bas de page 1 :

-

Voir à ce propos Bordron (2004, p. 129) : « Il est pourtant évident qu'aucun icône, quelle que soit la modalité sensorielle mise en cause, ne peut se comprendre autrement que comme un moment à l'intérieur d'un procès temporel. Ceci est vrai d'une note de musique, d'un parfum, d'un goût, d'une brûlure, toutes sensations dont l'iconicité repose d'abord sur la stabilisation temporelle d'un phénomène dynamique ». Et encore : « Nous avons parfois la sensation du moment présent. Mais qu'est-ce que ce moment présent si ce n'est un icône du temps, un moment stabilisé à l'intérieur d'un flux pour lequel il n'existe, physiquement, que des simultanéités ? La notion de présent est en ce sens le modèle de toute iconicité, qu'elle se réalise dans le temps lui-même. […] Dans tous ces cas, nous avons affaire d'abord à une stabilisation temporelle ».

- Note de bas de page 2 :

-

On peut enregistrer un shifting de la manière d’entendre l’indicialité dans le temps. À partir des vulgarisations des travaux de Peirce, l’indice concerne l’empreinte et la correspondance point par point d’un objet avec sa représentation. Mais Peirce n’a jamais réifié des objets ni des construits visuels en tant qu’indices, plutôt il a entendu l’indicialité comme un moment dans le parcours de constitution du signe.

Même si traditionnellement et à des fins de simplification on classe le dessin parmi les icônes, les photographies parmi les indices, et les images retraitées et reconstruites de l’imagerie contemporaine parmi les codifications symboliques, on sait bien que chaque image et série d’images de statut scientifique — ou non — est pénétrée par trois dimensions. Ainsi la dimension iconique assurerait-elle à l’image une stabilisation des formes et une méréologisation des données de la perception1, la dimension indicielle témoignerait des traces effectives de son instanciation2, et la dimension symbolique permettrait à chaque image d’être considérée comme le produit négocié d’une pratique communicationnelle institutionnalisée. Selon cette conception, toute image attestée peut être conçue comme une stratification de ces trois dimensions.

- Note de bas de page 3 :

-

La sémiotique du discours, mais aussi la sémiotique du Groupe Mu, a analysé les images sans prendre en compte leur statut, en pensant que c’est le regard de l’analyste qui construit les textes et leur taille. Contre le déracinement analytique du texte de son origine et de son statut culturels qui le transformerait en un artifice de la théorie, voire en une confirmation de la théorie, il faut analyser un texte à partir de son attestation historique et de son appartenance à une tradition, qui dépendent toujours des corpora productifs spécifiques. Voir à ce propos Basso Fossali (2009).

- Note de bas de page 4 :

-

Voir à ce propos Bordron qui distingue entre une manière ontologisante de définir l’iconicité et une manière gestaltiste (2000) : « Il existe deux lectures possibles de l'expression "être icône de" selon que l’on comprend le génitif qu'elle gouverne au sens subjectif ou au sens objectif. Au sens subjectif l'expression signifie que quelque chose devient icône, s'iconise. Nous parlerons dans ce cas de constitution de l'iconicité. Le génitif objectif signifie au contraire qu'un icône déjà constitué se rapporte à quelque autre chose. Il fonctionne alors comme signe. Les sémiotiques qui considèrent le signe comme un fait primitif ignorent l'iconicité comme moment de constitution. Les sémiotiques structuralistes et, plus généralement, gestaltistes, insistent au contraire sur le premier moment ».

- Note de bas de page 5 :

-

Sur la méréologie voir Bordron (1991) et (1994).

- Note de bas de page 6 :

-

Voir à ce propos l’excellent ouvrage de Beyaert-Geslin (2009).

Il faut bien tenir compte de ces trois dimensions qui stratifient chaque énoncé ; on ne peut ni les déterminer a priori, ni à partir de leur genèse, parce que ces dimensions sont assujetties aux statuts assumés par l’énoncé en question— visuel ou non. Je veux dire par là qu’on ne peut pas discuter de dimensions iconique, indicielle ou symbolique des images sans se demander auparavant à quel régime de la signification ces images appartiennent, à savoir quel est le statut qu’elles assument3 et qui les rend signifiantes à l’intérieur de pratiques plus ou moins institutionnalisées. Prenons l’exemple de l’iconicité, qu’on peut définir comme la manière dont les formes se stabilisent et deviennent reconnaissables4. L’iconicité d’une image artistique ne se caractérise pas de la même manière que l’iconicité d’une image de statut scientifique par exemple. Si l’instabilité méréologique5 dans une image artistique n’est pas du tout dérangeante, elle peut l’être, et de manière très forte, en une image de statut scientifique, où il faudra faire tout son possible pour stabiliser les formes et les identifier. La même chose vaut pour l’indicialité : l’indicialité des images de statut artistique ne concerne que la question de l’habileté, de l’expertise du producteur, du jugement de la valeur esthétique… cela revient à dire que l’indicialité de statut artistique concerne notamment la virtuosité du faire : elle est mesure des compétences de l’artiste. Dans les images de statut documentaire (photo de famille, photo souvenir, etc.) ou de statut éthico-politique (reportage de guerre, événements de l’actualité politique, etc.), c’est très différent : l’indicialité concerne un effet de vérité qui est censé être garant d’un fidèle témoignage d’une série d’événements en tant qu’événements vécus justement par le producteur de ces images-mêmes. Ici la question de l’indicialité touche au cœur des questions éthiques car l’indicialité dans le domaine du reportage par exemple concerne la distance de la prise de vue de l’énonciateur, la responsabilité vis-à-vis de sa vie et de la vie des autres6 ; enfin, son engagement en tant que personne. Dans le statut scientifique c’est encore différent : d’une certaine manière, pour être indicielle, il faut que l’image apporte un résultat qu’on peut évaluer par rapport à des attentes, à des hypothèses, au réglage des instruments, bref, aux motivations qui ont rendu nécessaire sa fabrication et aux instanciations qui l’ont permise. Pour cette raison, l’indicialité ne peut/doit pas concerner seulement le point de vue de la production médiatique. Par contre, dans les études sémiotiques, notamment de tradition peircienne, qui ne se sont jamais posées la question des statuts de l’indicialité, on a toujours été habitués à concevoir l’indicialité comme une relation entre un objet émanateur — d’énergie lumineuse, de données, etc. — et un signe qui accueille ces émanations. Par contre, le point de vue de la production devrait s’appareiller avec le point de vue de la réception, le point de vue de l’amont avec celui de l’aval.

- Note de bas de page 7 :

-

Lynch & Woolgar (1990, p. 7).

Notamment dans le cas de l’imagerie contemporaine, l’indicialité doit être conçue en tant que résultat final d’un processus de transformation d’inscriptions. On ne pourra donc parler d’une image scientifique indicielle que lorsqu’on aura couplé la perspective productive avec la perspective réceptive/pragmatique. On pourra donner le nom d’indicielle à une série d’images non seulement quand il s’agira d’images produites par le biais d’une énonciation-émanation (motivation et contigüité en amont du processus), mais surtout quand ces images rejoindront les objectifs recherchés par une expérience conçue dans le cadre précis d’une discipline et d’une pratique de recherches (démarches interprétatives en aval du processus). D’une certaine manière, on pourra revisiter le concept d’indicialité en se posant cette question : est-ce que la chaîne des transformations des inscriptions qui sont censées « transporter » la référence d’un point de départ à un point d’arrivée, répond aux objectifs pour lesquels on l’a produite ? Ou mieux encore : est-ce que, à la fin de l’expérience, les dispositifs techniques de transformation de ces inscriptions (cadre de l’instanciation) sont commensurables avec les objectifs de l’expérience (cadre de la réception) ? Et voilà que la commensurabilité entre les dispositifs mis en jeu en vue d’un objectif et les résultats finaux de cette chaîne de transformations pourrait finir par définir l’indicialité des images de statut scientifique : on aura une conception d’indicialité non pas a priori, mais a posteriori, ce qui nous éviterait d’être considérés comme des sémioticiens qui ne pourront jamais avoir une saisie sur les pratiques du sens, qu’elles soient scientifiques ou non. Il me semble que le gain pourrait être considérable. On pourra qualifier d’indicielle une chaîne d’images seulement lorsqu’elle aura, à la fin de sa carrière, accompli ses devoirs ; à ce stade, on pourra parler d’une indicialité en termes de maintien des promesses. L’indicialité concernerait par conséquent la densité d’enchaînement entre un instrument et l’autre, la densité des transductions réussies entre densité des données et leurs transformations contrôlées. Il s’agit d’une indicialité qui n’a rien à voir avec l’idée statique d’empreinte ou de contact, parce que c’est dans la densité des médiations qu’on peut retrouver la garantie d’un « transport ». Le rapport de motivation est donc à entendre non pas comme une relation de contact mais comme une transformation orientée de transductions réussies. De plus, comme le dit Latour, l’enchaînement d’épreuves garantit aussi le fait qu’on puisse revenir sur ses pas. C’est ce que j’appelle la contrôlabilité d’une chaîne. Si l’on continuait à concevoir l’indicialité comme une forme de garantie de commensurabilité entre un référent « déjà là » et une image qui le représente, on ne saurait pas s’expliquer le fonctionnement et le but des multiples transformations en chaîne produites dans les laboratoires… à quoi serviraient-elles ces transformations multiples ? Si l’objet était déjà là, la raison de toutes ces transformations ne s’expliquerait pas… Au contraire, c’est la chaîne des transformations qui permet de construire un référent, de caractériser les phénomènes, de les stabiliser et ensuite de les rendre manipulables : « L’objet doit être pénétré par la théorie et offert à (opened-up) une manipulation active de ses principes d’organisation » (nous soulignons)7.

On sait bien, et toute une littérature importante nous le dit de manière éclairante, que dans plusieurs disciplines, et notamment en astrophysique, les images finales qu’on obtient, ce sont les images qui font littéralement exister des phénomènes, voire qui permettent de les identifier et de les définir en tant qu’objets dont on peut discuter et sur lesquels on peut travailler. Les images réussies deviennent elles-mêmes des terrains de travail opératifs et opérables, dans le sens où elles sont non seulement des visualisations d’opérations qui rendent possible la définition de phénomènes (valeurs opératives), mais elles fonctionnent aussi comme des visualisations qui permettent d’être retravaillées et manipulées pour des fins ultérieures (valeurs opérables). On reviendra sur la question de la manipulation plus tard.

1. Le théâtre de l’apparition

Comme le dit Bordron dans son article paru dans Visible 5 « Expérience d’objet, expérience d’image », pour faire en sorte que quelque chose puisse se manifester il faut « fixer tout d’abord un référentiel technique qui donne la possibilité de l’objet et le sens de ce que l’on verra » (p. 116). Il continue ainsi :

Il n’y a pas d’objet sans un référentiel qui détermine son existence d’objet. L’astronome, de ce point de vue, ne se différencie guère de l’augure romain qui traçait un templum dans le ciel pour pouvoir donner un sens au vol des oiseaux. L’astronome n’est pas un devin mais, comme ce dernier, il a besoin, pour interpréter ce qui apparaît, de fixer d’abord ce qui sera le lieu de l’apparition. Que ce lieu se formule en longueurs d’ondes et non plus en espace change beaucoup de choses mais sans doute pas le fait qui nous intéresse ici : avant que l’image n’apparaisse, il faut avoir fixé l’économie de son apparition (p. 116-117, nous soulignons).

- Note de bas de page 8 :

-

On peut dire enfin que l’indicialité se mesure par rapport aux objectifs de ces chaînes de transformations et qu’on ne peut pas l’établir a priori, ou avant l’expérience. Il faut toujours calibrer les jugements sur les degrés d’indicialité par rapport au point de départ, au point d’arrivée souhaité ainsi qu’à partir de l’orientation de cette chaîne.

Pour le dire autrement, c’est seulement ce lieu de l’apparition qui nous permettra éventuellement d’affirmer/confirmer que la visualisation est bien indicielle. Dans la plupart des disciplines on ne part pas de données constituées en une unité d’objet : c’est justement une totalité nommable qui est recherchée et qui constituera l’objet. L’objet est donc à constituer et pour que cet objet devienne définissable et de plus en plus stable, voire iconique, il doit être non seulement contrôlable tout au long de ses transformations pendant une expérience : pour nous assurer justement de son indicialité, il doit nous assurer que quelque chose de constant s’est enfin conservé et a traversé toutes les transformées, comme le dirait Latour. Ce constant, ce fil rouge qui est transversal à toutes les transformations est ce qui lie le point de départ de l’expérience avec le lieu de l’apparition dont parle Bordron. Ce lieu de l’apparition je le nommerais plutôt comme un théâtre de forces où tout est disposé, équipé et aménagé pour accueillir les acteurs de ces transformations en chaîne, où les dispositifs transducteurs d’arrivée s’ajustent réciproquement tout au long du parcours et dont on ne peut pas prévoir les obtenues avant la fin du processus8. Le théâtre aménagé est le lieu où la congruence des transformations est censée émerger et être reconnue. Latour utilise une expression sympathique pour parler lui aussi de cette congruence : il affirme que : « Le référent scientifique s’allume comme une télévision si tous les éléments successifs du réseau des transformations sont bien alignés » (Latour 1993, p. 165). L’indicialité peut donc littéralement devenir mesurable par rapport à un système d’apparition prévu. Tout au long de la chaîne on essaie de transduire et de stabiliser des processus ; dans le théâtre de forces on reçoit des réponses aux hypothèses de départ.

Ce théâtre de forces qui est censé faire émerger la référence finale, référence qui se construit tout au long d’un voyage prédisposé par les règles techniques du laboratoire, n’est rien d’autre que le lieu où l’image se constitue en son horizon, en entendant par horizon ce qu’entend, encore une fois, Bordron (2009) :

Pour l’image astronomique […] rien n’a jamais été là avant l’image, du moins si on entend par être là, « être là comme objet ». Il s’agit moins pour elle d’approfondir ce qui a déjà été donné que de créer les conditions pour que quelque chose d’encore inconnu soit donné. La construction technique de l’image correspond de ce fait à une sorte de perspective inversée. Elle n’est pas là pour s’approcher de ce qui est déjà là à l’horizon […] mais elle est elle-même l’horizon qu’il s’agit de faire manifester. Appelons-la pour cette raison l’image horizon (nous soulignons, p. 117).

2. L’image entre global et local

- Note de bas de page 9 :

-

Voir à ce propos Lynch (1990). Quant à la question de l’allographisation des photographies, voir Dondero (2009a).

Certes, le parcours qu’on vient d’esquisser ne se produit que dans les domaines de certaines disciplines et il ne faut pas généraliser : chaque discipline a des points de départ et d’arrivée prévus qui ne peuvent pas se transposer/substituer à ceux d’autres disciplines. Comme le dit Michael Lynch, il ne faut pas penser que le travail du scientifique est toujours un travail qui vise à transformer les données disparates en des représentations schématiques, comme dans la biologie9. Dans d’autres pratiques médicales, le développement du processus est orienté d’une représentation globale ou générale du phénomène vers une représentation détaillée, locale. Il me semble que, par rapport à cette question, l’orientation de l’astrophysique est double, c’est-à-dire que la fabrication d’images en astrophysique nous montre bien le va-et-vient entre la visée locale et la visée globale des visualisations : d’une part, l’horizon de l’astrophysique est de présenter en unité, de compacter en un objet, par le biais de l’image justement, des fonctionnements dispersés dans le temps et dans l’espace (visée globalisante) ; d’autre part, cette unité d’objet se constitue par des visualisations diverses (modules) qu’on pourrait nommer de locaux (visée localisante). Chaque module est une réponse de l’« objet », par exemple de l’« objet galaxie », à la longueur d’onde avec laquelle il a été détecté. Les différents modules composent l’image finale, par exemple l’image d’une galaxie (Figure 1).

Figure 1. Galaxy Cluster MS0735.6 + 7421 © NASA, ESA, CXC/NRAO/STScl., B. Mc Namara (University of Waterloo and Ohio University). http://imgsrc.hubblesite.org/hu/db/2006/51/images/a/formats/print.jpg

Pour obtenir ce type d’image qui nous donne l’iconographie finale d’une galaxie, il a fallu un travail orienté du simple au composé, du local au global, mais d’autre part, cette totalité intégrée de modules doit pouvoir littéralement être redistribuée via une autonomisation de ses modules pour qu’ils puissent être utilisables pour la constitution de mesurages, hypothèses et iconographies autres que ceux de cette galaxie. Il s’agit de réaménager les modules qui ont, de leur côté, une certaine cohérence interne, une homogénéité de paramétrage et un certain degré d’unité, à travers des opérations de bricolage (dans le sens de Lévi-Strauss) pour essayer de voir s’ils sont aptes à construire d’autres iconographies, à faire avancer le référent, à étendre sa chaîne de transformations, et aussi à mettre à l’épreuve la transversalité d’utilisation de chaque module paramétré.

Résumons : d’une part, il faut « discipliner les opérateurs [de la chaîne] et les aligner de façon qu’ils comptent « pour un » » (Latour 2001), qu’ils forment une unité, pour que la chaîne puisse se constituer en une totalité stable et devenir un objet, mais il faut aussi penser au pouvoir d’extension du référent que la visualisation offre à la science, à savoir le fait que cette unité d’objet stabilisée en image peut servir comme modèle pour d’autres investigations. Or pour servir de modèle pour d’autres investigations, il faut que cette unité puisse être décomposable en des sous-unités ré-articulables, en des modules justement, et que ces modules puissent devenir des éléments d’une grammaire, voire des éléments qui se combinent à travers des règles strictes, comme dans le cas d’un langage où certaines combinaisons sont attestées, ou possibles, et d’autres non. Le mouvement des modules et leurs combinaisons montrent que pour éprouver la solidité d’un objet scientifique il faut essayer de l’étendre plus loin par un nouveau branchement de ces modules. A partir de là on peut comprendre si l’objet et ses composantes « résistent » à l’épreuve du transport, de la combinaison, de la commensurabilité.

- Note de bas de page 10 :

-

A propos de la notation voir Goodman (1990).

Dans l’image finale qu’on vient de voir, les éléments sont intriqués et c’est justement la modularité qui permet à l’unité construite de l’image finale de desintriquer et d’extraire des relations entre éléments et de les transporter au loin ; en fait, pour assurer la validité disciplinaire d’un objet il faut le solidifier, mais il faut aussi le rendre traductible, transportable. A savoir, il faut transporter au loin ces relations via le pouvoir combinatoire et grammatical des modules, entités recombinables à l’instar de notes dans une partition de musique qui fonctionnent comme des instructions pour l’exécution future. Cela revient à dire que le travail scientifique consiste bien, dans un premier temps, en la recherche de la stabilisation des hypothèses et des données en une unité d’objet et, dans un deuxième temps, à rendre cette unité manipulable, recombinable, réarticulable, pour la faire « courir au loin » et construire d’autres unités et d’autres référents. Les images scientifiques vivent dans un va-et-vient entre stabilisation d’une unité et manipulabilité des modules qui la constituent et qui permettent à cette même unité de profiter d’un système notationnel employable afin de constituer d’autres unités à venir10.

- Note de bas de page 11 :

-

Il faut parier aussi sur le fait que chaque module puisse se développer et déclencher une nouvelle chaîne de transformations, comme cela arrive en astrophysique : comme l’affirme Latour la référence est coextensive à ses réseaux de diffusion.

La nécessité d’une modularité est expliquée aussi par le fait que la chaîne des transformations qui vise à une stabilisation doit pouvoir être réversible, il faut pouvoir « revenir sur ses pas » : c’est une communauté entière qui doit pouvoir manipuler la chaîne et ceci dans toutes ses étapes. C’est pour cette raison que chaque discipline doit constituer une notationnalité, une sorte d’alphabet d’opérations paramétrées, pour que ceux qui font partie de la communauté puissent poursuivre la chaîne, la renverser, la refaire, la contrôler, la valider. Cette chaîne, réversible et orientée, doit pouvoir être interrompue en des sections discontinues, les modules justement. Il faut que chaque section de la chaîne puisse se constituer en un module11. Mais un module n’est jamais constitué par une unité ou une sous-unité, ou section isolable en une forme constituée, cernable. Un module concerne un ensemble de relations transposables. Autrement dit, il s’agit de relations diagrammatiques qui peuvent se présenter dans l’image de manière très diverse. En fait la notion de diagramme concerne des relations transférables : les opérations diagrammatiques ne sont jamais isolables et définitivement incarnées en une matière, car elles concernent des manières de mettre à l’épreuve et d’expérimenter des relations établies par rapport à un objet 1 pour la modélisation d’un objet 2. D’une certaine manière, on peut dire que les modules sont constitués par des paramètres et des mesures qui peuvent cependant s’émanciper de la matière sur laquelle ces paramètres et mesures ont été essayés. Les modules conservent quelque chose de la matière 1 qui les a incarnés, mais ils peuvent aussi s’ajuster pour « ordonner » une matière 2. Une totalité tel l’objet scientifique constitué doit toujours permettre l’extraction des relations diagrammatiques qui les constituent pour les expérimenter sur d’autres objets.

- Note de bas de page 12 :

-

Comme l’affirme Pierluigi Basso (communication personnelle), on voit qu’une connivence émerge entre l’image qui doit « fixer » un cadre argumentatif d’un phénomène et l’image qui l’offre à des nouvelles interprétations. Les images établissent un terrain de jeu mais à leur intérieur ce jeu est encore à rejouer, c’est la mise en abîme d’une tâche interprétative infinie. Chaque tentative de cartographier un objet scientifique choisit un certain cadre de relations qui se profile sur un fond d’une indétermination qui demande d’autres constitutions, aussi ou davantage signifiantes, dans une relance continuelle de son horizon destinal.

- Note de bas de page 13 :

-

Sur les concepts d’autographie et d’allographie voir Goodman (1990) et pour une relecture sémiotique voir Basso (2002) et Dondero (2009b).

Résumons à présent nos réflexions concernant la notion d’indicialité. L’indicialité doit être entendue non seulement en tant que production motivée et contigüe d’une trace de quelque chose d’existant, mais aussi en tant que résultat légitime d’une série de transformations : d’un côté, et en amont, la chaîne de transformations assure une garantie, celle d’une histoire de production par contigüité (autographie), de l’autre côté, et en aval, la chaîne de transformations doit assurer des développements (allographie) ; sa constitution doit pouvoir assurer une possible transposition des modules qu’on extrait de la visualisation en d’autres investigations, en d’autres recherches qui demandent une solution. On a donc deux fonctionnements de l’indicialité : elle peut assurer la fixation d’un alignement de traces qui forment une unité mais elle doit assurer aussi la possibilité d’étendre, de transmettre, de faire valoir de manière justifiable (motivée) ces traces constituées en modules en vue de la constitution d’autres unités d’objet12. Comment pourrait-on qualifier cette relation qui garde ensemble l’enracinement de la production (autographie) avec la transponibilité des résultats de l’investigation visuelle par le biais de la modularité (allographie) ?13 Cette relation entre autographie et allographie, entre enracinement de la trace et notationnalité des modules, nous amène évidemment à prendre en compte la relation entre visualisation et mathématisation.

3. L’indicialité entre autographie et allographie

Seulement quand le contexte sera disparu les échantillons feront réseau (Latour)

- Note de bas de page 14 :

-

Sur la sémiotique de l’imagerie contemporaine voir Fontanille (2009).

En reprenant le titre d’un livre important d’épistémologie des sciences et d’histoire des techniques, Image and Logic de Peter Galison, je voudrais esquisser la relation entre image et calcul en la traduisant en une relation entre autographisation et allographisation dans deux des trois étapes citées antérieurement : l’étape du dessin et de la photographie (en excluant pour le moment l’étape de l’imagerie contemporaine, qui a été d’ailleurs traitée dans Dondero 2009b)14. Il s’agirait de penser l’histoire de la relation entre obtenus visuels et mathématisation, entre la possibilité de visualiser des obtenus locaux et la nécessité de les rendre mesurables et transmissibles bref, de les rendre utilisables pour des fins ultérieures, non-locales. Est-ce qu’il s’agit de la relation entre des données locales (visualisation) et des généralisations qui en permettent la traduction et la commensurabilité (mathématisation) ?

- Note de bas de page 15 :

-

Il ne faut pas penser que l’imagerie ait substitué le dessin. Comme le démontrent plusieurs savants, tel Latour (2003) ou Galison (1998), le dessin peut arriver à caractériser des objets mieux que l’imagerie contemporaine (comme d’ailleurs en astrophysique l’image non paramétrée arrive à figurer des phénomènes que l’image contrôlée en laboratoire ne peut pas). Sur la relation entre image et valeur scientifique voir aussi Daston et Galison (2007) qui tracent une histoire de l’épistémologie scientifique en trois étapes (dominées respectivement par le dessin, la photo et l’imagerie contemporaine) et Snyder (1998) qui s’oppose à leur conception basée sur la distinction entre subjectif et objectif comme base de l’éthique du scientifique. Pour une excellente discussion de cela, voir Baetens (2010) infra.

On pourrait dire justement que dans le cas du dessin, la relation entre image et calcul n’était même pas pertinente ; la relation se constituerait entre l’objet à investiguer et le dessin qui est censé en rendre compte. La relation concernait donc un rapport de un à un, et la possibilité de généralisation apparaît comme exclue. Mais il ne faut pas oublier qu’un dessin sur papier millimétré est déjà un objet qui vise à une contrôlabilité et à une manipulabilité de ses éléments à des fins de transmission par le biais d’une notationnalité (possibilité, pour un fait, d’être transcrit sous forme de notation). Il faut en fait tenir compte que lorsqu’on a à faire avec la millimétrisation, on établit déjà la possibilité de la reproductibilité et de la transductibilité15. Une reproductibilité qui est pertinente justement parce que les sciences dures sont des disciplines plus « communautaires » que les sciences humaines : tout ce qui se fait en termes de visualisation et de calcul, se fait toujours par rapport à une communauté qui doit pouvoir répéter l’expérience pour évaluer. Le papier millimétré peut déjà garantir la possibilité d’une modularité et d’une transmissibilité.

D’une certaine manière, la photographie ne fonctionne pas, au premier abord, d’une façon si différente du dessin : les deux dispositifs semblent avoir la vocation à construire une relation strictement locale de un à un (stricte correspondance entre un objet et son image). La photographie a été considérée au tout début de son histoire comme plus précise et fiable par rapport au dessin à la main, grâce à sa mécanicité qui était censée exclure les « erreurs interprétatives » de la subjectivité. Il faut dire aussi que le dessin à la main sur papier millimétré a eu plus de chance de devenir un instrument de généralisation que la photo entendue comme l’enregistrement d’une empreinte. La photographie pouvait apparaître, encore plus que le dessin sur papier millimétré, comme un dispositif qui ne permettrait que de construire des relations locales, à savoir entre un objet et une image, bref, entre un particulier et un autre particulier. Avec la chronophotographie, en revanche, tout a changé en ce qui concerne la relation entre visualisation et généralisation. La chronophotographie de J.-E. Marey a pu poursuivre des résultats qui dépassent les avantages du millimétrage du dessin et augmentent la possibilité de contrôle des données et ensuite de mathématisation. Voici Etude de la marche d’un homme avec une baguette blanche fixée le long de la colonne vertébrale (Figure 2).

Figure 2. E.-J Marey Etude de la marche d’un homme avec une baguette blanche fixée le long de la colonne vertébrale, 1986. Chronophotographie, Paris, Cinémathèque française, collections des appareils.

La chronophotographie a pu coupler la prise locale (c.-à-d. la prise de l’empreinte, ici le trajet en bas en continu) avec la mesurabilité de cette empreinte même (la répétition de la baguette en mouvement), mesurabilité qui est déjà un instrument de traductibilité, reproductibilité, transmissibilité : elle est une photographie qui garde ensemble les détails locaux de l’empreinte et en même temps construit des discontinuités au sein de cette empreinte. Ce sont ces discontinuités qui permettent de construire une notation qui amène chaque chronophotographie à se dépasser elle-même : en passant par une notationnalité garantie par sa partie graphique, à savoir par la constitution de rapports spatio-temporels codés, elle peut devenir un texte d’instructions pour l’investigation et la comparaison d’autres phénomènes spatio-temporels que ceux concernant ce mouvement précis photographié ici.

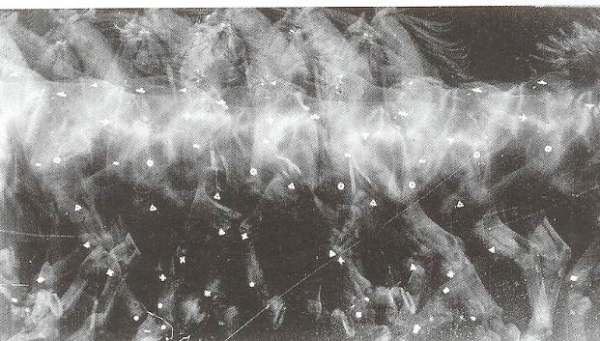

Mais venons à la description d’une autre chronophotographie de Marey, et notamment à l’image d’un cheval au trot Etude du trot du cheval (cheval noir portant des signes blancs aux articulations) (Figure 3).

Figure 3. E.-J. Marey : Etude du trot du cheval (cheval noir portant des signes blancs aux articulations), 1886, Chronophotographie, Paris, Collège de France.

Cette chronophotographie est censée capter l’empreinte du mouvement particulier de ce cheval précis (le flou du mouvement), mais la partie graphique (visualisée en tant que réseaux de points blancs), résultante du mesurage de la relation entre espace parcouru et durée de ce parcours fait d’intervalles, permet un paramétrage du mouvement dans la durée qui fonctionne comme une opération d’allographisation de ces mêmes données spatio-temporelles particulières. La notation est la constitution d’un alphabet de modules qui vise à offrir un plan de commensurabilité entre particularités ; pas spécialement de généralisations, mais justement des commensurabilités, et la possibilité de caractériser une image non seulement comme une image de quelque chose, mais comme un terrain d’opérations possibles en vue de manipulations ultérieures.

Ce n’est donc pas toujours vrai que le graphique est un produit des opérations d’abstraction et de schématisation d’une image. La chronophotographie nous montre que la configuration graphique peut être littéralement contenue à l’intérieur de l’empreinte photographique et, même, que ces deux configurations de l’image, à savoir la densité figurative de l’empreinte et les rapports mesurables entre espace et intervalle temporel, peuvent cohabiter et profiter l’un de l’autre afin de montrer un interstice de la commensurabilité entre les données locales et des patterns qui sont la source d’une grammaire de rapports entre espace parcouru et durée.

Voici une précision terminologique nécessaire. Je préfère utiliser le terme d’autographie pour décrire le produit de l’empreinte photographique et le terme d’allographie pour décrire la configuration graphique de la chronophotographie. Pourquoi utiliser le terme d’autographie et non pas, justement, de densité figurative ? Parce que la tradition sémantique d’autographie, qui remonte à la philosophie analytique anglo-saxonne, renvoie au fait que la saillance de l’image dépend de son histoire de production et que tout trait est syntaxiquement et sémantiquement dense, à savoir insubstituable. En ce qui concerne la configuration de l’image que Marey appelle graphique, pourquoi la décrire en utilisant le terme d’allographie ? Parce que dans le sémantisme d’allographie il est inscrit le sens de sélection, de stabilisation de règles et d’instructions ainsi que de transmissibilité : opérations, toutes, qui visent la production d’autres énoncés, tout en perdant évidemment la relation privilégiée avec le support d’inscription, unique et insubstituable. Comme cela arrive dans le cas de la partition musicale, ou du projet architectural, la partition musicale et le projet permettent, même quand le compositeur et l’architecte seront morts, de faire, à partir de leurs instructions transformées en notation, de nouvelles exécutions. Le terme d’allographie est un terme qui concerne plus largement la transmission et l’héritage des cultures dans la diachronie : la notation répond aux exigences de l’homme de tout temps de réduire le continuum d’un système dense de signes en des discontinuités, discontinuités modulables censées être ré-articulables. C’est sur l’allographie que se fonde la possibilité d’un héritage des cultures ; et dans les sciences cela a une importance capitale non seulement dans la diachronie, mais aussi dans la synchronie parce que quand la densité figurative d’une image s’allographise, comme dans la chronophotographie, cette même opération d’allographisation permet d’extraire de cette image des règles et de modéliser les relations entre temps et espaces parcourus, visualiser des constantes et des variantes, et de les rendre disponibles pour d’autres expériences dans d’autres laboratoires.

- Note de bas de page 16 :

-

Donc il faut plutôt penser à des moments d’autographisation qui se succèdent à des moments d’allographisation : ce qui nous permet d’aller plus loin que Peter Galison (1997) qui oppose image et logique, visualisation et numérisation. Et cela nous permet de comprendre que les sciences se basent sur un aller-retour entre visée locale et visée globale ; en fait les sciences se basent toujours sur un raisonnement diagrammatique, à savoir sur la transversalité entre particulier et général : le diagramme est transversal à ces deux opérations de particularisation et généralisation et je dirais même qu’il en est le médiateur.

La notation sert à rendre communicable et surtout transférable un système culturel, forcément dense, aux générations futures. L’allographisation d’une image permet de sélectionner des relations de données, d’extraire des règles et de rendre enfin transposables les résultats d’une investigation, de mathématiser et de fabriquer d’autres images également16. L’image, en s’allographiant, devient comparable avec d’autres images, manipulable et orientée au futur. En affichant des patterns et des régularités, elle peut devenir ainsi une image prédictive.

Ces images de Marey sont enfin des visualisations qu’on pourrait qualifier de diagrammatiques, en empruntant à Goodman le sens du terme diagramme. Le diagramme se constitue dans la commensurabilité pressentie entre dimension autographique et dimension allographique des énoncés. Le diagramme valorise en même temps le support des données (densité figurative, autographie) et le fait que ces données peuvent devenir des véritables exemplifications pour d’autres pratiques d’investigation — dans le régime de l’allographie, évidemment, le support des inscriptions et leur densité n’est plus pertinent.

- Note de bas de page 17 :

-

Si la densité autographique du module reste forte, le module aura moins de chance de construire des patterns susceptibles de s’étendre au loin, mais si sa densité possède des mailles trop grandes, son heuristique n’est pas certaine non plus : ce module pourra se combiner avec tout autre, pour constituer n’importe quelle chaîne de transformations : la non sévérité de ses paramètres lui empêcherait de fonctionner comme un paramètre décisif pour la constitution de nouvelles chaînes de la référence scientifique

- Note de bas de page 18 :

-

Comme le montre très bien le cas des mathématiques grecques étudiées par Reviel Netz (1999), une des raisons de leur succès est d’avoir « inventé » un système économique de formules, bref, une notation, qui leur a permis de réduire le localisme du dessin pour gagner en grammaticalisation.

Comme on l’a déjà dit, un module produit, par exemple, par une opération d’allographisation de l’image-empreinte, possède la caractéristique d’être transférable et d’être une part d’une notation qui décide des rapports syntagmatiques et paradigmatiques permis et interdits entre modules. Des règles de combinaison entre modules et de leurs densités17 dépendent les réseaux plus ou moins longs et plus ou moins étendus du référent scientifique sur lequel on s’est arrêté auparavant. La possibilité d’étendre la référence par des branchements de modules est un des buts principaux, sinon le but principal, de la recherche scientifique : l’allographisation des données visualisées rend possible l’investigation future grâce à sa notation. La notation permet de transformer une image unique et insubstituable, car source du phénomène, en une configuration de rapports réutilisable. Les modules doivent former un vocabulaire limité de rapports, un système économique18 de rapports, par exemple entre intervalle temporel et mouvement dans l’espace. Des données et de leurs ancrages dans une phénoménologie des expériences sont extraits des patterns qui nous permettraient de construire des notations. Mais ce qu’on extrait des images autographiques ce ne sont pas des données, mais des relations entre données, des équivalences, des moyennes, bref des fondements pour des comparabilités futures. Et le diagramme se situe au milieu de ces deux stratégies de représentation : entre la densité et la notation, entre une opération de grammaticalisation (image prédictive) et une opération de densification (image qui vise à expliquer ou résoudre des cas précis). La caractéristique la plus générale du diagramme est bien celle qu’il combine les patterns et les détails. Il laisse ouvertes les deux possibilités : d’une part la densité et le localisme, de l’autre la grammaticalisation et la généralisation, permettant ainsi un regard anamorphique. Le diagramme est en somme une forme abstraite de relation qui est exemplifiée dans l’expérience mais transposable pour d’autres expériences. Il est un pattern reconnaissable de relations en-deçà de l’hétérogénéité de l’expérience.

Conclusions

- Note de bas de page 19 :

-

Tufte (2005) affirme que le meilleur diagramme n’est pas du tout celui qui part du particulier pour arriver au général : rien de plus faux. L’intérêt d’un diagramme est de montrer la relation entre micro (détail) et macro (totalité), où par totalité on entend les patterns ainsi que les orientations temporelles. Il ne s’agit pas de simplifier, dans le passage du particulier au général, mais de densifier les détails en cherchant d’y reconnaître des patterns.

A partir de la chronophotographie on ne peut plus penser que l’image nous offre une vision du particulier et le graphique une vision du général. On peut garder ensemble, dans une même image, une visualisation micro et une visualisation macro, des particularités et des régularités, comme nous l’ont appris les travaux de Tufte (1997, 2005)19. Et comme nous l’ont montré aussi les études récentes de Jean-Marie Klinkenberg (2009) sur la relation entre tabularité et linéarité dans les graphiques : un graphique peut fonctionner comme un diagramme s’il construit une commensurabilité entre le local et le global, entre données particulières et règles transmissibles, généralisables.

Finalement, ce sont les pratiques scientifiques elles-mêmes qui sont diagrammatiques : qu’est-ce qu’une pratique diagrammatique ? Une pratique qui puisse garder un équilibre entre, d’une part, l’analyse des cas singuliers et l’autographisation du jugement (qu’on peut appeler expertise du scientifique ou bien trained eye pour le dire avec les mots de Galison) et, de l’autre, l’allographisation, qui concerne la reproductibilité, traductibilité et communicabilité des résultats pour une communauté scientifique via la géométrisation et la mathématisation.