Nouvelles organologies du sonore : les audio-games

La question des interfaces a-musicologiques New musical organologie: the audio games. The question of a-musicological interfaces

Cet article propose d’éclairer un champ créatif émergeant : les « audio-games » ou « vidéo-ludiques sonores », se situant au carrefour du jeu vidéo et de l’informatique musicale. Aujourd’hui, une multitude de petites applications, qui proposent des expériences audiovisuelles ludiques où la dimension sonore est prépondérante, sont disponibles sur des consoles de jeux, des ordinateurs, des téléphones portables. Ces expériences représentent un nouvel espace où la notion de « jouabilité » venue du jeu vidéo et appliquée à la création musicale favorise de nouveaux ponts entre les deux disciplines. Ce champ créatif, en proposant la manipulation de représentations que nous appelons « a-musicologiques » (c’est-à-dire utilisant des symboles ne faisant pas référence à la musicologie classique pour manipuler et produire du sonore) interroge de manière nouvelle la représentation du sonore et des structures musicales et produit ainsi de nouveaux gestes instrumentaux et compositionnels qu’il s’agit d’étudier. Après avoir défini les caractéristiques et les limites de ce champ et repéré quelques-unes de ses filiations historiques (cinéma abstrait, théorie du jeu en musique, partition graphique et d’actions…), nous étudions quelques exemples de jeux sonores et proposons des pistes de recherche pour l’élaboration d’outils d’analyse de ces nouveaux objets.

This article aims to shed light on a new and emerging creative field: Audio Games, a crossroad between vidéo games and computer music. Today, a plethora of tiny applications, which propose entertaining audio-visual experiences with a preponderant sound dimension, are available for game consoles, computers, and mobile phones. These experiences represent a new universe where the gameplay of vidéo games is applied to musical composition, hence creating new links between these two fields. In proposing to manipulate what we refer to as “a-musicological” representations (i.e. using symbols not normally associated with traditional musicology to manipulate and produce sound), this creative aspect raises new questions about representations of sound and musical structures and requires new instrumental gestures and approaches to composing music which will be examined. After having defined the characteristics and the limits of this field and highlighting a few of the historical milestones (abstract cinema, gaming theory in music, graphic actions and scores), we will study a few examples of musical games and propose areas for further research to devise analytical tools for these new objects.

1. Introduction

- Note de bas de page 1 :

-

Nous empruntons la notion d’interface « a-musicologique » à l’article de Francis Rousseau et Alain Bonardi (Bonardi, Rousseau, 2003).

Cet article propose d’apporter un éclairage sur un champ créatif émergeant : les « audio-games » ou « vidéo-ludiques sonores », se situant au carrefour du jeu vidéo et de l’informatique musicale. Aujourd’hui, une multitude de petites applications, qui proposent des expériences audio-visuelles ludiques où la dimension sonore est prépondérante, sont disponibles sur des consoles de jeux, des ordinateurs mais aussi sur des téléphones portables. Ces expériences représentent un nouvel espace où la notion de « jouabilité » venue du jeu vidéo peut faciliter la jonction avec la création musicale. Ce champ créatif, en proposant la manipulation de représentations que nous appelons « a-musicologiques »1 (c’est-à-dire utilisant des symboles ne faisant pas référence à la musicologie classique pour produire du sonore), interroge de manière nouvelle la représentation du sonore et des structures musicales et produit ainsi de nouveaux gestes instrumentaux et compositionnels qu’il s’agit d’étudier. Il interroge ainsi, et de manière originale, la question de la convivialité dans son rapport à la créativité. De fait, toute une nouvelle organologie du sonore est en train de se constituer, renouvelant de manière profonde le rapport au musical (représentations abstraites synesthésiques, manipulations 3D, simulation de phénomènes physiques comme le rebond, l’élasticité…).

Après avoir défini les caractéristiques et les limites de ce champ et repéré quelques-unes de ses filiations historiques (cinéma abstrait, théorie du jeu en musique, partition graphique et d’actions), nous étudierons quelques exemples de jeux sonores et proposerons des pistes de recherche pour l’élaboration d’outils d’analyse de ces nouveaux objets.

2. Définition du champ

Une rapide recherche sur internet nous propose de nombreux termes décrivant ce nouveau champ et ses multiples sous-genres : audio-games, music video-games, music memory-games, rythm-games, pitch-games, volume-games, eidetic music-games, generative music-games… Pour éviter d’entrer dans des querelles de chapelles nous préférons une acceptation plus large englobant l’ensemble des situations de croisement entre le jeu et la production musicale, la particularité principale du domaine étant la superposition de ces deux univers avec des points de contact mais aussi des objectifs cognitifs différents. Ainsi, il est utile dès à présent d’écarter une ambiguïté possible en soulignant que notre objet de recherche ne concerne pas directement la dimension sonore des jeux vidéos (domaine concernant plutôt le design sonore interactif) mais plutôt une nouvelle organologie qui emprunte l’activité vidéo-ludique pour produire du sonore avec comme particularité l’utilisation massive de l’interactivité numérique et un nouveau rapport à l’image. L’« audio-game » s’inscrit, concernant la dimension sonore, dans un espace situé entre l’instrument, la boîte à musique et les automates musicaux. Aussi, la question de l’équilibre entre liberté et contrainte donné au joueur est centrale dans la réussite d’un vidéo-ludique sonore. De fait, plus les règles sont ouvertes et complexes, plus le jeu est intéressant musicalement mais nécessite un investissement important dans son apprentissage. À l’inverse, plus les contraintes sont rigides et directives, plus la prise en main sera facile, voire quasi immédiate, mais avec le risque non négligeable d’un résultat sonore soit trop pauvre, soit trop répétitif. Une deuxième caractéristique importante de ce nouvel objet culturel que nous essayons de circonscrire est le développement d’une relation originale entre l’image et le son. En effet, la superposition de deux univers (du jeu et de la production sonore) se concrétise dans l’interface et la manipulation interactive qui ne font pas, le plus souvent, référence à la musicologie mais plutôt aux règles spécifiques du jeu (combattre des adversaires, manipuler des objets…). C’est bien l’utilisation, dans ce cas, d’interfaces que nous appelons, à la suite de Rousseau et Bonardi, « a-musicologiques » qui nous semble être la principale originalité de cette nouvelle organologie du sonore.

3. Jouabilité et jeu instrumental

Entre le monde du jeu vidéo et celui du sonore, un point de jonction peut être trouvé dans la notion de « jeu », notion qui mérite que nous nous y attardions. Dans le monde du jeu vidéo, ce sont les termes de « jouabilité » et de « game-play » qui sont le plus souvent utilisés pour décrire cette dimension. Pour certains (au Canada en particulier) les deux termes sont considérés comme synonymes et « jouabilité » est utilisé comme la traduction française de « game-play ». Pour d’autres, les deux termes recouvrent des réalités différentes bien que très proches, le premier étant considéré comme un sous-ensemble du second. Le premier terme recouvrerait alors le plaisir de jouer, le second terme faisant plutôt référence aux principes du jeu. Les deux notions étant très proches (et l’une dépendant directement de l’autre), nous préférons ici utiliser le terme français de « jouabilité » pour décrire l’ensemble des éléments de l’expérience vidéo-ludique : à la fois règles, interface et maniabilité du jeu ainsi que leurs appropriations par le joueur (le plaisir retiré et sa facilité d’appropriation). Mais quels sont les points communs entre la jouabilité des jeux vidéo et le jeu instrumental ? Si l’on définit la jouabilité comme le caractère de ce qui est jouable, de ce qui peut être joué, alors on peut trouver une correspondance musicale dans la notion de musicalité, de ce qui est « bien écrit » pour un instrument donné et qui « sonne » bien. On pourra alors parler de la « jouabilité » d’une pièce pour piano en référence au plaisir du pianiste à jouer cette partition et à son aptitude à investir son interprétation. Concernant la dimension de la prise en main des règles du jeu, la posture du joueur ne trouve pas son équivalence directement dans la répartition classique des rôles de l’acte musical : ni vraiment compositeur, ni uniquement instrumentiste, ni simple auditeur.

Un compositeur a pourtant remarquablement déplacé les affectations de ces rôles et permis un rapprochement remarquable vers la dimension ludique. En effet, dès la fin des années cinquante, John Cage (1912-1992) enrichit sa recherche sur le hasard et l’indétermination en transformant la partition en un espace de jeu mettant en œuvre des règles que l’interprète doit incorporer et surtout faire vivre. La partition passe ainsi du statut de notation de paramètres musicaux à celui de notations d’actions. Pour exemple, dans Variations I (1958), Variations II (1961) ou Cartridge Music (1960) : les notes sont inscrites en valeurs relatives (grosseur de points se référant à l’intensité et à la durée) sur des feuilles transparentes que l’interprète superpose à d’autres feuilles elles aussi transparentes contenant des règles de jeux (des formes géométriques, un cadran d’horloge…). Cette superposition de feuilles contenant des informations de niveaux différents (notes et règles) produit la partition à interpréter. Nous le voyons ici, l’interprète doit, avant de jouer la moindre note, agencer un dispositif pour produire les informations musicales à jouer, un « travail » classiquement alloué au compositeur lui-même. Cette nouvelle définition du rôle de l’instrumentiste permet de retrouver les dimensions des deux termes anglais qui décrivent le jeu : « game » et « play ». Le terme « game » soulignant la notion de structure (système de règles que le joueur s’impose de respecter pour mener à bien son action), tandis que le terme « play » soulignerait l’attitude ludique adopté par le joueur (« l’action menée par celui qui joue ») (Genvo, 2002). En modifiant le rôle de l’interprète, John Cage augmente considérablement l’espace de liberté et de créativité de celui-ci, deux dimensions à la base de l’attitude ludique.

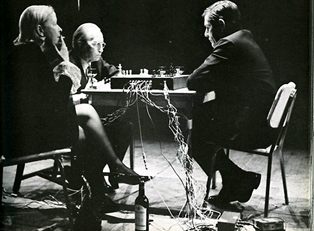

Ce rapprochement de la composition et de la théorie des jeux se retrouve de manière encore plus explicite chez le compositeur dans sa célèbre pièce/performance Reunion (1968) qui le met en scène avec Marcel Duchamp dans une partie d’échecs où chaque mouvement de pièce dirige de manière plus ou moins aléatoire des événements musicaux.

Figure 1. John Cage (1960), Cartridge Music

Figure 2. John Cage (1968), Reunion (avec Marcel Duchamp à Toronto)

Nous retrouvons la théorie du jeu chez d’autres compositeurs comme Iannis Xenakis Duel (1959), Stratégie (1962) et Linaia Agon (1972), Mauricio Kagel (Match (1964) inspiré d’un match de tennis) ou John Zorn Cobra (1984).

Si ces approches concernent un dialogue entre deux spécialistes (le compositeur et l’interprète), les objets vidéo-ludiques ont la particularité de s’adresser principalement à un large public d’amateurs. Cette attitude ludique grand public nous renvoie aux écrits de Flusser (1996) concernant la photographie, écrits particulièrement éclairants sur la spécificité de nos objets d’étude : Flusser définit en effet l’appareil photo comme un jouet structurellement complexe mais fonctionnellement simple, permettant de faire des images sans compétences particulières, ouvrant ainsi cette activité à un vaste public d’amateurs :

- Note de bas de page 2 :

-

Ouvrage précité (p. 35).

L’appareil photo n’est pas un outil mais un jouet et le photographe n’est pas un travailleur mais un joueur : non pas « homo faber » mais « homo ludens ».2

Et plus loin :

- Note de bas de page 3 :

-

Ouvrage précité (p. 78)

Bien que l’appareil photo se fonde sur des principes scientifiques et techniques complexes, il est très facile de le faire fonctionner. C’est un jouet structurellement complexe mais fonctionnellement simple. En cela, il est l’opposé du jeu d’échecs, qui est structurellement simple mais fonctionnellement complexe : ses règles sont faciles, mais il est difficile de bien jouer aux échecs. Celui qui a un appareil photo entre les mains peut très bien produire d’excellentes photographies sans pour autant avoir la moindre idée de la complexité des processus qu’il met en marche en appuyant sur le déclencheur.3

Cette délégation de compétences du spécialiste (le photographe ou le compositeur) vers l’amateur apparaît comme le paradigme fondateur de cette nouvelle classe d’objets culturels. Paradigme qui s’inscrit dans un mouvement de fond lié aux nouvelles technologies de l’information. Weissberg (2001) dans son article sur l’émergence de la figure de l’amateur montre bien les nouveaux espaces intermédiaires qui se créent entre production et réception, entre professionnels et amateurs. L’auteur avance la notion de compétences graduées et souligne la dimension politique de ces nouvelles postures porteuses d’autonomie. Dans cette délégation, la question de la convivialité des interfaces est de toute évidence centrale. Si celle-ci facilite le transfert de compétences et tend à rendre intuitives des opérations complexes, nous soutenons que dans le champ applicatif que nous explorons : la composition musicale, la question de la convivialité est directement liée à la question centrale de la représentation du sonore et de ses structures musicales dans sa capacité à rendre concret et visible ce qui est abstrait et sonore.

4. Trois filiations historiques

Nous pouvons appréhender l’émergence récente des « audio-games » dans une filiation de rapprochement des arts graphiques et des arts sonores qui prend naissance vers la fin du dix-neuvième siècle et connaît son essor tout au long du vingtième siècle (Bosseur, 1998). Cette dynamique historique prend de nombreuses formes dont l’étendue dépasse largement le cadre de cet article (Zénouda, 2008), nous nous contentons ici d’en présenter très succinctement trois.

4.1. La musique audiovisuelle ou « colorée »

- Note de bas de page 4 :

-

Five film exercices (1943-1944) (http://www.my-os.net/blog/index.php?2006/06/ 20/330-john-whitney)

- Note de bas de page 5 :

-

Withney John (1980), Digital harmony on the complementary of music and visual arts, Bytes Books, New Hampshire.

- Note de bas de page 6 :

-

Studie Nr 7. Poème visuel (1929-1930), Studie Nr 8 (1931)…

- Note de bas de page 7 :

-

A Colour Box (1935)…

L’expression « musique audiovisuelle » est avancée dès le début des années 19404 par John Withney5 qui en définit les caractéristiques en travaillant la question de tempo et celle des rapports cinématographiques spécifiques (couples temps/espace et forme/couleur). Néanmoins, la « musique audiovisuelle » ou « colorée » est présente bien plus tôt, dès les années 1920, avec des réalisateurs comme Oskar Fishinger6 ou Len Lye7 et s’inscrit dans la mouvance des interrogations sur la correspondance entre les arts et sur la synesthésie chère à des peintres abstraits comme Kandinsky ou Klee. La volonté de ces réalisateurs est de trouver un langage cinématographique spécifique « libéré » de la narration et des formes issues du roman et du théâtre. Pour cela, ces cinéastes vont s’éloigner de la fonction première de captation du réel du cinéma en choisissant d’utiliser de préférence des formes non figuratives et en recherchant des modèles de construction de l’œuvre du côté de cet art abstrait par excellence qu’est la musique. Avec la durée et le rythme comme dénominateur commun, ces réalisateurs vont chercher à produire des œuvres synesthésiques « totales » jouant sur les relations subtiles entre les différents sens.

Figure 3. Jordan Belson (1961), Allures (http://www.mediafire.com/?fy920bhvu6q6b1v)

4.2. Les partitions graphiques

- Note de bas de page 8 :

-

John Cage mais aussi Earle Brown, Pierre Boulez, André Boucourechliev et bien d’autres…

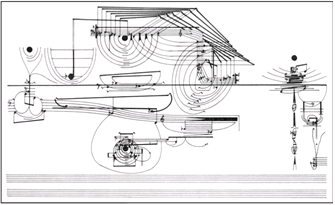

Comme nous l’avons vu précédemment avec la partition Cartridge Music (Cage, 1960), les principes d’indétermination développés par de nombreux compositeurs dès la fin des années cinquante8 obligent à repenser la partition comme outil de communication musicale. Un genre nouveau apparaît dans un rapprochement des arts sonores et visuels. Les compositeurs élargissent leurs palettes de symboles (couleurs, formes, profondeurs, textures…) pour décrire de nouvelles sonorités et des processus musicaux inédits. Ces nouvelles représentations introduisent des espaces de liberté liés à l’improvisation et mettent en avant des indications musicales globales ou volontairement floues qui sapent l’obsession de contrôle de la musique contemporaine. Le compositeur se charge de la macrostructure (tandis que l’interprète se charge du détail de la réalisation), et communique à l’interprète d’autres types d’informations moins précises comme des sensations, des émotions, des mouvements, des dynamiques.

Figure 4. Cornelius Cardew (1963-1967), Treatise

4.3. Les interfaces graphiques pour la composition musicale

- Note de bas de page 9 :

-

Unité Polyagogique Informatique du CEMAMu (Centre d’Etudes de Mathématiques et Automatique Musicales)

- Note de bas de page 10 :

-

http://www.youtube.com/watch?v=yztoaNakKok

- Note de bas de page 11 :

-

http://acg.media.mit.edu/people/golan/

- Note de bas de page 12 :

-

Massachusetts Institute of Technology (USA).

- Note de bas de page 13 :

-

Aurora (1999), Floo (1999), Yellowtail (1999), Loom (1999), Warbo (2000).

- Note de bas de page 14 :

-

An inexhaustible audiovisual substance which is created and manipulated through gestural mark-making. Golan Levin

- Note de bas de page 15 :

-

http://www.blueyeti.fr/Grapholine.html

- Note de bas de page 16 :

-

Camille Barot et Kevin Carpentier.

- Note de bas de page 17 :

-

http://www.utc.fr/imp/

Dans les années soixante-dix, le compositeur Iannis Xenakis, intéressé lui aussi par les rapports entre la vision et l’audition, propose une interface graphique pour la composition musicale sous le nom de l’UPIC910. Le compositeur peut, grâce à une palette graphique, dessiner les formes d’ondes et les enveloppes d’amplitude, et contrôler à la fois la structure du son et la forme globale de l’œuvre. Plus récemment, Golan Levin11, chercheur au MIT12, propose une série d’« instruments »13 qui associent de manière très étroite l’image, le son et le geste. Développeur de palettes graphiques qu’il sonorise en générant en temps réel des sons de synthèse, il associe des paramètres du geste, comme la direction et la vitesse du mouvement ou la pression du crayon électronique, à des paramètres sonores, comme le timbre, la hauteur, le panoramique, et à des paramètres graphiques, comme la couleur, l’épaisseur de trait ou la direction. Chez Golan Levin, les notions d’interactivité et de générativité sont étroitement liées : l’image et le son sont générés en temps réel, à partir du geste de l’utilisateur créant ainsi une « substance audiovisuelle malléable générative et interactive »14. En France, la société Blue Yeti15 propose le système Grapholine de dessin musical à doubles écrans basé sur la transformation d’échantillons sonores (via une banque de sons standard mais aussi personnalisables) par la synthèse granulaire et offrant une large gamme de manipulations et de relations image/son (vitesse du tracé, transparence, luminosité, couleur, pression du crayon…). À l’UTC de Compiègne, deux étudiants16 en dernière année de cursus informatique, proposent une application de réalité virtuelle (Immersive Music Painter, 201017) où l’interactant dessine dans l’espace, par son geste, des courbes de différentes couleurs et d’épaisseurs auxquelles est associé un son ou une mélodie dont la hauteur, le panoramique et le volume sont contrôlables.

Ces trois champs s’inscrivent dans des problématiques de représentation du sonore et d’interaction avec le son et concernent le public spécialisé du cinéma expérimental pour le premier champ et les compositeurs et les interprètes pour les suivants. Les « audio-games » viendront ajouter à ces deux problématiques la dimension ludique, et avec elle, la question de la convivialité et de la simplicité de l’interface, ouvrant ainsi ce type d’applications à un large public d’amateurs quel que soit son niveau de connaissances musicales.

5. Typologie des « audio-games »

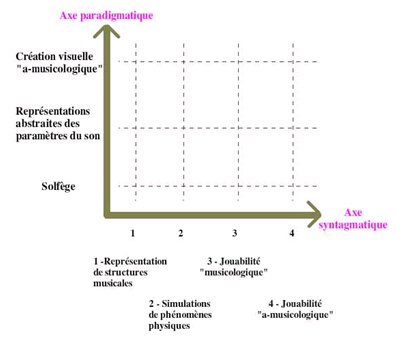

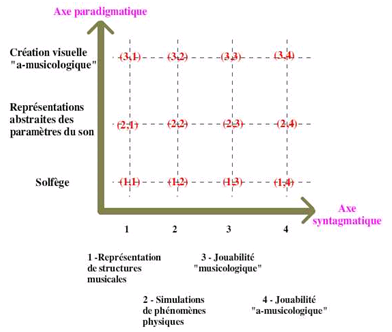

Nous cherchons à construire une typologie la plus simple et la plus générale possible permettant d’intégrer tous types d’audio-games ainsi que tous types de musiques produites indépendamment des styles et du niveau d’expertise des utilisateurs. Pour cela, nous nous concentrons sur la question de la représentation (fixe ou dynamique) de deux types d’entités sonores : les éléments de base (axe paradigmatique) et les éléments construits par la manipulation (la jouabilité) proposée par le jeu (axe syntagmatique).

L’axe paradigmatique vertical concerne la représentation des éléments sonores de base que l’audio-game met à disposition du joueur. La représentation graphique de cet élément de base pourra s’étendre du solfège classique à des créations graphiques sans lien direct avec le sonore en passant par des représentations abstraites liées à la synesthésie (et à tous types de correspondances avec les différents paramètres du son). Notons que la frontière entre un son élémentaire et un son faisant l’objet d’une construction dépend du type de jeu et de l’interaction proposée. Ainsi, ce qui sera un objet sonore composé dans un audio-game peut être pris comme élément de base dans un autre. Les items de cet axe pourront donc être modifiés en fonction des audio-games à analyser et seront positionnés suivant leurs éloignements ou proximités du solfège traditionnel.

Figure 5. Typologie des « audio-games »

L’axe syntagmatique horizontal concerne la représentation d’objets sonores construits par la jouabilité du jeu. Il s’agit bien ici de représentations des opérations de constructions de ces objets sonores de second niveau. Ces représentations peuvent être fixes et proches des manipulations musicales classiques (représentations des opérations de répétitions, de transpositions, de renversements…) ou dynamiques (représentations de simulations de phénomènes physiques comme le rebond, l’explosion, l’accumulation…) ou encore décrire des dynamiques de jouabilités « musicologiques » ou « a-musicologiques ». Les premières peuvent trouver des analogies musicales directes (déplacements dans l’espace, jeux de miroirs…), les secondes n’ont aucune analogie avec le musical et impliquent donc des relations arbitraires et ad-hoc liées à la diégèse du jeu (jeux de combats…). Comme pour l’axe paradigmatique, les items de l’axe syntagmatique pourront être modifiés en fonction des audio-games à analyser et seront positionnés suivant leurs éloignements ou proximités du solfège traditionnel.

6. Présentation de quelques « audio-games »

- Note de bas de page 18 :

-

http://www.youtube.com/watch?v=rb-9AWP9RXw&feature=related

- Note de bas de page 19 :

-

[2,1] = 2 sur l’axe paradigmatique et 1 sur l’axe syntagmatique

- Note de bas de page 20 :

-

http://www.youtube.com/watch?v=mN4Rig_A8lc&feature=related

-

Aura (sur iPhone et iPad)18 [2,1]19, très proche de l’esthétique de pièces comme Allegretto de Fishinger (1936) ou Allures de Belson (1961), propose, sur un fond musical généré, de construire ses propres mélodies (toujours en harmonie avec le fond sonore) en choisissant la note, le timbre et le volume via des formes colorées simples à l’écran. Le processus de création audiovisuel se fait de manière fluide et ininterrompue et le fond musical et visuel change en secouant simplement son iPhone. Le joueur produit, en touchant l’écran de son doigt, musiques et formes abstraites dans ce qui est présenté comme un générateur interactif de musique (et d’image) d’ambiance. Une application comme SynthPond20 (iPhone et iPad) [2,1] propose de positionner des formes sur des cercles de diamètres différents. Des notes sont jouées quand ces formes rencontrent les ondes visuelles produites par des formes carrées ou l’intersection des autres cercles. À la différence d’Aura, SynthPond produit une musique de boucles répétitives dont il est possible de prévoir visuellement le rendu sonore en suivant le déplacement des formes et leur rapprochement des différentes intersections. Le joueur peut sélectionner les hauteurs, le timbre et le tempo des boucles permettant ainsi un résultat sonore potentiellement complexe.

Figure 6. Aura

Figure 7. Synthpond

- Note de bas de page 21 :

-

http://www.youtube.com/watch?v=2a1qsp9hXMw

- Note de bas de page 22 :

-

http://www.youtube.com/watch?v=xuYWLYjOa_0&feature=fvst

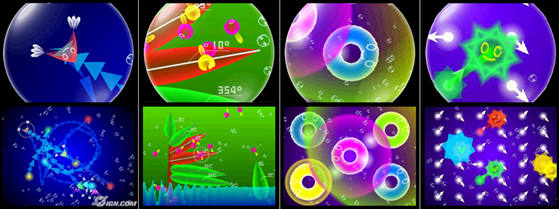

Deux jeux originaux de tirs musicaux : Rez (Mizuguchi, 2001, Sega)21 [2,4] et Child of Eden (Mizuguchi, 2010, Xbox360)22 [2,4] nous rapprochent de jeux plus classiques en gardant une dimension sonore importante. Rez se présente comme un jeu de combat où la partie musicale est créée dynamiquement en fonction des actions du joueur. Chaque tir du joueur ou des vaisseaux ennemis produit un son qui s’adapte rythmiquement et harmoniquement à la bande son. L’expérience de jeu devient ainsi particulièrement originale, la mission ludique (détruire des vaisseaux ennemis) est la source de la production de l’image et du son. Le discours du concepteur faisant référence à Kandinsky et à la synesthésie relie ce jeu aux jeux décrits précédemment. Pour accentuer cette recherche de synesthésie, l’agglomérat de sensations simultanées est stimulé par la vibration de la manette de jeu au moment de la synchronisation de l’image et du son.

Figure 8. Rez

Figure 9. Child of Eden

Dans Child of Eden, Mizuguchi continue cette quête d’une jouabilité générant le son en utilisant les innovations technologiques les plus récentes (image haute définition, son spatialisé en 5.1, reconnaissance de mouvements avec Kinect permettant de ne plus utiliser ni souris ni manette). La reconnaissance des mouvements permet une prise directe avec les images ainsi que de nouveaux types d’interactions (le claquement de mains, par exemple, permet de changer d’armes pendant le jeu). L’esthétique visuelle y est beaucoup plus chatoyante et psychédélique que dans Rez et la mission ludique est de supprimer un virus qui cherche à mettre en péril le projet de recréer une personnalité humaine au sein d’Eden (mémoire de l’humanité). Chaque niveau correspond à un palier de cette archive de l’humanité et le dernier niveau intègre les contributions personnelles des joueurs sous la forme de photos de leurs moments heureux.

- Note de bas de page 23 :

-

Havryliv Mark, Narushima Terumi, Metris: a game environment for music performance, http://ro.uow.edu.au/era/313/

- Note de bas de page 24 :

-

http://www.youtube.com/watch?v=JmqdvxLpj6g&feature=related

-

Metris23 (Mark Havryliv, Terumi Narushima, Applet Java) [2,3] est une adaptation du célèbre jeu Tetris à une dimension de création musicale. À chaque block en déplacement est associé un son de cloche généré par de la synthèse en temps réel. Les actions de l’utilisateur qui déplace ou qui applique des rotations sur ce block produisent des modifications sonores de hauteurs. La manière dont ces blocks s’encastrent produit différents accords. L’ensemble des possibilités permet de produire une composition microtonale sophistiquée sans perdre l’intérêt du jeu initial de Tetris.

-

Pasy0224 (iPhone et iPad) [2,2] se présente comme une grille que l’on peut déformer et étirer à loisir et qui revient à la normale dans un effet d’élasticité. Ces modifications physiques influent sur les paramètres comme la hauteur, le tempo et le timbre de boucles musicales jouées par un synthétiseur dont les formes d’ondes (sinusoïde, triangle, carré, dents de scie) peuvent être sélectionnées par le joueur pour obtenir des résultats sonores variés. Le dispositif très simple offre une approche particulièrement originale et directe de production du son.

Figure 10. Pasy02

Figure 11. ElectroPlankton

- Note de bas de page 25 :

-

http://www.youtube.com/watch?v=aPkPGcANAIg

- Note de bas de page 26 :

-

Dix tableaux : Tracy/Trapy, Hanenbow, Luminaria, Sun-Animalcule, Rec-Rec, Nanocarp, Lumiloop, Marine-Snow, Beatnes, Volvoice.

-

Elektro-Plankton25 (Toshio Iwai, Nintendo) est un jeu emblématique qui propose un ensemble de dix tableaux mettant en scène des planctons dans des situations musicales variées26 agrémentées de graphismes ludiques. Certains tableaux soulignent le lien étroit entre geste musical et geste pictural. Ainsi avec Tracys [3,3], le joueur trace des lignes (droites ou courbes) que le plancton suivra en jouant des notes de piano au rythme de la création de ligne. D’autres mettent en scène la dimension labyrinthique et rhizomique de la musique (parcours dans un espace de notes possibles) : avec Luminaria [3,3], plusieurs planctons se déplacent sur une grille faite de nœuds et de liens, chaque lien étant orienté. Le joueur peut changer les connexions entre les nœuds et modifier ainsi les trajectoires des planctons, transformant par là-même les notes émises. D’autres mettent en avant un dispositif proche de ce que nous pourrions appeler une installation sonore : les Hanenbrows [3,2], par exemple, sont projetés dans l’écran et rebondissent sur des feuilles qui produisent une note musicale. En inclinant ces feuilles, le joueur produit des rebonds différents et influe sur les mélodies générées. La fréquence de sollicitation des feuilles modifie leurs couleurs et leurs tonalités. Un tableau comme Nanocarps [3,2], met en scène un ensemble de planctons qui ont leurs comportements et déplacements propres, le son est produit par leurs entrechoquements et l’utilisation du micro permet au joueur de réorganiser leurs mouvements. De même, le tableau Volvoice [3,1] utilise le micro de l’ordinateur pour capturer des sons dont les paramètres (hauteur, vitesse, filtre) peuvent ensuite être modifiés à loisir par la déformation à l’écran du plancton associé. Enfin, le tableau Sun-Animalcule [3,1] propose de déposer des œufs sur l’écran. De la position choisie dépendra la note associée. La lumière d’un cycle jour/nuit fait éclore les œufs qui libèrent leur note associée puis les embryons planctons vont grandir et faire évoluer leur comportement musical.

Figure 12. Moon Tribe

- Note de bas de page 27 :

-

http://www.flyingpuppet.com/

Flying puppet (Nicolas Clauss)27 [3,4] : le site du peintre Nicolas Clauss propose de nombreux « tableaux interactifs » où l’esthétique visuelle y est clairement figurative et où la démarche est de l’ordre d’une expérience multi-sensorielle sans but ni mission. Si l’importance du son y est forte, l’image n’est jamais dans une logique de représentation de ce sonore. Les deux modalités font l’objet d’une autonomie de création et se superposent dans de nouveaux effets de sens. Par exemple, le triptyque Legato, Cellos et Moon tribe met en scène des personnages filaires de danseurs. À partir de ces mêmes éléments graphiques, chacune de ces trois réalisations exploite un aspect musical bien particulier : Legato met en place un mixage de lignes mélodiques sur un thème en boucle, Cellos ordonne différentes mélodies préétablies, Moon tribe permet de synchroniser des boucles rythmiques. La structure même de l’interaction est calquée ou transposée de structures musicales comme l’harmonie, le contrepoint, l’ordonnancement de mélodie, la synchronisation de rythmes. L’image possède sa propre cohérence esthétique et installe des effets de correspondances arbitraires avec le son. De même, chacun des modes, visuel et sonore, possède son propre temps ; les temps de l’animation graphique et le temps musical ne se recouvrant pas toujours parfaitement, ils produisent des décalages des boucles temporelles visuelles et sonores. Le geste ne fusionne pas les deux modes mais les coordonne, il est le point de rencontre, la frontière entre les deux mondes. Si cette relation provoque une fusion sensorielle, elle ne peut être que fugitive, non univoque et soumise aux interprétations variant assez fortement d’un utilisateur à l’autre. Elle n’est pas directement inscrite dans le processus technique mais plutôt réalisée, au détour d’un geste intempestif, comme un plus d’appropriation de l’utilisateur. Impossible ici de savoir si notre geste est guidé par le souci du résultat sonore ou d’une animation visuelle réussie. Nous passons d’une intention à une autre de manière imperceptible, fusionnant ainsi les trois dimensions visuelle, sonore et gestuelle.

Figure 13. Positionnement des exemples dans la typologie

Ces exemples s’intègrent dans notre typologie de la manière suivante : Aura [2,1], SynthPond [2,1], Rez [2,4], Child of Eden [2,4], Metris [2,3], Pasy02 [2,2], Tracys [3,3], Luminaria [3,3], Hanenbrows [3,2], Nanocarps [3,2], Volvoice [3,1], Sun-Animalcule [3,1], Flying puppet [3,4].

7. Construction d’une grille d’analyse des « audio-games »

Outre un tableau de classification de ces nouveaux objets, nous proposons ici quelques pistes de réflexion pour l’élaboration d’une grille d’analyse des « audio-games » :

-

Distinction des relations entre l’image et le son : trois modes de relations se côtoient et glissent de l’un à l’autre dans une même réalisation vidéo-ludique sonore : le son au service de l’image (issue de l’illustration sonore et de l’audiovisuel classique), l’image au service du son (issue de l’informatique musicale où l’image cherche à représenter le son et à le manipuler), l’image et le son dans une relation égale (plus spécifique aux « audio-games » et aux hypermédias) produisant des effets de fusion perceptibles entre les deux modalités.

-

Distinction des modes de déclenchements des sons : avec des sons déclenchés par une intervention directe de l’utilisateur par déplacement de la souris, clic ou survol d’une icône ou manipulation d’image, des sons déclenchés automatiquement par le système sans intervention de l’utilisateur comme les fonds sonores automatiques et enfin des sons déclenchés automatiquement par le système mais liés à une action de l’utilisateur comme, par exemple, à un parcours particulier dans l’application ou à un temps passé sur une interaction. Ces différents modes de déclenchements ont tendance à se parasiter et à provoquer une certaine confusion. Ainsi examiner précisément comment l’auteur gère les mixages intempestifs de ces différentes couches sonores est une piste précieuse pour une analyse détaillée des rapports images/sons dans une situation interactive.

-

Prise en compte du triptyque image/son/geste : qui s’exprime dans la notion de mapping (la transcription d’informations captées dans un registre, le mouvement ou la manipulation graphique, sur un autre registre comme ici le musical). On distingue généralement plusieurs types de mapping : la relation où à un paramètre d’un domaine correspond un paramètre de l’autre (one-to-one), celle où un paramètre d’un domaine est associé à plusieurs paramètres de l’autre (one-to-many), et enfin la relation où, à l’inverse, plusieurs paramètres d’un domaine sont associés à un seul paramètre de l’autre (many-to-one). Dans ces associations multisensorielles, la question du choix des différents paramètres des modalités en jeu et la manière dont ils sont reliés entre eux est primordiale. Nous pouvons, en effet, repérer sur quelles dimensions sonores et visuelles l’interaction s’applique et pour quels effets perceptibles ? Concernant le son : la note (hauteur, durée, intensité), le timbre (enveloppe, fréquence…), les règles de génération du discours musical, le mixage de plusieurs pistes, les paramètres généraux comme le tempo… et à quels paramètres de l’image ceux-ci sont affectés (couleur, forme, opacité, netteté, cadre, niveau d’iconicité…). Quels effets de sens sont produits par ces multiples possibilités de liaisons image/son/geste ?

-

Analyse d’objectifs cognitifs différents : les « audio-games » mettent en place des situations particulières où le geste de l’utilisateur contrôle et produit dans le même temps de l’image et du son tout en participant à une logique supplémentaire, celle du jeu lui-même (détruire des vaisseaux spatiaux pour Rez par exemple, ou agencer des obstacles pour gérer des rebonds de balles pour Elektroplankton). Nous avons vu que cette situation spécifique produit des effets perceptibles complexes où les effets de synchronisation et de fusion de l’image et du son sont démultipliés par le geste et des enjeux cognitifs différents. La grande difficulté sera de relier ces deux niveaux (le jeu et la production musicale) de manière signifiante (ni dans une relation de conflit ni dans une relation trop distante ou anecdotique). L’idéal étant que la couche ludique se transforme en nouveau geste instrumental dans la production du sonore et soit ainsi susceptible de produire de la nouveauté musicale. Pour obtenir un résultat optimal, les règles et les missions du jeu doivent donc éclairer les structures musicales en jeu tout en gardant leur impact et leur cohérence en tant que jeu. On voit bien là, toute la difficulté de cet équilibre souhaité.

Ces nouveaux objets soulignent la nécessité de développer des approches de sémiotiques multimodales pour les analyser, approches qui prennent en compte à la fois le visible, l’audible et le geste.

Quelques outils peuvent nous aider à avancer dans ce sens.

- Note de bas de page 28 :

-

Moles A. (1972). Théorie de l'information et perception esthétique. Denoel-Gonthier, Paris.

- Note de bas de page 29 :

-

Bayle F. (1993). Musique acousmatique : propositions … positions. Buchet Castel, Paris.

- Note de bas de page 30 :

-

MIM, Les UST : éléments nouveaux d'analyse musicale, [MIM 2002], p°18.

- Note de bas de page 31 :

-

Chute, Contracté, Etendue, Elan, En flottement, En suspension, Etirement, Freinage, Lourdeur, Obsessionnel, Par vagues, Qui avance, Qui tourne, Qui veut démarrer, Sans direction par divergence d'information, Sans direction par excès d'information, Stationnaire, Sur l'erre, Suspension-interrogation, Trajectoire inexorable.

- Note de bas de page 32 :

-

Idem p. 36.

-

En 1961, Abraham Moles28 propose une échelle d’iconicité en treize échelons pour classer les images en fonction de leur degré de ressemblance avec l’objet réel représenté. Cet axe progressif part des représentations les plus concrètes et figuratives pour aller vers les représentations les plus éloignées ayant un degré d’abstraction élevé comme les langages naturels ou langages artificiels (mathématiques etc.). Cette échelle d’iconicité peut être appliquée au son en se développant sur deux axes : celui qui va du concret au musical et celui qui va du capté au simulé (synthèse sonore).

-

Inspiré par la sémiotique de Peirce pour l’image, le compositeur François Bayle29 définit trois propriétés du son liées à l’intention d’écoute : l’icone (image isomorphe ou im-son) : l’objet est dénoté par l’ensemble de ses caractères, l’indice (image indicielle ou di-son) : certains traits de l’image dénotent l’objet, le symbole (une métaphore ou mé-son) : l’image représente l’objet par associativité. Ces trois natures de signes débouchent sur trois niveaux d’écoute : celui où les sons s’écoutent comme étant rattachés à des référents directement identifiables de la réalité (qualité : quali-signe) ; celui où la relation est plus abstraite, le son devient un élément significatif de quelque chose. Écoute spécialisée : Les sons s’écoutent comme transformés (filtrage, transposition, insert…), indices d’un travail du compositeur (singularité : syn-signe) ; et enfin, celui où le signe répond à une loi connue qui est en dehors du signe lui-même. (rebond, oscillation…). Écoute tournée vers le sens de l’organisation, de la loi formelle… (stabilité : légi-signe).

-

Conçues au groupe de recherche musicale de Marseille, l’Unité Sémiotique Temporelle est « un segment musical qui, même hors contexte, possède une signification temporelle précise due à son organisation morphologique »30. Dix-neuf UST ont été ainsi répertoriées et nommées par des étiquettes : un mot ou une expression littéraire qui décrit le plus directement possible la manière dont se déploie l’énergie sonore dans le temps31, le plus souvent à l’aide d’une « appellation métaphorique, un qualificatif qui fait référence à quelque chose d’extra musical »32. Cette référence extra-musicale est un premier pont vers une généralisation de ces étiquettes à d’autres modalités. Dans ce sens, on peut souligner que l’ensemble de ces étiquettes fait référence à un mouvement énergétique ou spatial qui les relie naturellement au geste et à l’image.

8. En guise de conclusion: vers quels nouveaux gestes instrumentaux et compositionnels?

- Note de bas de page 33 :

-

Avec des environnements de programmation comme Max-Msp, Pure Data ou encore Usine.

- Note de bas de page 34 :

-

Comme Cubase ou LogicAudio…

- Note de bas de page 35 :

-

Voir l’utilisation des interfaces graphiques sur scène d’un artiste électronique comme Ryoji Ikeda.

Il est difficile aujourd’hui d’anticiper les nouveaux gestes instrumentaux et compositionnels qu’induit ce genre d’applications. Nous pouvons néanmoins souligner qu’elles s’insèrent dans un mouvement général de multiplication de situations d’interactions musicales inédites : les dispositifs temps réel musicaux33 transforment en effet le geste musical en l’augmentant ou le déformant, ce qui a pour effet de décorréler le geste du résultat sonore. De leur côté, les logiciels de composition d’informatique musicale professionnels34 ajoutent de plus en plus fréquemment à leurs représentations « traditionnelles » (partition en clés de Sol et de Fa, grille de données midi, rouleau de piano mécanique, affichage en formes d’onde…) (Vinet, 1999), des représentations en réseau, des simulations physiques (rebonds, nuages de sons…), des automates se déplaçant dans des labyrinthes de notes, des approches ludiques. Les audio-games participent au renouvellement du geste musical et à la représentation du son et de ses structures musicales, ils ouvrent la pratique musicale et compositionnelle à un large public indépendamment du niveau musical de ce dernier, ils permettent de rendre visible et compréhensible le geste musical du musicien sur scène35 et sont susceptibles de transformer le rapport entre l’auditeur et la composition musicale en la rendant explicite par la convivialité de son interface et la jouabilité proposée.