Étude d’une collaboration socio-affective entre une personne et le robot Jazz Study of a socio‐affective interaction between a human and the robot Jazz

Le travail présenté dans cet article porte sur l’étude de situations d’interactions socio-affectives humain-robot dans le contexte d’un jeu collaboratif avec le robot Jazz. Nous présentons tout d’abord les motivations de notre travail autour des compagnons artificiels : notre objectif est de concevoir un robot interactif capable de capter et d’interpréter les attitudes et les émotions exprimées par l’humain et de traduire ces informations contextuelles afin d’adapter son comportement et sa manière de s’exprimer envers la personne. Nous présentons ensuite le dispositif expérimental qui nous a permis de recueillir des données sur les interactions affectives humain-robot. Il comprend une architecture logicielle-matérielle ainsi qu’un modèle simple d’intelligence artificielle. Nous montrons les difficultés de ce type d’expérimentation. Enfin, nous présentons les résultats obtenus et nos perspectives de recherche pour la réalisation d’un robot-compagnon affectif.

This paper studies socio-emotional interaction situations between human users and the Jazz robot, in the context of a collaborative game. First our work is motivated by artificial companions. Ultimately, our goal is to build interactive robots that can interpret attitudes and emotions expressed by humans and adapt their behaviour and expressions based on contextual information. We present the experimental setting that supports the collection of data about human-robot affective interactions. This includes hardware-software architecture as well as simple Artificial Intelligence model. We explore the difficulties that appear in these experimentations. Finally, our results and our research perspectives are presented to highlight our design of an affective companion robot.

1. Introduction

Les recherches en robotique interactive se sont tournées plus récemment vers les robots dits « compagnons » dont le rôle n’est plus simplement d’effectuer une tâche automatique, mais de partager le quotidien des utilisateurs (par exemple pour l’accompagnement des personnes âgées (Wada et al., 2004) ou pour les loisirs (Leite et al., 2008)). Le partage de tâches ou bien encore de décision nécessite la construction, dans les deux sens, d’une relation sociale : l’humain doit accepter le robot, mais pour que cela se produise, il faut aussi que le robot soit capable de simuler un comportement socio-affectif, de reconnaître ses interlocuteurs, de réagir de manière crédible en exprimant des émotions face aux événements de la vie, pour « partager » les expériences et fonder la relation... bref qu’il semble, à son tour, accepter l’humain.

Cette nouvelle dimension ouvre des perspectives de recherches dans le domaine de l’interaction humain-robot (Rosenthal et Veloso, 2010) et plus généralement en interaction humain-machine. Elles reposent sur l’étude de l’intelligence sociale qui se traduit par la capacité à prédire l’état mental d’autrui, de lui attribuer des intentions et des émotions... La réalisation de relations sociales passe par des robots (de type humanoïde ou d’apparence animale, voir (Leite et al., 2008)) qui interagissent de manière naturelle, c’est-à-dire en utilisant la parole et le geste, mais aussi en intégrant les dimensions sociales et affectives de l’interaction (par exemple, l’adaptation du geste à l’interlocuteur et au contexte (Morency, 2010), l’expression d’humeur dans la parole (Robert et al., 2009), la détection d’états affectifs (Moshkina et Arkin, 2009), etc.).

Dans cet article, nous nous intéressons à la prise en compte de cette dimension affective, qui soulève de très nombreux problèmes au niveau

-

mécanique : expression des émotions par le robot (Breazeal, 2003),

-

traitement du signal : reconnaissance des émotions (Yang, 2007) et

-

informatique : modélisation et simulation des émotions (Infantino, 2011).

Nous nous intéressons plus particulièrement à la modélisation de la relation en fonction du contexte social de l’interaction. Notre objectif est de définir un modèle de comportement pour un robot compagnon qui prend en compte une représentation sémantique de l’interaction (construite à partir d’une interprétation de signaux sociaux) en intégrant le contexte socio-affectif, et qui raisonne sur ce modèle pour déterminer la meilleure réaction (vue en termes de sélection d’action pour le robot) sur le plan socio-affectif, dans la situation courante.

Notre travail combine donc deux directions de recherche : d’une part la reconnaissance des émotions et de la situation sociale d’interaction, à l’aide de modèles de traitement du signal (Nicolle et al., 2012) ; d’autre part, la modélisation et le raisonnement sur l’interaction pour la sélection d’une réponse appropriée sur le plan socio-affectif (Campano et al., 2010). Comme nous le verrons dans les sections suivantes, nous avons choisi d’écarter la question de l’interaction langagière, en utilisant des énoncés prédéfinis et un dispositif de type « Magicien d’Oz » masquant l’absence de traitement de la langue.

Le travail présenté dans cet article constitue une première étude autour de la construction d’une relation sociale entre un humain et un robot. En partant d’une situation bien cadrée (un jeu collaboratif entre un humain et un robot Jazz), nous avons constitué un corpus d’interaction socio-affectives et nous avons procédé à une première analyse de ce corpus, qui doit nous permettre à terme de concevoir des algorithmes d’analyse du signal social (Delaherche et al., 2012) et de comportement à base d’intelligence artificielle (Ochs et al., 2010).

La prochaine section présente les travaux du domaine en robotique interactive et en informatique affective. La section 3 présente l’architecture d’interaction et le dispositif expérimental que nous avons mis en place. La section 4 présente nos résultats sur l’analyse du corpus et nos principales conclusions. Nous discutons des perspectives de recherche dans la dernière section.

2. Travaux connexes

La réalisation d’un modèle d’interaction humain-robot capable d’intégrer la dimension affective passe par l’étude de plusieurs problématiques. D’une part, nous devons considérer les mécanismes d’analyse et de reconnaissance de la situation sociale, et en particulier des émotions de l’interlocuteur. D’autre part, nous devons définir une architecture cognitive capable d’utiliser ces informations affectives pour adapter le comportement du robot. Nous présentons dans cette section quelques travaux dans ces deux domaines.

2.1. Traitement du signal social et reconnaissance des émotions

Thomaz propose une architecture qui est capable d’analyser et de comprendre les émotions d’une personne (Thomaz et al., 2005). Cela permet de déterminer l’attention portée par l’utilisateur sur un objet qu’il apprécie ou non. La reconnaissance des émotions d’un humain peut se faire suivant plusieurs modalités. Plusieurs systèmes vont recourir à l’étude des expressions faciales et du ton de la voix pour reconnaître les émotions de la personne, comme (Jung, 2004 ; Yang, 2007) ou (Infantino, 2011). L’avantage de ces méthodes est qu’elles ne requièrent pas de compréhension de la situation par le système, mais peuvent se faire simplement avec des algorithmes de traitement du signal. De plus, la combinaison des différentes sources (Wagner, 2011) peut permettre d’améliorer la qualité de la reconnaissance. Ainsi, Delaherche et al., (2012) ont mené une étude complète des méthodes de reconnaissance de la synchronie dans l’interaction et ils ont montré que la synchronie dans la parole et dans la posture pouvait être un indicateur important de l’engagement social dans l’interaction.

Cependant, d’autres approches ont été proposées pour reconnaître les émotions à partir de motifs. En particulier, les mouvements du corps et les postures semblent fournir des indices importants pour la reconnaissance des émotions (Castellano et al., 2007 ; Meijer, 1989). Au niveau langagier, Breazeal et al. proposent d’utiliser la reconnaissance de mots à caractères émotifs pour l’interaction avec le robot Kismet développé par le MIT Media Lab (Breazeal, 2003). De même, Fleischman et Hovy proposent des marqueurs affectifs pour l’analyse de phrases en langue naturelle (Fleichman et al., 2012). Dans le domaine de la reconnaissance des émotions, des études (Castellano et al., 2007 ; Meijer, 1989) ont été menées sur la reconnaissance des émotions par le mouvement du corps.

Dans cette première étude, nous nous intéressons à la reconnaissance d’émotion à partir de signaux audiovisuels et nous annotons manuellement les vidéos. Réciproquement, et bien que cela ne soit pas l’objet de notre étude, il est nécessaire que le robot puisse exprimer des émotions, afin que l’utilisateur puisse avoir un retour sur le dialogue qu’il entretient avec le robot. Un robot pouvant exprimer des émotions améliorera donc la qualité de l’interaction sociale. Cette expressivité peut se faire de différentes manières en fonction des modalités disponibles sur le robot. La modalité langagière, et donc la sélection des énoncés (Miletitch et al., 2011), est un des moyens d’exprimer un retour affectif à l’utilisateur. Le mouvement du robot (Dang et al., 2011) en est un autre. Sur un robot de type Jazz, où il est possible d’utiliser un écran, nous pouvons nous appuyer sur l’utilisation d’un modèle de visage simple en trois dimensions (Yang, 2007) ou simplement d’un visage avec bouche, yeux et sourcils dont les mouvements permettent d’exprimer des émotions (Breazeal, 2003 ; Ferland et al., 2010).

Enfin, les émotions seront exprimées à travers un mécanisme simple de sélection de phrases prédéfinies.

2.2. Architectures cognitives pour compagnons affectifs

La création d’un robot socio-affectif, au vu du grand nombre de compétences qu’il doit avoir, demande la mise en place d’une architecture cognitive et comportementale très complexe. Le robot doit analyser son environnement à partir de ses capteurs sensori-moteurs, décider quel comportement il va adopter et quelle émotion il va exprimer à partir de ses connaissances et de l’apprentissage qu’il a pu faire pour enfin activer ses moteurs, synthétiser de la parole, etc. Tout ceci devant être effectué durant le court laps de temps disponible durant une interaction avec une personne.

Plusieurs architectures ont pu être développées (BICA, 2011), reposant sur différents prédicats de conception, comme par exemple les architectures symboliques qui reposent sur une approche analytique des symboles de haut niveau de connaissance avec une mémoire à court terme et à long terme (Laird, 2004). Des architectures prenant en compte les émotions dans la boucle décisionnelle existent, un grand nombre d’entre elles reposant sur le modèle de psychologie cognitive PSI où les émotions émergent en fonction de l’analyse de l’environnement, des motivations et de la mémoire du système (Bartl et al., 1998).

Dans notre étude, nous utilisons l’architecture proposée dans l’outil de simulation du contexte socio-émotionnel d’un personnage virtuel, OSSE (Ochs et al., 2010). Ce système permet de créer des agents virtuels munis d’une personnalité qui affecte leur comportement affectif, et d’un modèle de relation sociale qui évolue en fonction des réactions émotionnelles des agents face aux événements du scénario. L’avantage de ce modèle est qu’il permet de représenter les différentes phases de l’interaction et les actions de l’utilisateur ou du robot sur l’environnement comme des événements, dont seront dérivées des réactions affectives et des modifications de la relation sociale.

Dans la prochaine section, nous présentons notre architecture expérimentale dont l’objectif à terme est de combiner reconnaissance des émotions et comportement affectif. La première étape est de recueillir des données en situation et c’est ce que nous présentons dans cet article.

3. Architecture

Afin de mener une expérience scientifique rigoureuse, nous avons développé un scénario d’interaction pouvant être reproduit et mettant en place une situation collaborative entre le sujet et le robot d’une part, mais aussi une situation qui doit posséder un potentiel socio-affectif.

Nous avons ainsi mis en place un jeu reposant sur le principe du Memory : le joueur et le robot doivent se placer sur les cases d’une grille tracée au sol afin de retourner des paires de cartes. L’objectif est de retourner deux cartes identiques et le jeu se termine lorsque toutes les cartes sont découvertes. Pour gagner, le joueur et le robot devront collaborer afin de retourner le plus rapidement possible les cartes formant des paires. Les émotions induites par le succès et l’échec de cette opération ainsi que la part de responsabilité de chacun vont créer la dynamique de relation sociale que nous souhaitons étudier.

Dans un premier temps nous présentons l’architecture générale du scénario pour ensuite développer l’intelligence artificielle créée pour le robot. Puis nous présentons le dispositif expérimental mis en place pour la réalisation des expériences.

3.1. Architecture générale

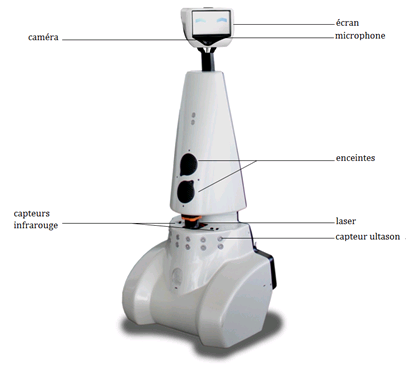

Notre dispositif expérimental est composé d’un robot Jazz, qui se déplace sur la grille tracée au sol, d’une caméra Kinect® qui permet, entre autres, de repérer la position de l’humain sur la grille et d’un ordinateur qui contrôle le robot et suit l’avancement du jeu. Le robot Jazz est essentiellement composé d’une plate-forme mobile sur roues (ce qui lui permet de se déplacer) et d’un pied cônique de 1 mètre de haut surmonté d’un écran de 10 pouces, à hauteur de visage humain. Sans ressembler trop à un humain, il en adopte les dimensions, rendant sa présence plus acceptable par les humains.

Les instructions initiales à l’attention du joueur humain sont affichées sur un téléviseur, qui n’est plus utilisé ensuite, et les résultats des opérations (est-ce que les cartes retournées forment bien une paire) sont énoncées en langue naturelle à travers des enceintes. Le joueur humain est aussi muni d’un jeu de cartes adhésives qu’il peut poser au sol pour mémoriser les paires déjà retournées.

Figure 1a. Robot Jazz

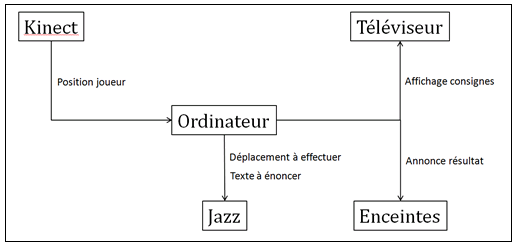

Figure 1b. Architecture schématique du système et transfert d’informations

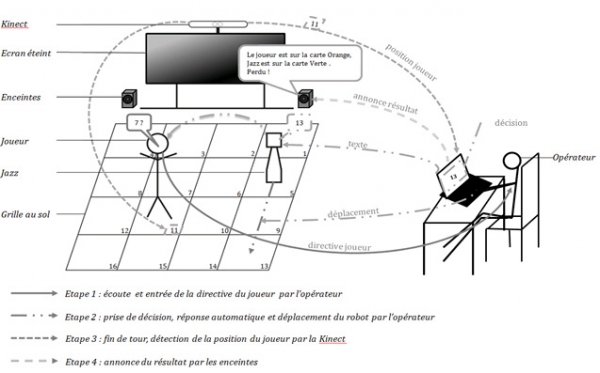

Figure 2. Déroulement du jeu et transfert d’informations. Le joueur humain demande au robot Jazz d’aller sur la case 7. Le robot décide sur quelle case il veut aller, et s’il tient compte de la recommandation de l’humain. Dans notre exemple, il choisit de se rendre sur la case 13 et de le dire à l’humain. Lorsque les deux joueurs (humain et robot) sont positionnés, l’opérateur valide la fin du tour et le système annonce les cartes retournées

Le rôle de l’ordinateur est à la fois de gérer les informations concernant la position du joueur sur la grille, mais aussi de transmettre des données concernant le déplacement du robot, les phrases qu’il doit dire, et d’envoyer le résultat du tour de la partie à des enceintes qui diffuseront une phrase annonçant le résultat. Cette architecture est illustrée sur la figure 1b.

La difficulté du scénario repose sur la communication synchrone entre les différents systèmes, il faut que les informations soient transférées au moment opportun au cours de la partie. Par exemple, la position de joueur ne doit être mesurée qu’à la fin d’un tour, une fois les deux protagonistes correctement placés. Pour faciliter ces transferts, une interface permet à l’opérateur de définir, par exemple, le moment de la fin d’un tour. La figure 2 présente ainsi le déroulement type d’un tour de jeu, avec ses transferts d’informations, entre le moment où le joueur va donner une directive au robot (étape 1) et le moment où le résultat sera annoncé (étape 4).

La compréhension langagière n’étant pas prise en compte dans nos recherches, un Magicien d’Oz a été mis en place : l’opérateur traduit les directives du joueur grâce à une interface opérateur puis il dirige lui-même le déplacement du robot une fois que la décision de déplacement a été prise. Nous présentons dans la section suivante l’intelligence artificielle du robot qui guide son comportement et la sélection de la case destination (transmise à l’opérateur).

3.2. Intelligence artificielle

Une première expérimentation du dispositif nous a permis de régler les modèles de comportement et d’étudier la faisabilité. Dans cette première version du scénario, l’opérateur devait décider quelle direction le robot devait prendre suite à la directive que donnait le joueur, ainsi que la phrase énoncée par le robot. L’ensemble de ces tâches entraîne une surcharge de travail trop importante pour l’opérateur (qui doit aussi déplacer le robot et gérer la fin du tour), diminuant ainsi la fluidité de la partie et créant un comportement soumis pour le robot, l’opérateur choisissant presque toujours de répondre positivement aux directives afin d’être plus efficace.

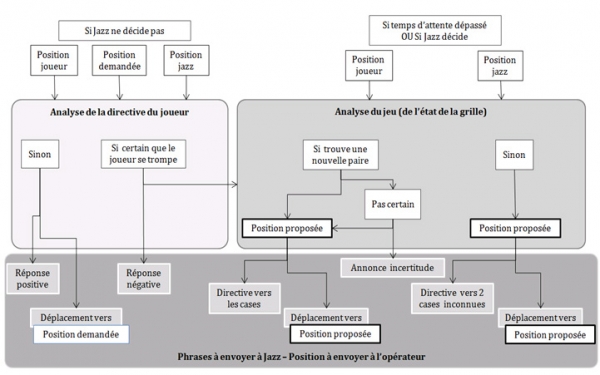

Figure 3. Modélisation de l’intelligence artificielle : comportement durant un tour

Cette première expérimentation nous a aussi permis de comprendre l’importance des phrases énoncées par le robot Jazz : nous avons observé que les joueurs ont tendance à plus exprimer d’émotions lorsque le robot parle, et qu’ils réagissent alors plus souvent aux événements se produisant au cours de la partie.

Nous avons donc développé une intelligence artificielle pour le robot afin d’une part, d’alléger le travail de l’opérateur grâce à un système de prise de décision et, d’autre part, de faire parler systématiquement le robot pour améliorer l’expressivité des joueurs.

Cette intelligence artificielle s’appuie sur une mémorisation imparfaite des cases visitées. Lorsque le robot et le joueur retournent des cartes ne formant pas une paire, les valeurs des cartes sont mémorisées dans un tableau dont chaque case représente la valeur de la carte et le degré de certitude sur cette carte. À chaque tour, les cases ont une probabilité p assez faible (p = 1/10) d’être modifiée aléatoirement et q = 1/5 de perdre en certitude. L’intelligence artificielle du robot se décompose alors en deux parties.

La première partie gère la prise de décision du robot, c’est-à-dire sur quelle case le robot choisit de se diriger. Cette décision dépend de la directive donnée par le joueur, de la capacité de prise de décision du robot (attend-il ou non une directive avant de prendre sa décision) et de sa mémoire. La figure 3 présente ainsi le raisonnement du robot lui permettant de prendre une décision.

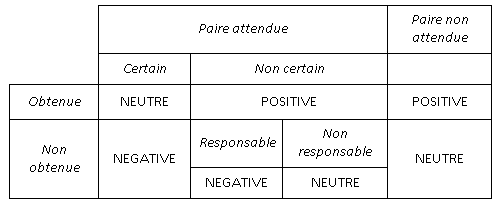

La seconde partie de l’intelligence artificielle permet de faire réagir le robot suite à la découverte des cartes en fin de tour. Sa réaction émotive va dépendre des cartes obtenues, des cartes attendues (selon sa mémoire) et de la responsabilité du robot sur le déplacement (est-ce qu’il a ou n’a pas respecté la directive initiale du joueur ?). Les différentes situations sont illustrées sur le tableau 1.

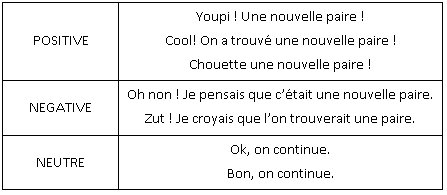

Afin de ne pas lasser le joueur par une trop grande répétitivité des phrases énoncées par le robot, jusqu’à cinq phrases différentes ont été sauvegardées pour chaque réaction, le tableau 2 donne ainsi des exemples de phrases que pourra énoncer le robot en réaction aux différents événements.

Tableau 1. Intelligence artificielle : réactivité aux événements

Tableau 2. Exemple de phrases prononcées en réaction aux événements

3.3. Contraintes du dispositif expérimental

Afin que l’interaction se déroule de la manière la plus naturelle possible et pour permettre de recueillir des données de qualité, plusieurs contraintes se sont imposées au fur et à mesure de la mise en place de l’expérimentation.

Le joueur, placé dans la zone expérimentale, ne voit pas l’écran de l’opérateur, comme le montre la figure 2. Il ne peut donc pas être au courant du contrôle des déplacements du robot et de la traduction de ses directives. Nous faisons croire au joueur que le robot comprend les directives et se déplace seul.

Avant les expérimentations, des directives textuelles sont données au joueur via un écran de télévision. Ces consignes sont volontairement limitées et peu contraignantes afin d’éviter un biais privant le joueur d’une expressivité libre et le conduisant à un comportement non naturel que nous avons pu observer sur des études de calibration.

Nos expériences ont été menées avec des personnes entre 20 et 28 ans. Sur l’ensemble de notre corpus, nous avons pu conserver 9 expérimentations complètes et sans erreur (c’est-à-dire que le robot a fonctionné correctement et que l’opérateur n’a pas eu à intervenir sur le jeu en cours de session). Ces tests ont été réalisées dans une salle expérimentale de l’université Pierre et Marie Curie dans laquelle travaillaient d’autres personnes mais nous n’avons pas constaté de biais particulier, le joueur restant concentré sur sa tâche et interagissant uniquement avec Jazz, à l’exclusion de toute autre personne (y compris l’opérateur).

4. Expérimentations et résultats

4.1. Objectifs et études préliminaires

Notre objectif principal est d’étudier les émotions (joie, colère, surprise...) exprimées par le joueur humain au cours du jeu, en fonction des différentes situations rencontrées, ainsi que le développement d’une forme de relation sociale (repérable à travers des indices de comportement social envers le robot).

Nous avons tout d’abord mené une série d’expérimentations préliminaires ne faisant intervenir que des joueurs humains (sans robot Jazz). Cela nous a permis de mettre en évidence certaines propriétés de l’interaction en situation de jeu collaboratif que nous avons prises en compte dans notre étude avec le robot Jazz :

-

La présence d’un écran allumé réduit considérablement les interactions sociales entre les participants, ces derniers étant focalisés par ce qui se déroulait sur l’écran. C’est ce qui nous a conduits à annoncer les cartes via les haut-parleurs (audio) plutôt que de reproduire la grille sur l’écran (visuel). Les consignes du jeu restent présentées sur l’écran afin que tous aient les mêmes informations en début de partie.

-

Les joueurs humains mettent en place des stratégies d’exploration de la grille (par exemple, par paires de cartes en partant d’un coin et en suivant les rangées). Nous avons ainsi pu créer une stratégie d’exploration similaire sur le robot afin qu’il ait une méthode de jeu cohérente, qui corresponde à la manière la plus naturelle de résoudre le jeu.

-

Les émotions exprimées par les joueurs humains sont directement corrélées avec les événements survenus au cours de la partie (découverte d’une carte ou non, obéissance ou résistance de l’autre joueur, etc.). Ceci nous a permis d’associer les réactions du robot aux événements de la partie.

-

Les joueurs humains ont tendance à obéir aux directives de l’autre joueur (humain ou robot).

-

Les événements (succès ou échec attendu ou non) génèrent des émotions qui sont effectivement exprimées.

4.2. Étude de la relation humain-robot

Nous avons annoté les neufs vidéos obtenues de nos expériences d’interaction humain-robot et nous en avons étudié plusieurs dimensions que nous détaillons ci-après.

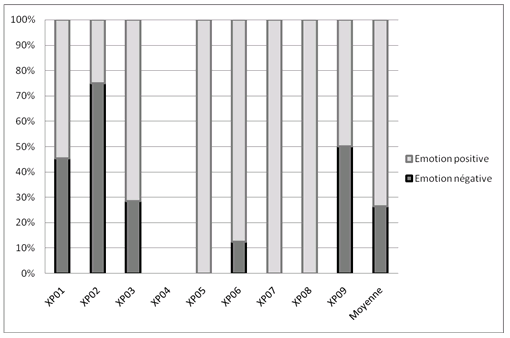

La figure 4 montre le rapport d’autorité entre l’humain et le robot, défini comme le nombre de fois où l’humain a accepté de suivre une directive imposée par le robot (que celle-ci soit cohérente ou non par la situation de jeu, notre intelligence artificielle étant conçue pour se tromper). Nous avons observé dans le cas général le même phénomène que dans les expérimentations préliminaires : les humains ont tendance à suivre les directives du robot, parfois même alors qu’ils pensent qu’elles sont erronées. Toutefois, certains joueurs n’apprécient pas d’être commandés par le robot (en particulier dans l’expérimentation XP09) et cherchent systématiquement à prendre le contre-pied de ses instructions.

Ces résultats tendent à montrer que la construction de la relation sociale (et en particulier la relation de dominance) entre l’humain et le robot ne suit pas un schéma différent de celui observé en interaction humain-humain. Les joueurs humains invectivent et s’adressent au robot comme ils le feraient avec un autre humain. Toutefois, notre étude ne permet pas de montrer la dynamique de la relation de confiance : il est possible que dans un contexte moins ludique, l’humain accepte moins facilement de suivre les conseils du robot-compagnon.

Figure 4. Rapport du nombre d’obéissance et de résistance du robot par rapport au nombre total de directives données par le robot au cours de chaque expérience

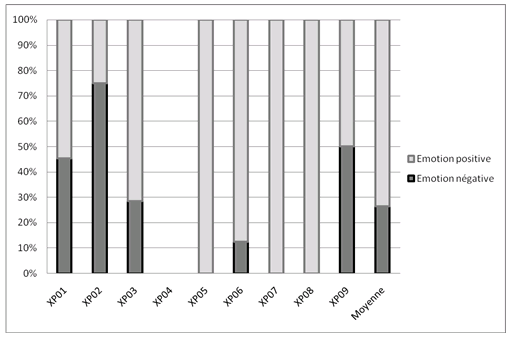

Nous nous sommes aussi intéressés aux émotions exprimées par les humains dans l’interaction. La figure 5 présente les valences d’émotions exprimées par les joueurs. Nous avons annoté manuellement dans toutes les vidéos (sauf pour l’expérimentation XP04 où aucune émotion n’a été exprimée) les expressions d’émotions positives, comme la joie et la surprise ainsi que les expressions d’émotions négatives telles que la colère ou la déception pour chaque événement du jeu.

Nous avons pu constater qu’une émotion est exprimée pour environ 10 % des événements survenus au cours d’une partie (et détectable manuellement sur la vidéo). Nous pouvons alors comparer les proportions d’émotions dans les interactions pour chaque expérimentation et nous remarquons que les émotions positives sont largement plus présentes. En comparant avec des conditions expérimentales où le robot n’exprimait pas d’émotion (le robot se contente d’annoncer les résultats et de suivre les consignes du joueur humain), nous avons constaté que l’expressivité du robot sur chaque événement renforçait l’expression d’émotions chez le joueur humain. Le joueur va avoir tendance à exprimer une émotion si le robot s’exprime lui-même.

Figure 5. Type d’émotions exprimées au cours de chaque expérience. Absence de résultat pour XP04, aucune expression faciale n’ayant été visible

L’expression d’émotion étant un facteur clé de la construction de relation sociale (Rosenthal et al., 2010), nos résultats semblent démontrer que l’humain tente effectivement de construire une relation sociale avec le robot, et que les feedbacks du robot participent effectivement à la construction de cette relation.

5. Conclusion et perspectives

Nous avons présenté dans cet article une étude de situations d’interactions socio-affectives humain-robot dans le contexte d’un jeu collaboratif. Nous avons porté une attention toute particulière aux émotions exprimées par l’utilisateur humain au cours d’un jeu collaboratif avec un robot mobile, comme la joie (lorsque qu’une paire est trouvée), la colère ou la déception (lorsque le robot est la cause d’une erreur de l’équipe). L’analyse du corpus d’interactions socio-affectives montre que les événements du scénario suscitent effectivement des émotions chez l’humain. La relation sociale établie se traduit majoritairement par une obéissance de l’humain en réponse aux directives du robot.

Cette première étude nous a permis de développer une plate-forme d’analyse de relations socio-affectives entre un humain et un robot mobile sur la base d’un jeu collaboratif. Plusieurs améliorations sont envisagées dont notamment l’augmentation du nombre d’humains participant à l’étude (9 pour l’instant) ou encore la disposition de l’opérateur, qui est actuellement dans la même salle expérimentale. La relation créée entre l’humain et le robot est en effet parfois ténue, celle-ci pouvant être rapidement perturbée par la présence d’un écran, de l’opérateur ou d’une autre personne. Il faudra donc améliorer cette relation par le déplacement de l’opérateur, mais aussi par le renforcement de la dimension affective de la relation.

Celle-ci sera renforcée par une plus grande expressivité du robot. Cette expressivité est actuellement limitée à la production verbale de phrase et sera enrichie par une tonalité ou encore des expressions faciales.

L’analyse automatique du comportement humain se focalisera sur la reconnaissance d’émotions en exploitant des modèles issus du traitement du signal social. Cette analyse sera combinée avec un outil d’évaluation du contexte de jeu et des émotions pour adapter l’expressivité du robot.